UFLDL Tutorial深度学习基础——学习总结:稀疏自编码器(一)神经网络(neural networks)

2018-03-13 13:53

751 查看

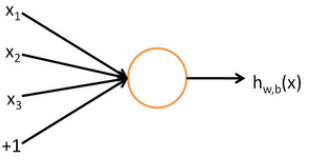

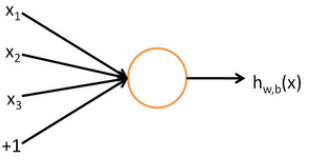

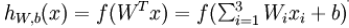

1、神经元:

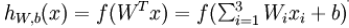

输入:x1 x2 x3 和截距+1输出:

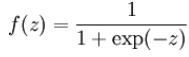

激活函数(activation function):f(·) 主要作用是提供网络的非线性建模能力,使深度神经网络具备分层的非线性映射学习能力。

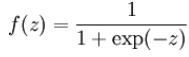

常见的激活函数有:sigmoid函数:

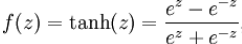

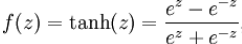

双曲正切函数(tanh)(hyperbolic tangent):

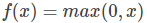

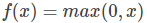

ReLU函数:

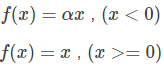

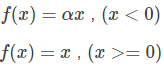

Leaky-ReLU函数:

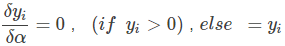

P-ReLU(Parametric ReLU)函数:

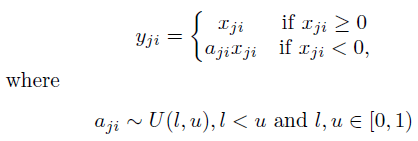

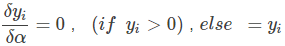

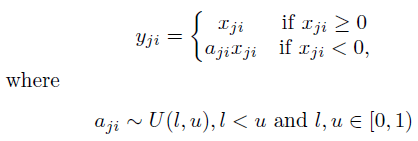

R-ReLU(Randomized ReLU)函数:

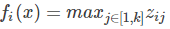

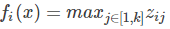

Maxout函数:

(激活函数参考:http://blog.csdn.net/cyh_24/article/details/50593400) 一个神经元的输入输出映射关系其实就是一个逻辑回归(logistic regression)(实际是一种分类方法,主要用于分类问题。)2、神经网络模型

圆圈代表输入;+1圆圈代表偏置节点(截距项)(bias units);最左边的一层为输入层;最右边的一层为输出层;中间的所有节点组成隐藏层(不能在训练样本中观测到他们的值)。上图有三个输入单元,一个输出单元,三个隐藏单元,一个偏置单元。

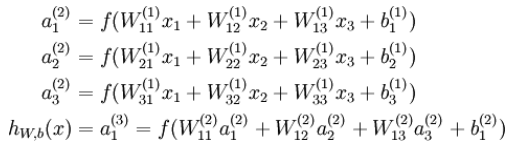

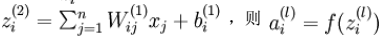

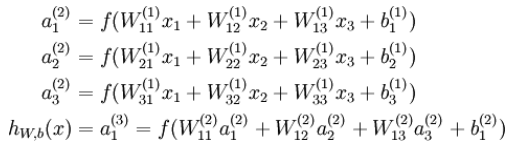

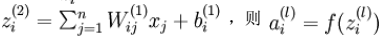

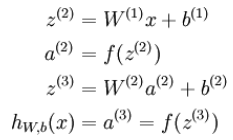

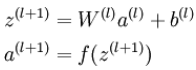

为第l层第i单元的激活值(输出值)(activation)。本神经网络的计算步骤:

表示第l层第i单元的输入加权和(包括偏执单元)。

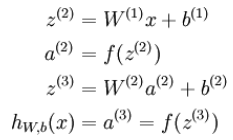

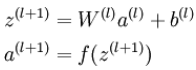

前向传播(forward propagation):

,

输入:x1 x2 x3 和截距+1输出:

激活函数(activation function):f(·) 主要作用是提供网络的非线性建模能力,使深度神经网络具备分层的非线性映射学习能力。

常见的激活函数有:sigmoid函数:

双曲正切函数(tanh)(hyperbolic tangent):

ReLU函数:

Leaky-ReLU函数:

P-ReLU(Parametric ReLU)函数:

R-ReLU(Randomized ReLU)函数:

Maxout函数:

(激活函数参考:http://blog.csdn.net/cyh_24/article/details/50593400) 一个神经元的输入输出映射关系其实就是一个逻辑回归(logistic regression)(实际是一种分类方法,主要用于分类问题。)2、神经网络模型

圆圈代表输入;+1圆圈代表偏置节点(截距项)(bias units);最左边的一层为输入层;最右边的一层为输出层;中间的所有节点组成隐藏层(不能在训练样本中观测到他们的值)。上图有三个输入单元,一个输出单元,三个隐藏单元,一个偏置单元。

为第l层第i单元的激活值(输出值)(activation)。本神经网络的计算步骤:

表示第l层第i单元的输入加权和(包括偏执单元)。

前向传播(forward propagation):

,

相关文章推荐

- UFLDL Tutorial深度学习基础——学习总结:稀疏自编码器(三)梯度检验与高级优化

- UFLDL Tutorial深度学习基础——学习总结:稀疏自编码器(二)反向传播算法(Backpropagation Algorithm)

- 深度学习:自编码器、神经网络基础

- 深度学习DeepLearning.ai系列课程学习总结:2. 神经网络基础

- ufldl 深度学习入门 第一发:基于BP网络实现稀疏自编码器

- 深度学习笔记:稀疏自编码器(1)——神经元与神经网络

- 循环神经网络(RNN, Recurrent Neural Networks)学习笔记:基础理论

- 深度学习之自编码器和多层神经网络

- Neural Networks and Deep Learning 神经网络和深度学习book

- 深度学习基础(二):简单神经网络,后向传播算法及实现

- 零基础入门深度学习(5) - 循环神经网络

- 零基础入门深度学习(3) - 神经网络和反向传播算法

- 深度学习基础(三)(稀疏)自编码器

- 深度学习基础(五):循环神经网络概念、结构及原理实现

- 【深度学习 论文综述】深度神经网络全面概述:从基本概念到实际模型和硬件基础

- 深度学习之卷积神经网络总结

- 深度学习基础1(神经网络)

- 神经网络和深度学习-学习总结

- 深度学习基础(三)(稀疏)自编码器 分类: 深度学习 2015-01-20 15:19 96人阅读 评论(0) 收藏

- 深度神经网络入门教程Deep Neural Networks: A Getting Started Tutorial