机器学习之梯度提升决策树GBDT

2018-01-25 09:19

453 查看

简单易学的机器学习算法——梯度提升决策树GBDT

GBDT(Gradient Boosting Decision Tree)

通俗来说不是很好说,我这里简单说说两者的相同点和不同点。相同点:模型都是加法模型、学习算法都是前向分布算法;每一步都需要训练一个弱分类器来弥补上一轮弱分类器的不足。不同点:Adaboost是新的弱学习器拟合不同权值或概率分布训练样本,而Gradient Boost是新的弱学习器拟合损失函数的负梯度在上一个模型的值。梯度提升树(回归树)的算法与原始的提升树(回归树)算法的核心区别主要在于残差计算这里,由于原始的回归树指定了平方损失函数所以可以直接计算残差,而梯度提升树针对一般损失函数,所以采用负梯度来近似求解残差。

作者:大器不早成

链接:https://www.zhihu.com/question/54332085/answer/281676652

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

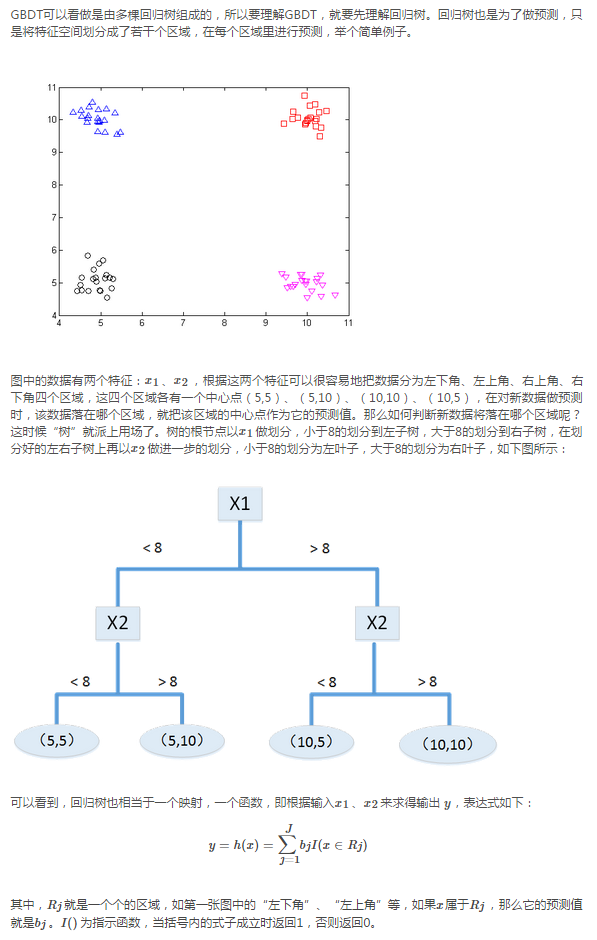

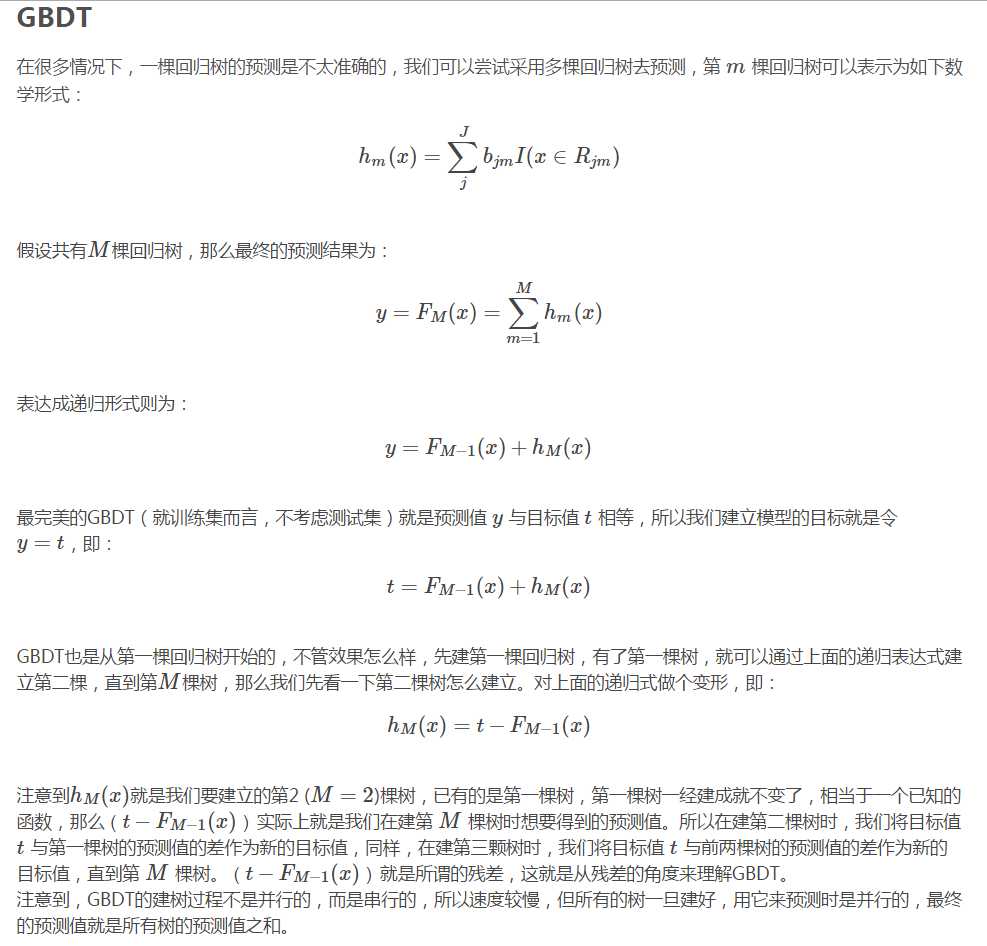

回归树

GBDT(Gradient Boosting Decision Tree)

Boosted Tree:一篇很有见识的文章

https://www.zhihu.com/question/54332085

AdaBoost与GBDT的区别通俗来说不是很好说,我这里简单说说两者的相同点和不同点。相同点:模型都是加法模型、学习算法都是前向分布算法;每一步都需要训练一个弱分类器来弥补上一轮弱分类器的不足。不同点:Adaboost是新的弱学习器拟合不同权值或概率分布训练样本,而Gradient Boost是新的弱学习器拟合损失函数的负梯度在上一个模型的值。梯度提升树(回归树)的算法与原始的提升树(回归树)算法的核心区别主要在于残差计算这里,由于原始的回归树指定了平方损失函数所以可以直接计算残差,而梯度提升树针对一般损失函数,所以采用负梯度来近似求解残差。

作者:大器不早成

链接:https://www.zhihu.com/question/54332085/answer/281676652

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

梯度提升树(GBDT)原理小结

从回归树到GBDT

http://blog.csdn.net/zqxnum1/article/details/44337557回归树

相关文章推荐

- 机器学习总结(四)——随机森林与GBDT(梯度提升决策树)

- Spark2.0机器学习系列之6:GBDT(梯度提升决策树)、GBDT与随机森林差异、参数调试及Scikit代码分析

- Spark2.0机器学习系列之5:GBDT(梯度提升决策树)、GBDT与随机森林差异、参数调试及Scikit代码分析

- GBDT:梯度提升决策树

- GBDT--梯度提升决策树

- GBDT:梯度提升决策树

- GBDT(梯度提升决策树)算法(详细版)

- 机器学习方法篇(9)------梯度提升决策树GBDT

- 简单易学的机器学习算法——梯度提升决策树GBDT

- 【机器学习】GBDT梯度下降提升算法及参数寻优实例

- GBDT:梯度提升决策树

- GBDT(梯度提升决策树)剖析

- GBDT:梯度提升决策树

- GBDT:梯度提升决策树

- GBDT-沿着梯度提升的决策树

- Gradient Boosting Decision Tree(GBDT)-梯度提升决策树

- 【ML笔记】梯度提升决策树(GBDT)和随机森林(RF)的异同

- GBDT 梯度提升决策树笔记

- GBDT 梯度提升决策树

- GBDT:梯度提升决策树