Hadoop入门之WordCount(windows+hadoop2.8.1)

2017-10-19 12:13

423 查看

参考文章:

http://blog.csdn.net/lifeifei2010/article/details/69396332

http://blog.csdn.net/xiaoxiangzi222/article/details/52757168

……

首先开启Hadoop服务(参照上一篇博客)

接下来:

http://blog.csdn.net/lifeifei2010/article/details/69396332

http://blog.csdn.net/xiaoxiangzi222/article/details/52757168

……

首先开启Hadoop服务(参照上一篇博客)

接下来:

1.进入hadoop的bin目录 在hdfs上创建一个新文件夹 hdfs dfs -mkdir -p /data/input 2.将当前目录中的某个txt文件复制到hdfs中(我复制的LICENSE.txt, 注意要确保当前目录中有该文件) hdfs dfs -put LICENSE.txt /data/input 3.查看hdfs中是否有我们刚复制进去的文件 hdfs dfs ls /data/input

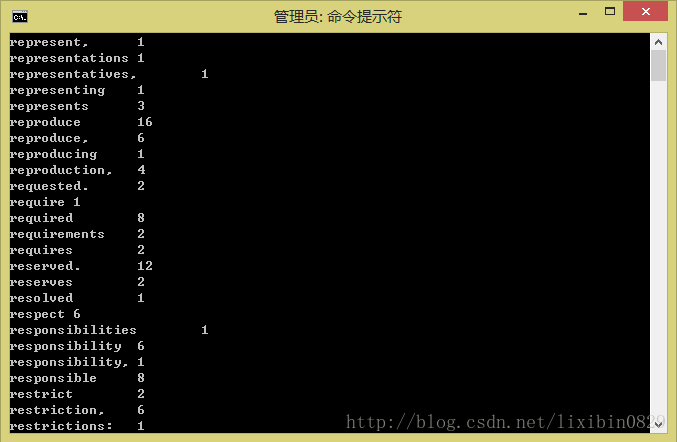

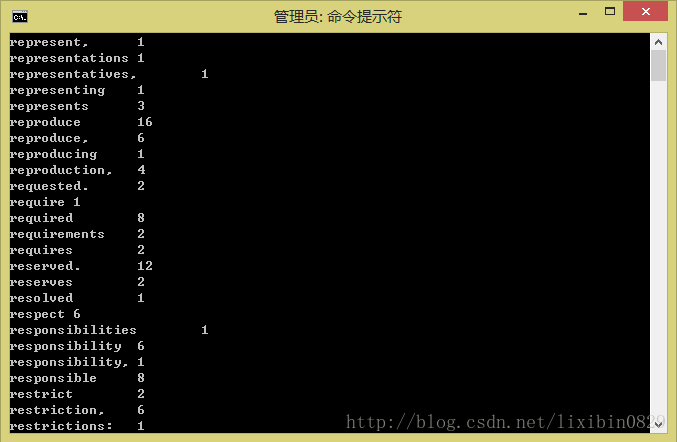

4.进入share的上层目录,提交单词统计任务 hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.8.1.jar wordcount /data/input /data/output/result 接着就会进行map和reduce 5.查看结果 hdfs dfs -cat /data/output/result/part-r-00000

OK,成功!

相关文章推荐

- hadoop入门学习系列之五Eclipse下搭建Hadoop2.6.5开发环境并写wordcount

- hadoop入门(WordCount实例详解)

- Hadoop入门实例——WordCount统计单词

- hadoop入门之wordcount学习

- Hadoop入门案例(一) wordcount

- Hadoop入门-WordCount示例

- hadoop wordcount入门

- Hadoop入门经典:WordCount 分类: A1_HADOOP 2014-08-20 14:43 2514人阅读 评论(0) 收藏

- Hadoop入门经典:WordCount

- 知识学习——Hadoop MapReduce开发入门程序WordCount详解

- Windows下Cygwin环境的Hadoop安装(3)- 运行hadoop中的wordcount实例遇到的问题和解决方法

- hadoop2.7.3 Windows eclipse开发环境搭建及WordCount实例运行

- Hadoop入门经典:WordCount

- Hadoop入门实践之从WordCount程序说起

- Hadoop MapReduce编程 API入门系列之wordcount版本5(九)

- 在windows上用eclipse远程运行hadoop上的wordcount程序出现的问题,求解决

- Hadoop入门经典:WordCount

- (HADOOP入门)mapreduce入门程序wordcount旧版API

- Hadoop MapReduce编程 API入门系列之wordcount版本2(六)

- MapReduce编程入门实例之WordCount:分别在Eclipse和Hadoop集群上运行