CS229机器学习个人笔记(3)——Logistic Regression+Regularization

2017-09-17 20:05

281 查看

1.Classification

Logistic Regression其实就是Classification,但是由于历史原因名字被记作了逻辑回归。它与线性回归的区别在于hθ(x)被限制在了0与1之间,这是通过下面的S函数(Sigmoid function)实现的:g(z)=11+e−z其中:z=θTx

此时我们的假设函数hθ(x)=g(θtx)=11+e−θTx

2.Cost Function

线性回归中的损失函数是:J(θ0,θ1…θn)=12m∑i=1m(hθ(x(i))−y(i)))2

其中:hθ(x)=θ0+x1θ1+x2θ2+⋯+xnθn

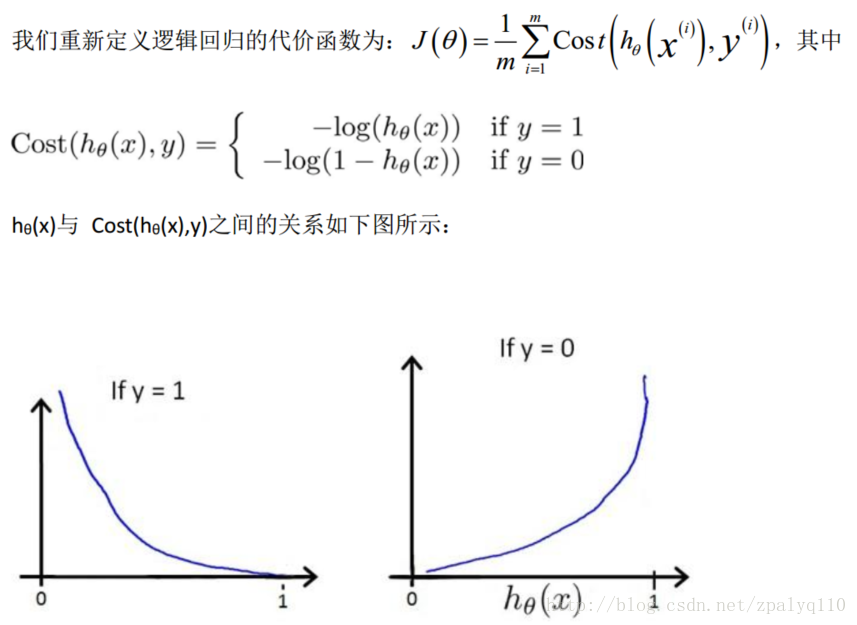

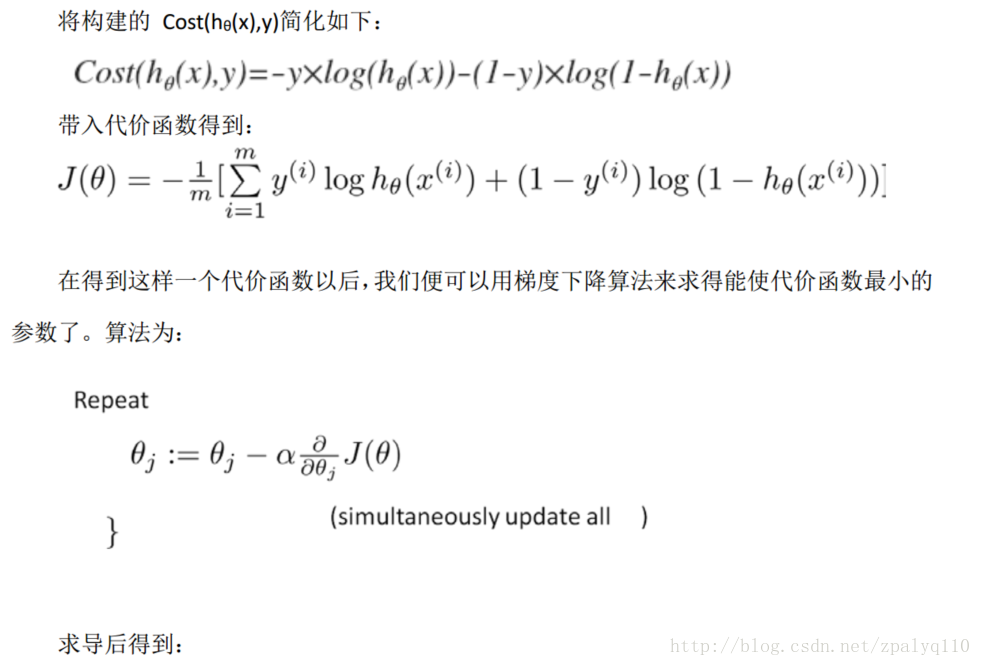

线性回归损失函数有很明显的实际意义,就是平方损失。而逻辑回归却不是,它的预测函数hθ(x)明显是非线性的,如果类比的使用线性回归的损失函数于逻辑回归,那J(θ)很有可能就是非凸函数,即存在很多局部最优解,但不一定是全局最优解。我们希望构造一个凸函数,也就是一个碗型函数做为逻辑回归的损失函数。

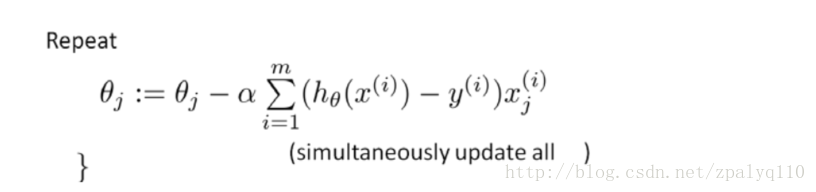

注: 虽然得到的梯度下降算法表面上看上去与线性回归的梯度下降算法一样, 但是这里的 hθ(x)=g(θTX)与线性回归中不同, 所以实际上是不一样的。 另外, 在运行梯度下降算法之前,进行特征缩放依旧是非常必要的。

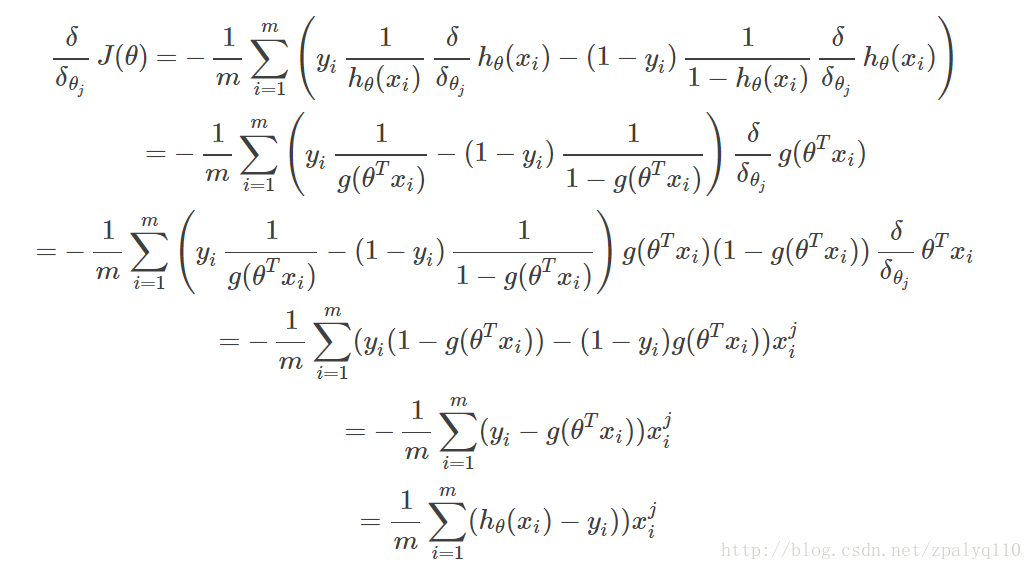

具体求导公式的推导:

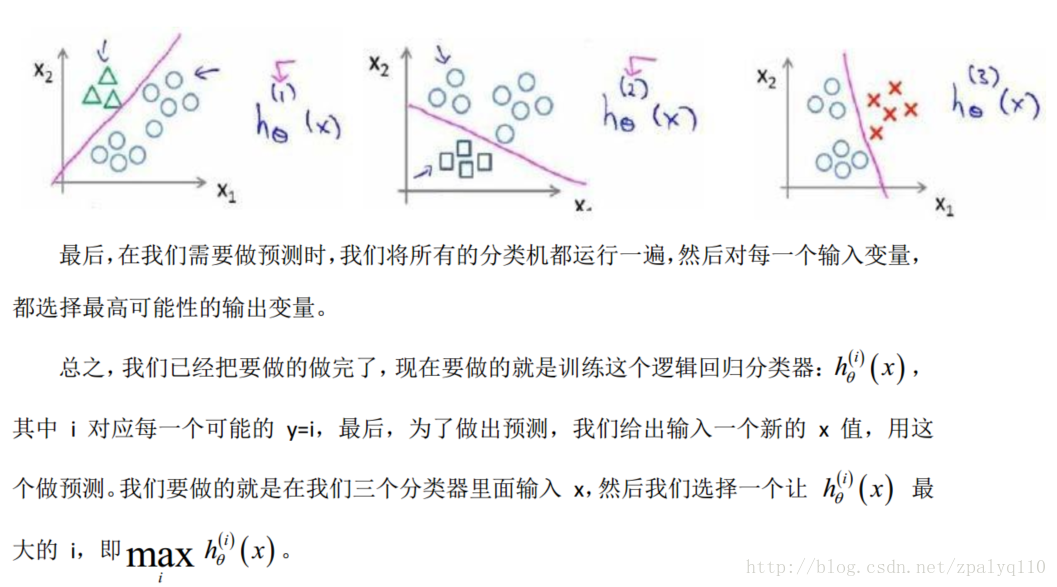

3.Multiclass Classification-One-vs-all

4.Regularization

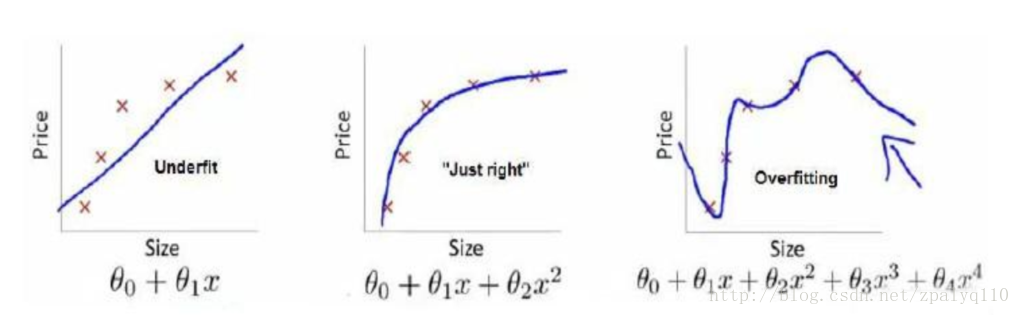

线性回归中的Overfitting与Underfitting:

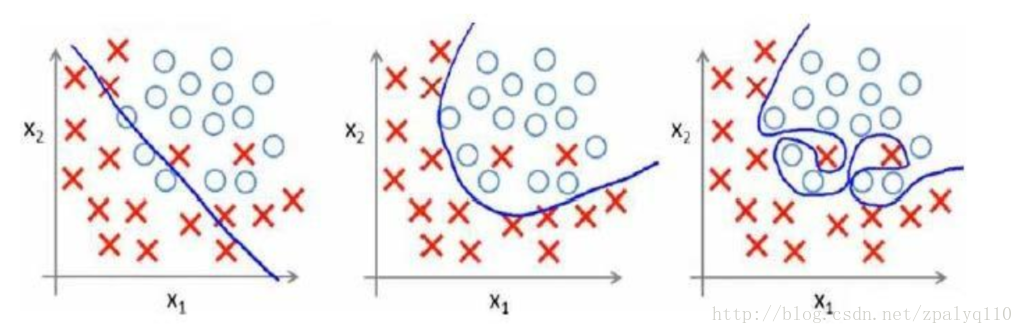

逻辑回归中的Overfitting与Underfitting:

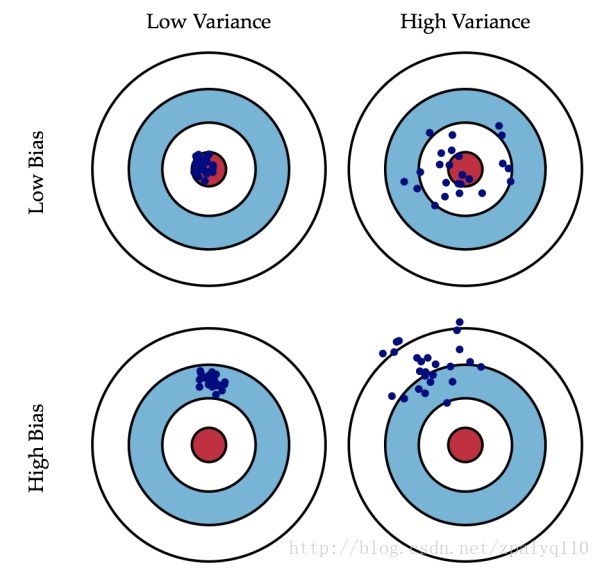

Overfitting:高偏差

Underfitting:高方差

下图很直观的展现出偏差与方差的区别:

怎么来解决过拟合的问题?简单来说造成过拟合是因为次数高的项存在,那么只要减小相应的系数θ就能避免过拟合。

对于线性回归:

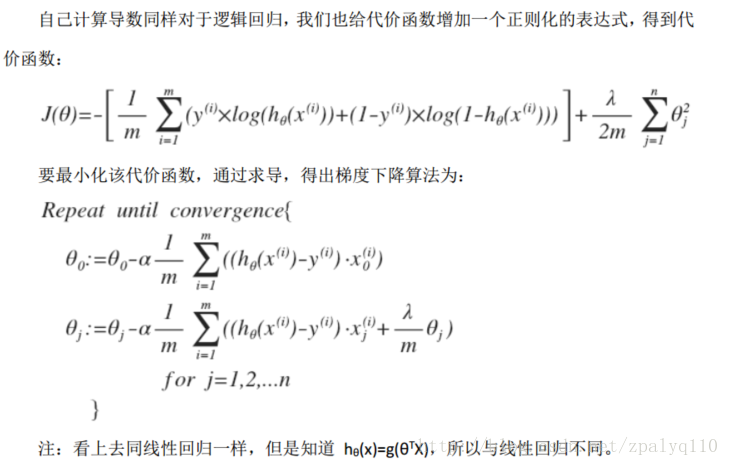

对于逻辑回归:

相关文章推荐

- CS229机器学习个人笔记(2)——Linear Regression with Multiple Variables

- Coursera-吴恩达-机器学习-(第3周笔记)Logistic Regression and Regularization

- CS229机器学习个人笔记(1)——Linear Regression with One Variable

- Machine Learning 03 - Logistic Regression and Regularization

- Andrew Ng Machine Learning 专题【Logistic Regression & Regularization】

- Stanford机器学习---第三讲. 逻辑回归和过拟合问题的解决 logistic Regression & Regularization

- 【LR学习笔记】Parallel Large Scale Feature Selection for Logistic Regression_2009

- Stanford机器学习---第三讲. 逻辑回归和过拟合问题的解决 logistic Regression & Regularization

- 林轩田之机器学习课程笔记( embedding numerous feature之 kernel logistic regression)(32之21)

- machine learning(15) --Regularization:Regularized logistic regression

- 【学习笔记】WEEK2_Logistic Regression as a Neural Network_Derivatives with a Computation Graph

- 【学习笔记】WEEK2_Python and Vectorization_Vectorizing Logistic Regression's Gradient Output

- 【Stanford机器学习笔记】3-Logistic Regression for Classification

- Stanford机器学习网络课程---第三讲. 逻辑回归和过拟合问题的解决 logistic Regression & Regularization

- Theano-Deep Learning Tutorials 笔记:Classifying MNIST digits using Logistic Regression

- 【学习笔记】WEEK2_Logistic Regression as a Neural Network_Logistic Regression Cost Function

- Stanford机器学习-- 逻辑回归和过拟合问题的解决 logistic Regression & Regularization

- (原创)Stanford Machine Learning (by Andrew NG) --- (week 3) Logistic Regression & Regularization

- 机器学习算法笔记1_2:分类和逻辑回归(Classification and Logistic regression)

- Regression(4)-------Logistic Regression & Regularization