Unsupervised Domain Adaptation by Backpropagation(2015)

2017-09-06 20:03

519 查看

Introduction

论文作者希望网络学习由discriminativeness(分歧,应该是source domain和target domain的区别吧)和domain-invariance组合起来的隐藏特征(underlying feature)通过同时优化以下两个discriminative classifiers来实现

label predictor预测分类标签(训练与测试的时候)

domain classifier用于区分数据来自source domain还是target domain

优化 underlying deep的参数会最小化**label predictor的损失,最大化**domain classifier的损失,最大化domain classifier是为了鼓励在优化过程中出现域不变特征(domain invariant features)。

加上一个特征提取的训练过程,一共是三个训练过程,都可以被嵌入到一个适当的深度前馈网络(deep feedforward network)中,可以使用随机梯度下降+动量法(SGD with momentum)进行训练。

- 注解:GRL(Gradient Reversal Layer,梯度反转层),用于保留原有输入但是在梯度下降时反转梯度。对于对于某个函数

f(u),GRL定义了一个函数G:

作者不是通过MMD而是使用基于深度学习的判别式分类器(discriminatively-trained classifier),利用source domain和target domain各自私有的特性,来计算他们之间分布的差异。并且作者不是通过修改权重或者对数据分布做几何变换来匹配特征空间的分布,而是通过修改source domain和target domain产生的特征表示来进行。

算法与网络

定义:

source domain满足分布S(x,y),target domain满足分布T(x,y)

域标签(domain label)di

特征提取器(feature extrator)f=Gf(x;θf),分类器(label predictor)Gy(;θy),域分类器(domain classfier)Gd(;θd)

训练过程:

先训练使得参数θf能够最大化domain classfier loss(混淆),以保证提取的特征是 domain-invariant feature。这里作者也拿分类器的参数θy一起训练的

之后训练域分类器的参数θd最小化domain classfier loss

Optimization with backpropagation

作者引入了梯度反转层gradient reversal layer (GRL) 来实现上述优化的SGD(因为参数−λ的存在,这个式子不能用SGD直接实现)

在前向传播( forward

propagation)的过程中,GRL是个恒等变换

在backpropagation阶段,GRL从后一层获取梯度,乘以−λ后再传给前一层

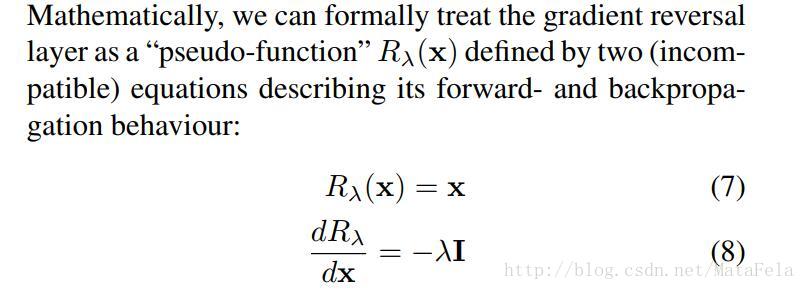

以“假函数”(pseudo-function)的表示GRL如下:

最终函数被修改为:

experiment

相关文章推荐

- 笔记:unsupervised domain adaptation by backpropagation

- What is meant by back propagation in an ANN compared to a biological neural network?

- Unsupervised Domain Adaptation with Residual Transfer Networks(2017)

- 神经网络之后向传播分类(Classification by Backpropagation)

- 【深度学习】论文导读:无监督域适应(Deep Transfer Network: Unsupervised Domain Adaptation)

- A Step by Step Backpropagation Example阅读笔记

- Deep Transfer Network: Unsupervised Domain Adaptation

- [cvpr2017]Deep Hashing Network for Unsupervised Domain Adaptation

- A Step by Step Backpropagation Example

- [cvpr2017]Domain Adaptation by Mixture of Alignments of Second- or Higher-Order Scatter Tensors

- Just DIAL: DomaIn Alignment Layers for Unsupervised Domain Adaptation

- 论文解读-<Unsupervised Domain Adaptation with Residual Transfer Networks>

- Maximum Classifier Discrepancy for Unsupervised Domain Adaptation

- 【CV】ICCV2015_Unsupervised Visual Representation Learning by Context Prediction

- 笔记:Deep transfer network: unsupervised domain adaptation

- Deep learning---------------Back propagation Algorithm(BP algorithm)

- UFLDL Tutorial深度学习基础——学习总结:稀疏自编码器(二)反向传播算法(Backpropagation Algorithm)

- 笔记:Semi-supervised domain adaptation with subspace learning for visual recognition (cvpr15)

- 【转】Principles of training multi-layer neural network using backpropagation

- 【转】BP算法浅谈(Error Back-propagation)