集群 Ricci&&luci Fence机制

2017-07-30 00:36

302 查看

一 Ricci&&luci

Server1和server4做同样的操作,

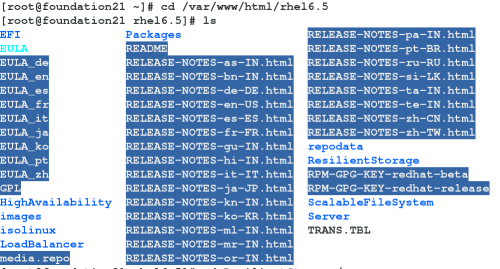

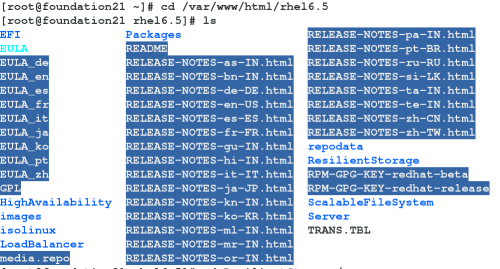

(1)配置yum 源

[HighAvailability]name=HighAvailabilitybaseurl=http://172.25.21.250/rhel6.5/HighAvailabilitygpgcheck=0[LoadBalancer]name=LoadBalancerbaseurl=http://172.25.21.250/rhel6.5/LoadBalancergpgcheck=0[ResilientStorage]name=ResilientStoragebaseurl=http://172.25.21.250/rhel6.5/ResilientStoragegpgcheck=0[ScalableFileSystem]name=ScalableFileSystembaseurl=http://172.25.21.250/rhel6.5/ScalableFileSystemgpgcheck=0

参数来源截图:

(2)安装服务

安装 ricci :使用 luci 配置集群要求在集群节点中安装并运行 ricci,使用 ricci 需要一个密码,您在创建集群时需要为每个集群节点输入该密码。在启动 luci 前,请确定您集群节点中的 IP 端口允许任意与 luci 沟通的节点中的luci 服务器到端口

11211 的连接。

要使用 Conga 管理红帽高可用性附加组件,请安装并运行 luci,如下:

1. 选择托管 luci 的主机,并在那台计算机中安装luci 软件通常是服务器架或者托管 luci 的数据中心的一台计算机中,但集群计算机也可托管 luci。

2. 使用 service luci start 启动 luci。例如:

注意 :从红帽企业版Linux 6.1 开始,您可以使用/etc/sysconfig/luci 文件配置 luci 行为的某

些方面,包括端口和主机参数,

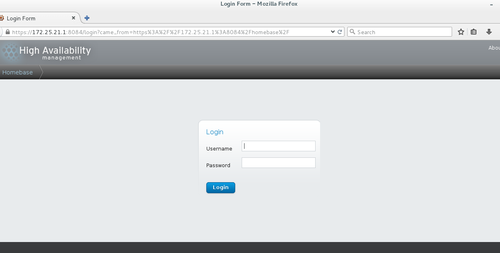

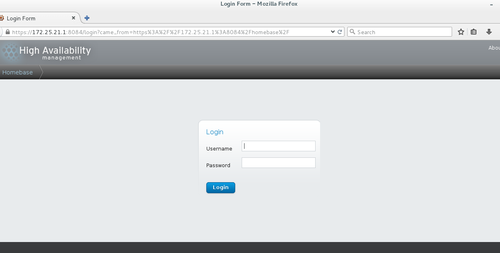

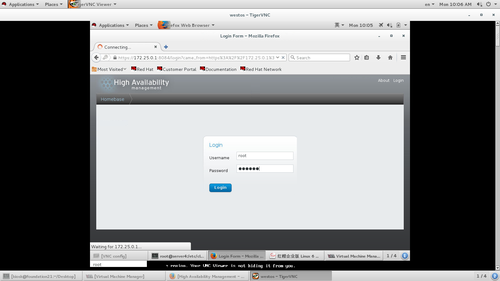

3. 在网页浏览器的地址栏中输入 cm an 服务器的 URL,并点击 Go(或者相当的按钮)。luci 服务器的URL 语法为https://luci_server_hostname:luci_server_port。luci_server_port的默认值为 8084 。

您首次访问 luci 时,网页浏览器会根据显示的自我签名 SSL 证书( luci 服务器的证书)给出具体提示。确认一个或者多个对话框后,您的网页显示器会显示luci 登录页面。

注意

如果 15 分钟后没有互动,则 luci 会处于闲置超时而让您退出。

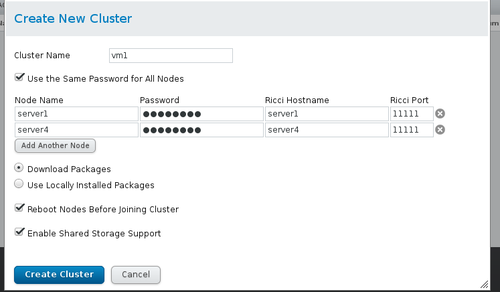

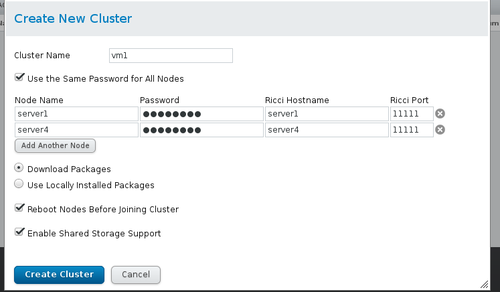

(3) 使用 luci 创建集群包括命名集群、在集群中添加集群节点、为每个节点输入 ricci 密码并提交创建集群请求。如果节点信息和密码正确,则 Conga 会自动在集群节点中安装软件(如果当前没有安装适当的软件包)并启动集群。

注意:

如果缺少任意基本集群组件(cman、rgmanager、modcluster 及其所有相依性软件包),无论是选择「使用本地安装的软件包」 ,还是[下载软件包]选项,都会安装它们。如果没有安装它们,则创建节点会失败.

12 vim /etc/yum.repos.d/rhel-source.repo

13 yum clean all

14 yum repolist 查看yum源

16 yum install ricci luci -y

17 /etc/init.d/ricci start

18 /etc/init.d/luci start

19 passwd ricci ####给ricci加密码

20 chkconfig ricci on ###开机自启动

21 chkconfig luci on

物理机浏览器:https:172.25.21.1:8084

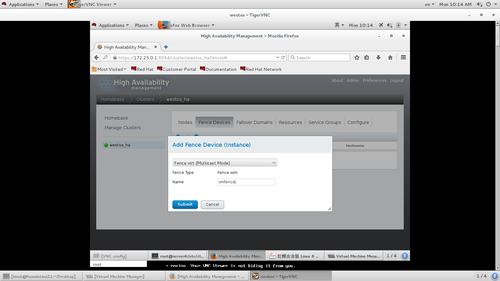

截图:

“luci Homebase 页面”:

按如下步骤创建集群:截图:

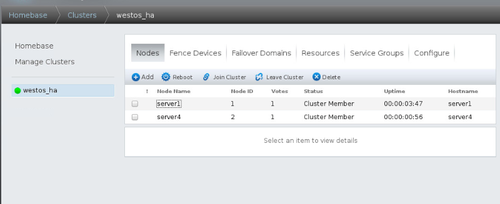

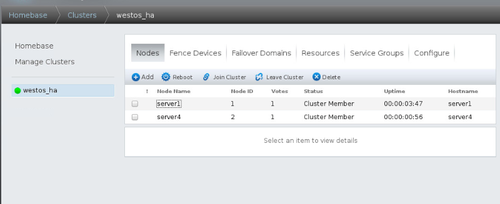

查看节点状态,每一项是running表示集群节点正常运行。

二、Fence机制当集群其中节点网络出现故障,互相之间无法通信,会以为对方出现故障,从而都会接管资源,此时出现资源争抢。Fence机制是直接将故障节点掉电。防止资源争抢。物理机;

1.安装软件

#Yum install fence-virtd-0.3.0-16.el7.x86_64

fence-virtd-libvirt-0.3.0-16.el7.x86_64

fence-virtd-multicast-0.3.0-16.el7.x86_64 -y

#rpm -qa | grep fence 搜索软件

#Fence_virtd -c

Module search path [/usr/lib64/fence-virt]:

Listener module [multicast]:

Multicast IP Address [225.0.0.12]:

Multicast IP Port [1229]:

Interface [br0]: br0

Key File [/etc/cluster/fence_xvm.key]:

Backend module [libvirt]:

Replace /etc/fence_virt.conf with the above [y/N]? Y

#dd if=/dev/urandom of =/etc/cluster/fence_xvm.key bs=128 count=1

#Systemctl start fence_virtd

#Systemctl restart fence_virtd

#Systemctl status fence_virtd

#Netstat -anulp |grep :1299

#Scp /etc/cluster/fence_xvm.key root@172.25.21.1:/etc/cluster/

#Scp /etc/cluster/fence_xvm.key root@172.25.21.4:/etc/cluster/

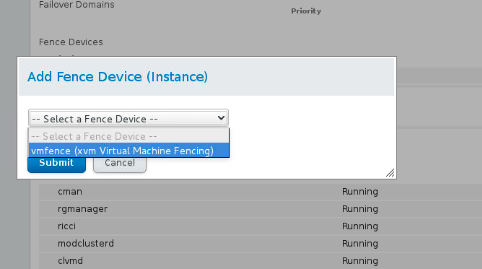

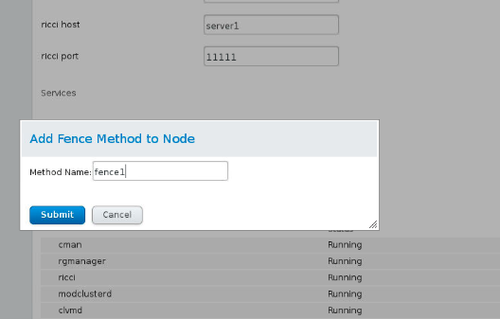

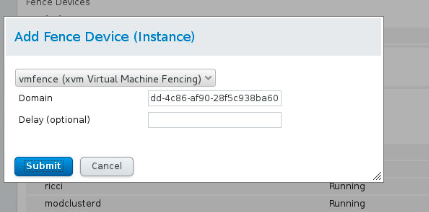

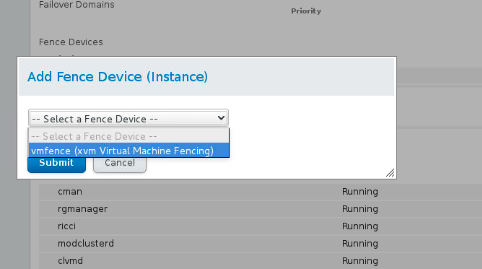

2.进入luci的图形管理界面,添加fence设备,每操作一步,就是向配置文件/etc/cluster/cluster.conf写入

浏览器:http:172.25.21.1:8084

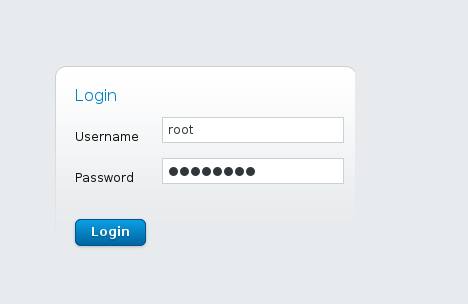

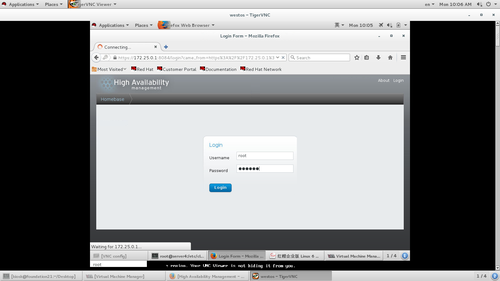

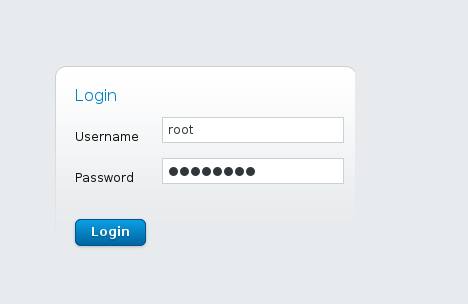

(1)输入:用户名,用户密码

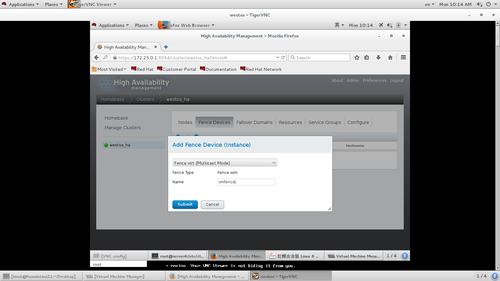

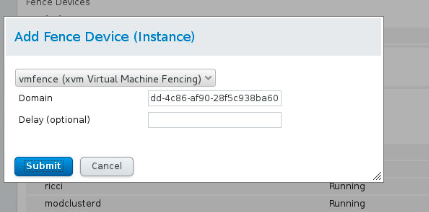

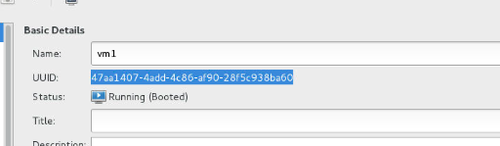

(2)添加fence设备图 起个设备名字

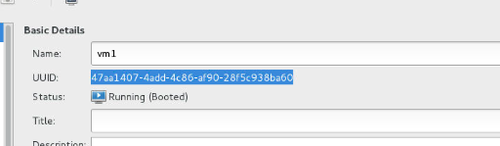

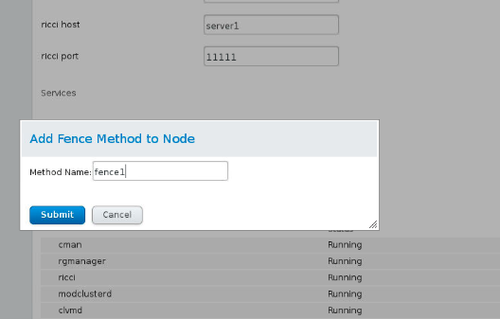

(3)将server1和server2加入fence设备图:

可在server1和server2输入

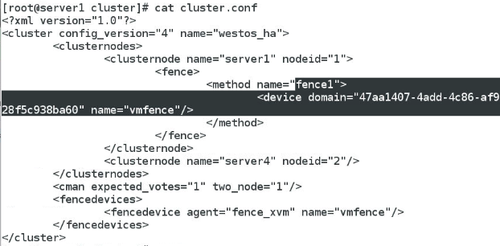

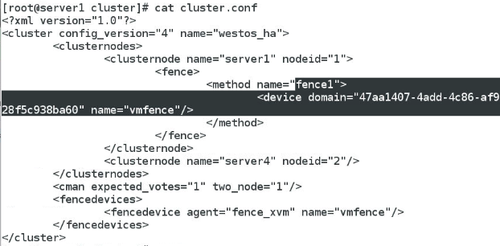

Cat /etc/cluster/cluster.conf 图

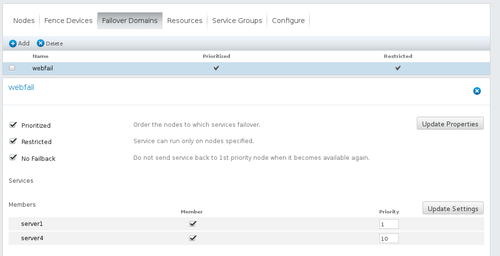

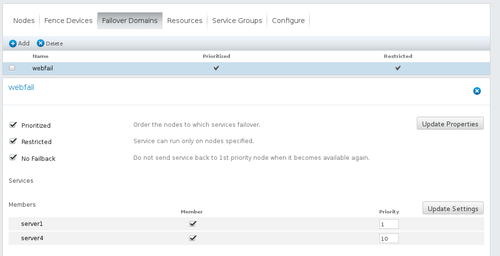

三、集群的故障转移域1、创建一个故障转移域。Prioritized,设定集群节点优先级;Pestricted,指定在特定的节点上运行服务;No Failback,不回切机制,当故障节点恢复后,集群资源不回切。

###添加故障切换域add failover domain tocluster

图:

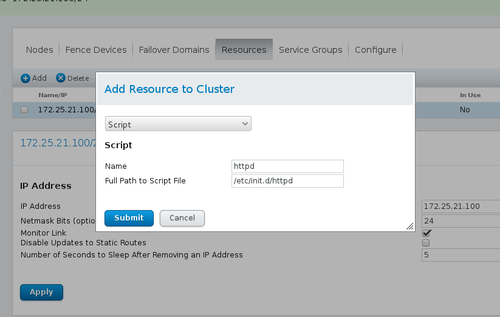

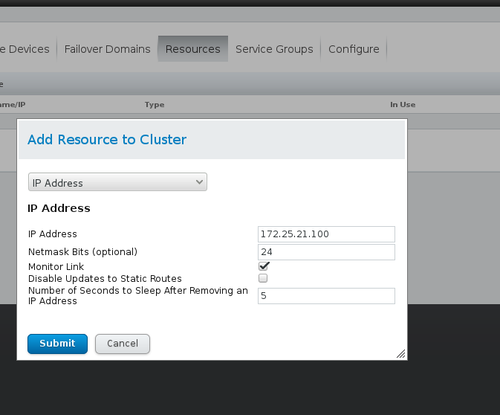

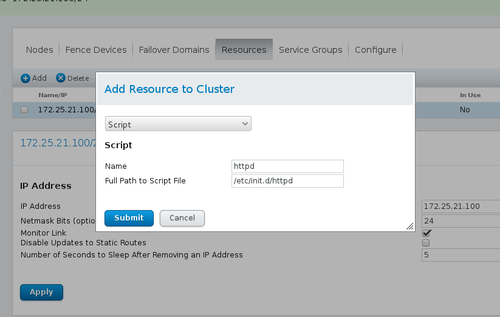

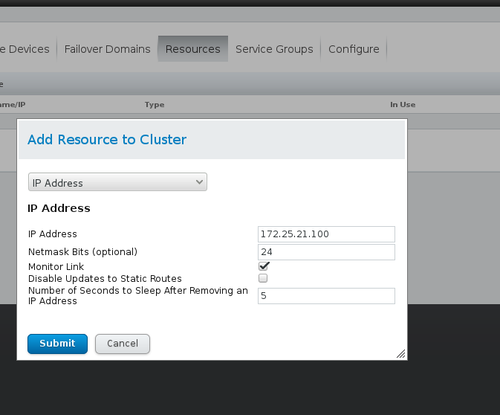

###配置全局集群资源:resources图

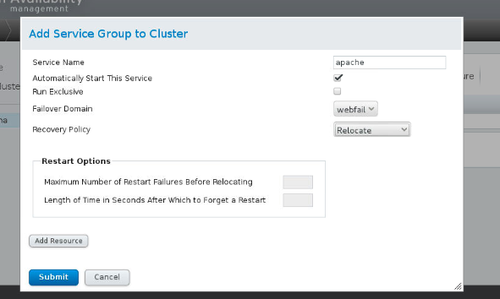

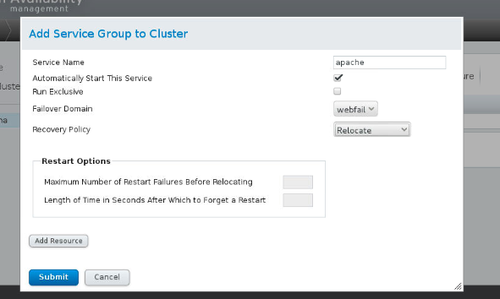

##资源组service groups 图

可在server1和server4输入

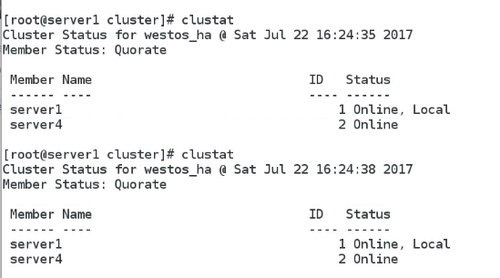

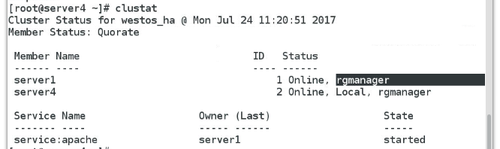

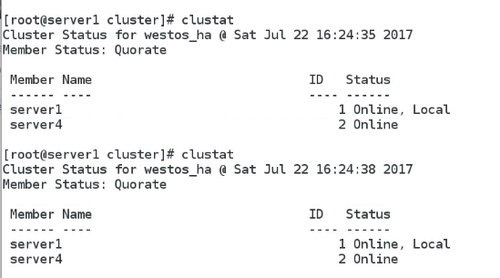

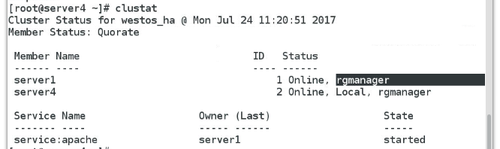

Clustat

Clustat命令可以查看集群状态,以及服务正在server1的节点上运行。

图:

测试:

server1的优先级高,client访问VIP时,server1接管集群资源,所以client访问到的是server1的httpd服务。当停掉server1的httpd服务,集群健康检查,server4接管集群资源,此时访问VIP,server2接管。让server4内核崩溃,server4会被fence,server1接管集群资源。

[root@server4 ~]# echo c >/proc/sysrq-trigger

四 基于高可用(HA)集群的apache+target服务配置。

集群共享文件系统apache+target

Server2 管理端:首先给server2添加一块8G的硬盘

1.安装tgtd服务。

Server2:

Yum install -y scsi-* -y

2.修改tgtd的配置文件/etc/tgt/targets.conf,用fdisk -l命令查看磁盘是vda还是sda。我的是vda,所以将vdb磁盘添加为scsi磁盘。启动tgtd服务

Vim /etc/tgt/tartgets.conf

<target iqn.2017-07.com.example:server.target1>

backing-store /dev/vdb

initiator-address 172.25.21.1

initiator-address 172.25.21.4

</target>

/etc/init.d/tgtd start

Tgt -admin -s 查看磁盘状态

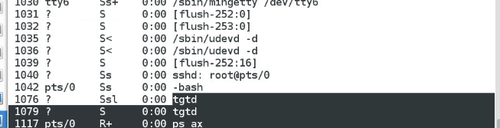

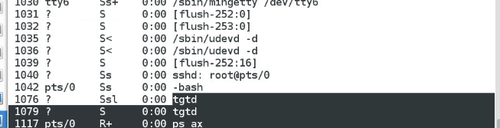

Ps ax

3.Server1和Server4安装iscsi

Yum install -y iscsi-* -y

iscsiadm -m discovery -t st -p 172.25.21.2

iscsiadm -m node -l

Fdisk -l

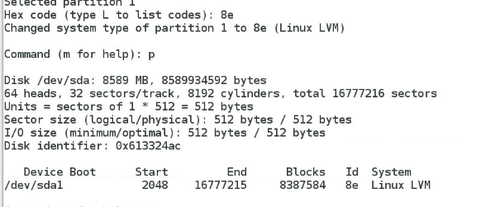

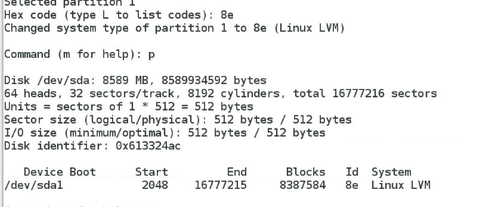

fdisk -cu /dev/sda

图:

Vim /etc/lvm/lvm.conf

图:

PS:locking_type = 1的话,可以用 lvmconf --enable-cluster命令修改。

lvmconf --enable-cluster

pvcreate /dev/sda1

pvs

vgcreate clusttervg /dev/sda1

vgs

lvcreate -L +2G -n demo clusttervg

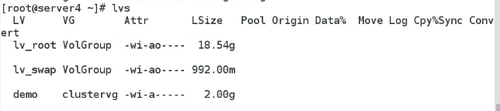

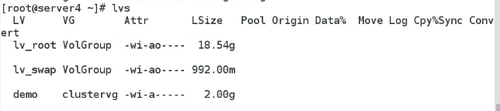

lvs

Server4

Yum install -y iscsi-* -y

iscsiadm -m discovery -t st -p 172.25.21.2

iscsiadm -m node -l

pvs

Vgs

Lvs

Server1和server4做同样的操作,

(1)配置yum 源

[HighAvailability]name=HighAvailabilitybaseurl=http://172.25.21.250/rhel6.5/HighAvailabilitygpgcheck=0[LoadBalancer]name=LoadBalancerbaseurl=http://172.25.21.250/rhel6.5/LoadBalancergpgcheck=0[ResilientStorage]name=ResilientStoragebaseurl=http://172.25.21.250/rhel6.5/ResilientStoragegpgcheck=0[ScalableFileSystem]name=ScalableFileSystembaseurl=http://172.25.21.250/rhel6.5/ScalableFileSystemgpgcheck=0

参数来源截图:

(2)安装服务

安装 ricci :使用 luci 配置集群要求在集群节点中安装并运行 ricci,使用 ricci 需要一个密码,您在创建集群时需要为每个集群节点输入该密码。在启动 luci 前,请确定您集群节点中的 IP 端口允许任意与 luci 沟通的节点中的luci 服务器到端口

11211 的连接。

要使用 Conga 管理红帽高可用性附加组件,请安装并运行 luci,如下:

1. 选择托管 luci 的主机,并在那台计算机中安装luci 软件通常是服务器架或者托管 luci 的数据中心的一台计算机中,但集群计算机也可托管 luci。

2. 使用 service luci start 启动 luci。例如:

注意 :从红帽企业版Linux 6.1 开始,您可以使用/etc/sysconfig/luci 文件配置 luci 行为的某

些方面,包括端口和主机参数,

3. 在网页浏览器的地址栏中输入 cm an 服务器的 URL,并点击 Go(或者相当的按钮)。luci 服务器的URL 语法为https://luci_server_hostname:luci_server_port。luci_server_port的默认值为 8084 。

您首次访问 luci 时,网页浏览器会根据显示的自我签名 SSL 证书( luci 服务器的证书)给出具体提示。确认一个或者多个对话框后,您的网页显示器会显示luci 登录页面。

注意

如果 15 分钟后没有互动,则 luci 会处于闲置超时而让您退出。

(3) 使用 luci 创建集群包括命名集群、在集群中添加集群节点、为每个节点输入 ricci 密码并提交创建集群请求。如果节点信息和密码正确,则 Conga 会自动在集群节点中安装软件(如果当前没有安装适当的软件包)并启动集群。

注意:

如果缺少任意基本集群组件(cman、rgmanager、modcluster 及其所有相依性软件包),无论是选择「使用本地安装的软件包」 ,还是[下载软件包]选项,都会安装它们。如果没有安装它们,则创建节点会失败.

12 vim /etc/yum.repos.d/rhel-source.repo

13 yum clean all

14 yum repolist 查看yum源

16 yum install ricci luci -y

17 /etc/init.d/ricci start

18 /etc/init.d/luci start

19 passwd ricci ####给ricci加密码

20 chkconfig ricci on ###开机自启动

21 chkconfig luci on

物理机浏览器:https:172.25.21.1:8084

截图:

“luci Homebase 页面”:

按如下步骤创建集群:截图:

查看节点状态,每一项是running表示集群节点正常运行。

二、Fence机制当集群其中节点网络出现故障,互相之间无法通信,会以为对方出现故障,从而都会接管资源,此时出现资源争抢。Fence机制是直接将故障节点掉电。防止资源争抢。物理机;

1.安装软件

#Yum install fence-virtd-0.3.0-16.el7.x86_64

fence-virtd-libvirt-0.3.0-16.el7.x86_64

fence-virtd-multicast-0.3.0-16.el7.x86_64 -y

#rpm -qa | grep fence 搜索软件

#Fence_virtd -c

Module search path [/usr/lib64/fence-virt]:

Listener module [multicast]:

Multicast IP Address [225.0.0.12]:

Multicast IP Port [1229]:

Interface [br0]: br0

Key File [/etc/cluster/fence_xvm.key]:

Backend module [libvirt]:

Replace /etc/fence_virt.conf with the above [y/N]? Y

#dd if=/dev/urandom of =/etc/cluster/fence_xvm.key bs=128 count=1

#Systemctl start fence_virtd

#Systemctl restart fence_virtd

#Systemctl status fence_virtd

#Netstat -anulp |grep :1299

#Scp /etc/cluster/fence_xvm.key root@172.25.21.1:/etc/cluster/

#Scp /etc/cluster/fence_xvm.key root@172.25.21.4:/etc/cluster/

2.进入luci的图形管理界面,添加fence设备,每操作一步,就是向配置文件/etc/cluster/cluster.conf写入

浏览器:http:172.25.21.1:8084

(1)输入:用户名,用户密码

(2)添加fence设备图 起个设备名字

(3)将server1和server2加入fence设备图:

可在server1和server2输入

Cat /etc/cluster/cluster.conf 图

三、集群的故障转移域1、创建一个故障转移域。Prioritized,设定集群节点优先级;Pestricted,指定在特定的节点上运行服务;No Failback,不回切机制,当故障节点恢复后,集群资源不回切。

###添加故障切换域add failover domain tocluster

图:

###配置全局集群资源:resources图

##资源组service groups 图

可在server1和server4输入

Clustat

Clustat命令可以查看集群状态,以及服务正在server1的节点上运行。

图:

测试:

server1的优先级高,client访问VIP时,server1接管集群资源,所以client访问到的是server1的httpd服务。当停掉server1的httpd服务,集群健康检查,server4接管集群资源,此时访问VIP,server2接管。让server4内核崩溃,server4会被fence,server1接管集群资源。

[root@server4 ~]# echo c >/proc/sysrq-trigger

四 基于高可用(HA)集群的apache+target服务配置。

集群共享文件系统apache+target

Server2 管理端:首先给server2添加一块8G的硬盘

1.安装tgtd服务。

Server2:

Yum install -y scsi-* -y

2.修改tgtd的配置文件/etc/tgt/targets.conf,用fdisk -l命令查看磁盘是vda还是sda。我的是vda,所以将vdb磁盘添加为scsi磁盘。启动tgtd服务

Vim /etc/tgt/tartgets.conf

<target iqn.2017-07.com.example:server.target1>

backing-store /dev/vdb

initiator-address 172.25.21.1

initiator-address 172.25.21.4

</target>

/etc/init.d/tgtd start

Tgt -admin -s 查看磁盘状态

Ps ax

3.Server1和Server4安装iscsi

Yum install -y iscsi-* -y

iscsiadm -m discovery -t st -p 172.25.21.2

iscsiadm -m node -l

Fdisk -l

fdisk -cu /dev/sda

图:

Vim /etc/lvm/lvm.conf

图:

PS:locking_type = 1的话,可以用 lvmconf --enable-cluster命令修改。

lvmconf --enable-cluster

pvcreate /dev/sda1

pvs

vgcreate clusttervg /dev/sda1

vgs

lvcreate -L +2G -n demo clusttervg

lvs

Server4

Yum install -y iscsi-* -y

iscsiadm -m discovery -t st -p 172.25.21.2

iscsiadm -m node -l

pvs

Vgs

Lvs

相关文章推荐

- RHCS集群套件——Luci/Ricci实现Web高可用集群

- 集群 luci+ricci

- luci+ricci构建集群

- HA高可用集群(ricci+luci+fence_virted)

- CentOS 6.6 上使用 luci/ricci 安装配置 RHCS 集群 推荐

- luci+ricci集群管理

- 红帽HA(RHCS)ricci+luci+fence

- RHCS高可用集群配置(luci+ricci+fence)

- 集群基础----(ricci+luci的安装)

- HA高可用集群部署( ricci + luci + fence ) 双机热备

- RHCS集群luci--ricci高集群

- RHCS套件web服务集群管理ricci luci

- CentOS 6.6 上使用 luci-ricci 安装配置 RHCS 集群

- RHCS集群套件之用Luci/Ricci实现Web集群的详细配置

- HA高可用集群部署(ricci+luci+fence_virtd) 双机热备

- ricci+luci集群

- Mongodb集群 - 副本集内部选举机制

- 转:EX436第一章:集群存储概论2(Fence设备大体可以分为两大类,一类是电源Fence,另一类则是电缆Fence)

- tomcat集群的failover机制

- Android中的GraphicBuffer同步机制-Fence