分布的相似度(距离)计算

2017-04-06 10:19

489 查看

作者:知乎用户

链接:https://www.zhihu.com/question/39872326/answer/83688277

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

1. Kullback-Leibler

divergence

对于两个分布

和

,KL散度定义为

。可以看出,如果要

小,那么

大的地方

必须要大(否则

会很大);而在

小的地方,KL-divergence

的值对

的大小就没那么敏感。相应地,如果要

小,那么

小的地方

必须也要小;而在

大的地方,同样地,KL-divergence

的值对

的大小也没那么敏感。

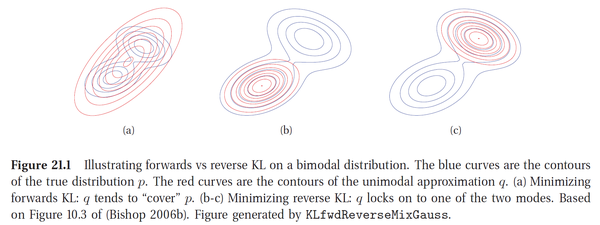

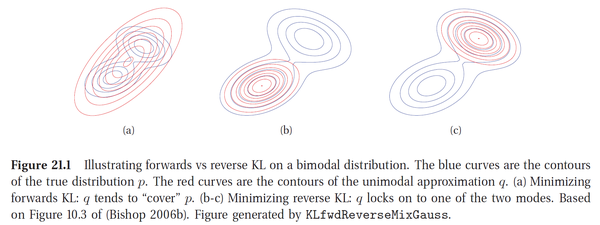

下图来自

Machine Learning: A Probabilistic Perspective p734,演示了上述两种情况。图中

(蓝色)是一个二分量的高斯混合分布,

(红色)是最小化

(图a)或

(图b-c)的高斯分布。感受一下区别。

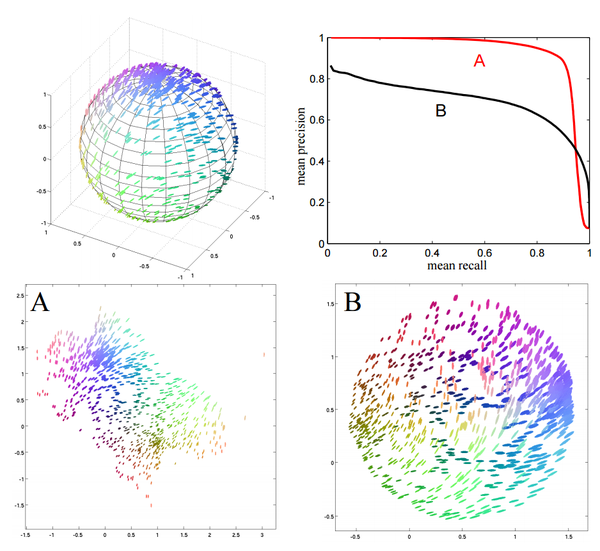

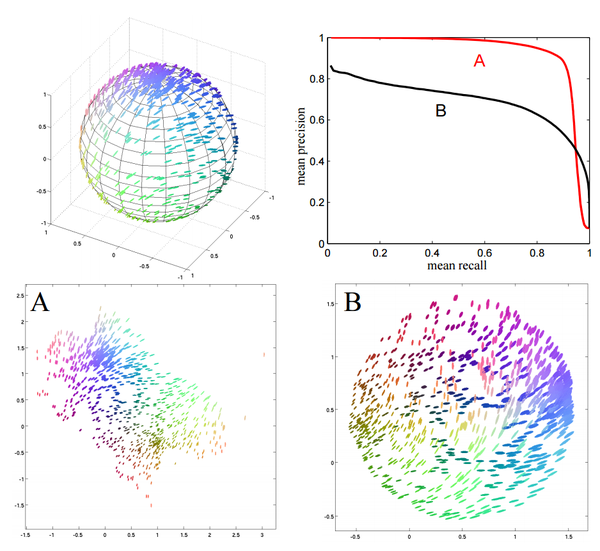

下图来自

Information Retrieval Perspective to Nonlinear Dimensionality Reduction for Data Visualization 的图2。作者在里面提出了一种非线性降维算法,目标函数(差不多)是两个方向的 KL-divergence 的加权平均。调整这个权值的话,三维球面上的点在二维平面上的降维结果会从A变化到B。这也是类似的原理。

2. 其他 f-divergence

KL-divergence 的坏处在于它是无界的。事实上KL-divergence 属于更广泛的 f-divergence 中的一种。一般性的 f-divergence 定义为

,如果取

或者

就能得到KL-divergence。除了KL-divergence,常用的

f-divergence 有

Hellinger distance、total

variation distance 等等。这两种 f-divergence 都是有界并且对称的。

3. Wasserstein distance

只讨论最简单的一种情形,一般情形见维基链接。定义

,也就是说,对任意边缘分布为

和

的联合分布

,我们可以求出

,而

和

的

Wasserstein distance 则定义为当

取遍可能的分布时,这个期望的最小值的平方根。

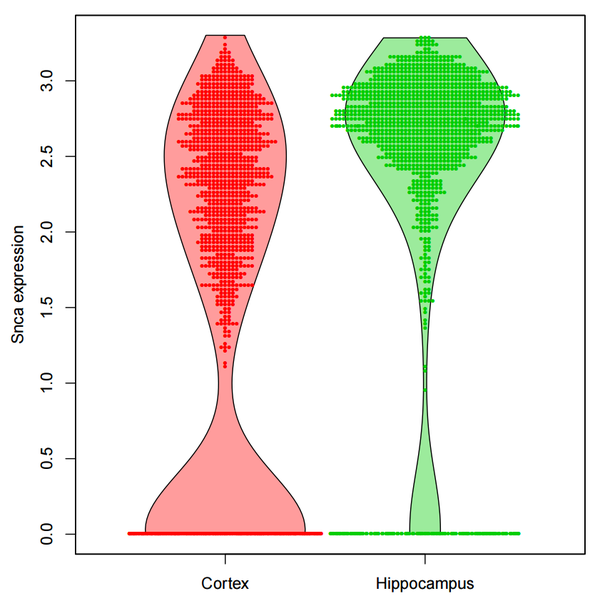

Wasserstein distance 衡量了把数据从分布

“移动成”分布

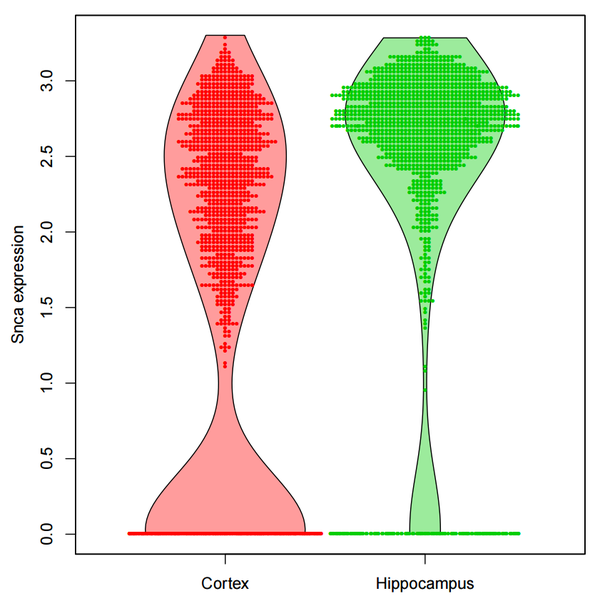

时所需要移动的平均距离的最小值(类似于把一堆土从一个形状移动到另一个形状所需要做的功的最小值)。下图出自Principal

Differences Analysis: Interpretable Characterization of Differences between Distributions 的图S2。文章目的是找出能解释两个维数一样的总体分布不同的最小特征集。他们找了个例子,说明有时候使用 Wasserstein distance 来刻画分布之间的不同是必要的:右边的那个 gene expression

的分布,看上去十分像是把左边那个分布往上挤了之后的结果。所以如果要刻画这种“原因”导致的区别,用 Wasserstein distance 比其他要更合理。

4. 其他。见

Statistical distance。

还是那句话:先问自己关心分布之间怎样的不同,有没有什么特殊约束或要求,再据此作相应的选择。至于题主的例子……我不太清楚“分布里的横坐标有着很实际的意义,比如分贝或者转速”这句话对“衡量两个分布之间的相似度(或者距离)”有着什么样的具体约束。

链接:https://www.zhihu.com/question/39872326/answer/83688277

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

1. Kullback-Leibler

divergence

对于两个分布

和

,KL散度定义为

。可以看出,如果要

小,那么

大的地方

必须要大(否则

会很大);而在

小的地方,KL-divergence

的值对

的大小就没那么敏感。相应地,如果要

小,那么

小的地方

必须也要小;而在

大的地方,同样地,KL-divergence

的值对

的大小也没那么敏感。

下图来自

Machine Learning: A Probabilistic Perspective p734,演示了上述两种情况。图中

(蓝色)是一个二分量的高斯混合分布,

(红色)是最小化

(图a)或

(图b-c)的高斯分布。感受一下区别。

下图来自

Information Retrieval Perspective to Nonlinear Dimensionality Reduction for Data Visualization 的图2。作者在里面提出了一种非线性降维算法,目标函数(差不多)是两个方向的 KL-divergence 的加权平均。调整这个权值的话,三维球面上的点在二维平面上的降维结果会从A变化到B。这也是类似的原理。

2. 其他 f-divergence

KL-divergence 的坏处在于它是无界的。事实上KL-divergence 属于更广泛的 f-divergence 中的一种。一般性的 f-divergence 定义为

,如果取

或者

就能得到KL-divergence。除了KL-divergence,常用的

f-divergence 有

Hellinger distance、total

variation distance 等等。这两种 f-divergence 都是有界并且对称的。

3. Wasserstein distance

只讨论最简单的一种情形,一般情形见维基链接。定义

,也就是说,对任意边缘分布为

和

的联合分布

,我们可以求出

,而

和

的

Wasserstein distance 则定义为当

取遍可能的分布时,这个期望的最小值的平方根。

Wasserstein distance 衡量了把数据从分布

“移动成”分布

时所需要移动的平均距离的最小值(类似于把一堆土从一个形状移动到另一个形状所需要做的功的最小值)。下图出自Principal

Differences Analysis: Interpretable Characterization of Differences between Distributions 的图S2。文章目的是找出能解释两个维数一样的总体分布不同的最小特征集。他们找了个例子,说明有时候使用 Wasserstein distance 来刻画分布之间的不同是必要的:右边的那个 gene expression

的分布,看上去十分像是把左边那个分布往上挤了之后的结果。所以如果要刻画这种“原因”导致的区别,用 Wasserstein distance 比其他要更合理。

4. 其他。见

Statistical distance。

还是那句话:先问自己关心分布之间怎样的不同,有没有什么特殊约束或要求,再据此作相应的选择。至于题主的例子……我不太清楚“分布里的横坐标有着很实际的意义,比如分贝或者转速”这句话对“衡量两个分布之间的相似度(或者距离)”有着什么样的具体约束。

相关文章推荐

- 海量数据相似度计算之simhash和海明距离

- 特征向量相似度和距离的计算

- 最小编辑代价&&华为OJ 编辑距离&&计算字符串的相似度

- 初学hadoop之一:相似度计算(余弦距离)

- 使用欧几里德距离构建简单的推荐系统计算用户相似度

- 计算两个字符串的距离(相似度)

- 文本相似度计算的几个距离公式(欧氏距离、余弦相似度、Jaccard距离、编辑距离)

- 编辑距离LCS算法详解:Levenshtein Distance算法计算两个字符串的相似度

- 海量数据相似度计算实例 simhash和海明距离

- 一些距离及相似度计算公式

- 海量数据相似度计算之simhash和海明距离

- 初学hadoop之一:相似度计算(Jacard距离)

- 特征向量相似度和距离计算方法

- 特征向量相似度和距离的计算

- 计算字符串的相似度(编辑距离)

- Levenshtein计算相似度距离

- 海量数据相似度计算之simhash和海明距离

- 【转】海量数据相似度计算之simhash和海明距离

- 距离和相似度计算总结

- 编辑距离(LD)计算两个字符串相似度