Hadoop 集群问题汇总

2017-04-05 18:42

197 查看

公司希望使用spark on yarn 模式管理spark应用,在搭建hadoop当中碰到的问题分享一下:

Hadoop Version : 2.7.2

1、Report:Call from linux151 to linux152:9000 failed on connection exception : connection refused

自己碰到的情况是没有启动hdfs服务导致无法连接。 网上还有一种情况说的是配置了core-site.xml 当中的defaultFS 配置项对应的value为主机名时该主机名没有假如到/etc/hosts文件当中,配置hostname即可解决

2、启动hdfs服务后,datanode没有启动,并且日志当中输出:All specified directories are failed to load.

该问题一般是由于name node 节点当中的clusterId 与data node 当中的 clusterId不一致造成,解决方法:比如我配置的namenode位置为/home/wwd/hadoop/dfs/name,datanode位置为/home/wwd/hadoop/dfs/data,那么修改 dfs/data/current/VERSION 文件当中clusterId项,与namenode当中dfs/name/current/VERSION当中的clusterId一致即可,如果为完全集群模式,则所有的namenode和datanode当中的clusterId

应该与master当中一致。

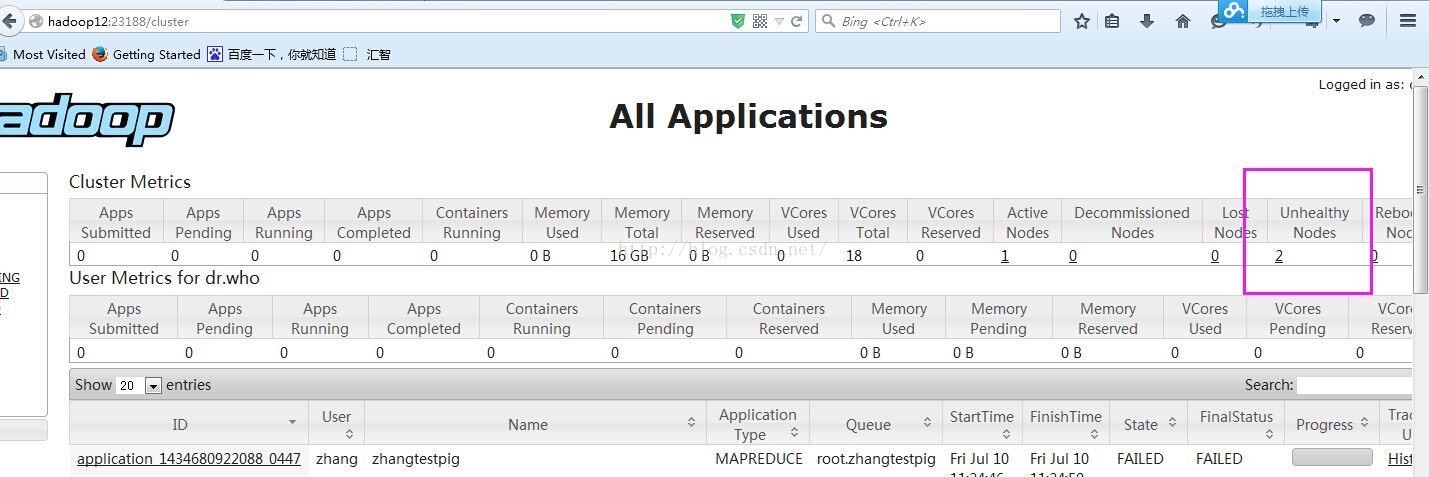

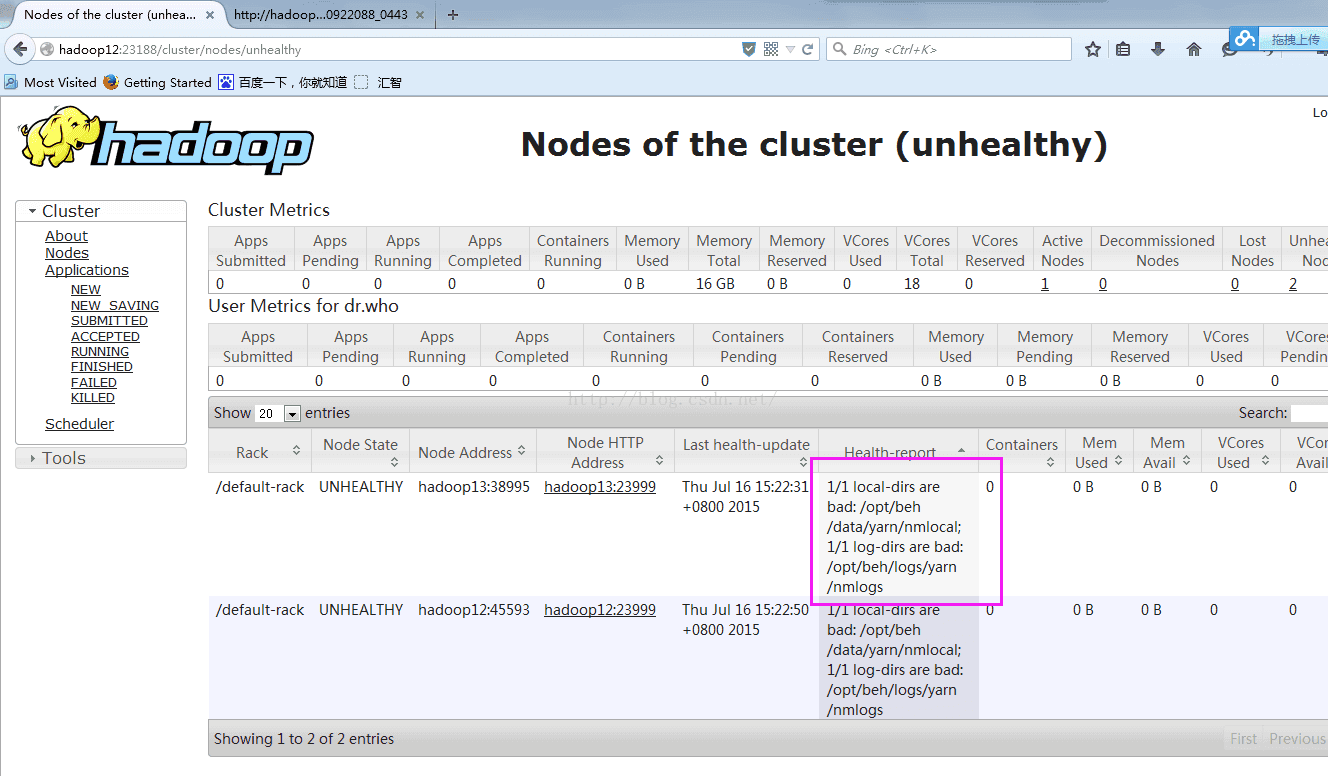

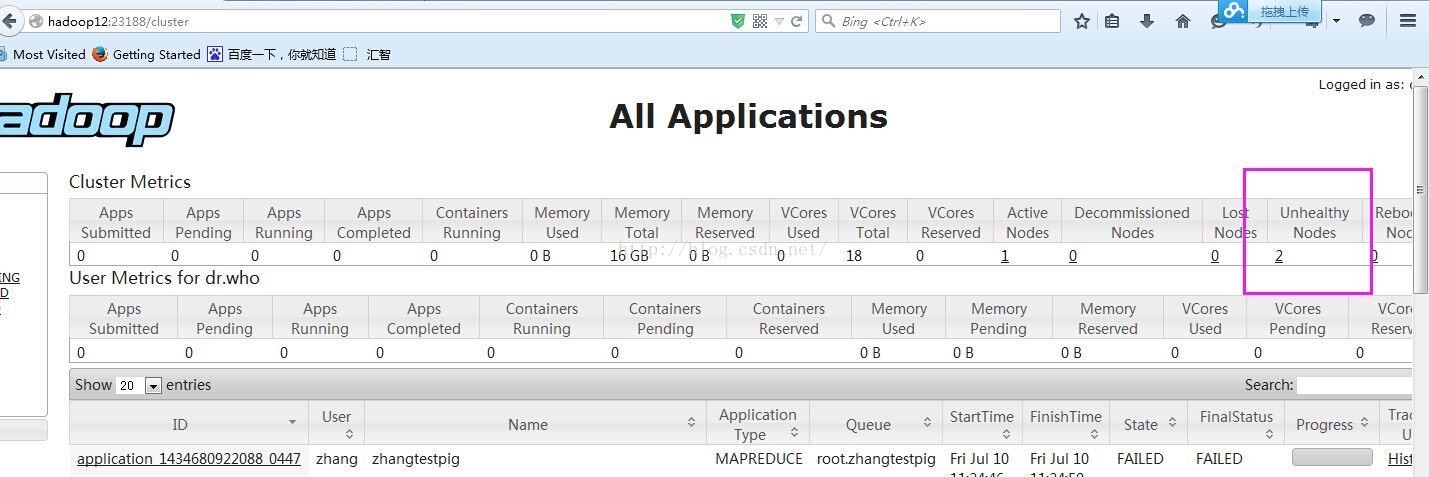

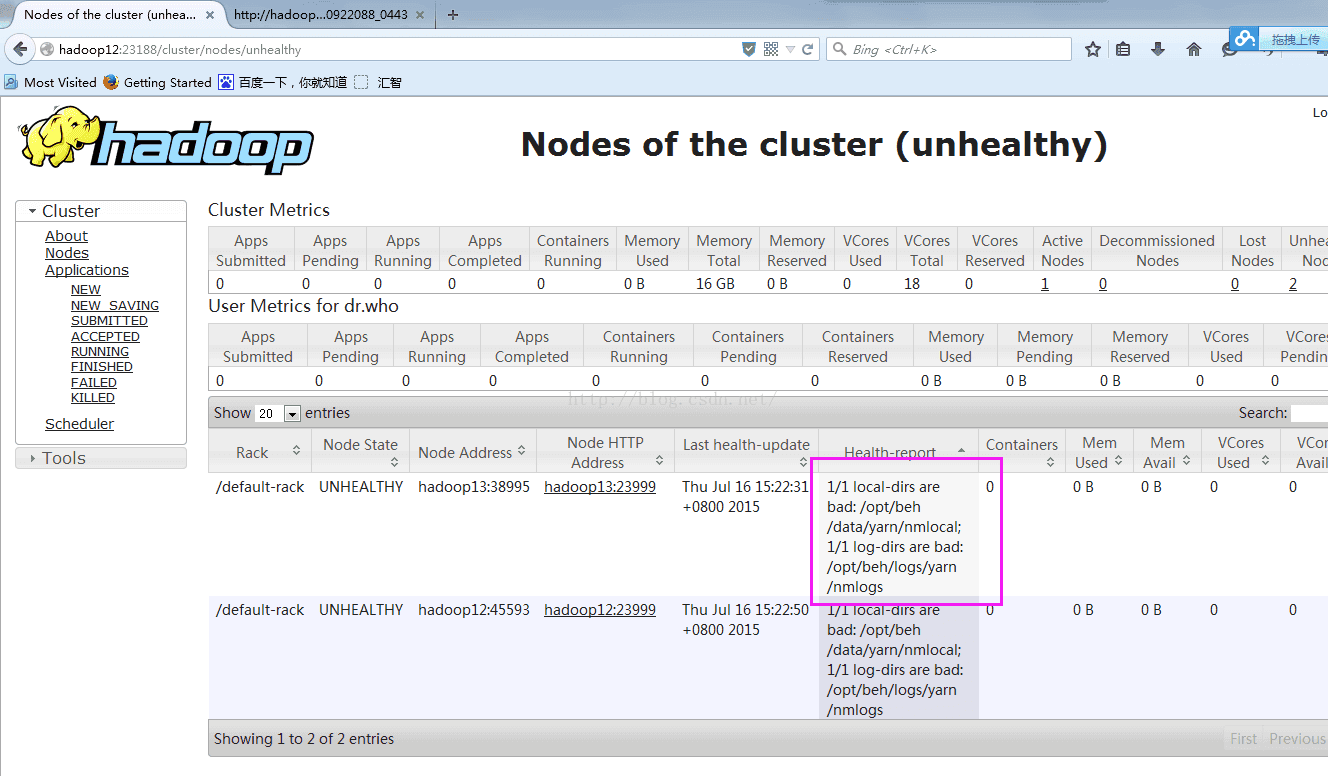

3、集群模式下启动yarn资源管理器后访问http://master:8088 ,点击nodes 后发现某些节点无法正常启动

去问题节点上查看Nodemanager相关日志可以发现是由于文件系统使用率达到了90%导致的

删除不需要的垃圾文件,将磁盘使用率降到90%以下即可,注意不需要重启,满足注册条件后hadoop会自动将该节点注册到yarn资源管理器上

注:图片来自其他博主博客

Hadoop Version : 2.7.2

1、Report:Call from linux151 to linux152:9000 failed on connection exception : connection refused

自己碰到的情况是没有启动hdfs服务导致无法连接。 网上还有一种情况说的是配置了core-site.xml 当中的defaultFS 配置项对应的value为主机名时该主机名没有假如到/etc/hosts文件当中,配置hostname即可解决

2、启动hdfs服务后,datanode没有启动,并且日志当中输出:All specified directories are failed to load.

该问题一般是由于name node 节点当中的clusterId 与data node 当中的 clusterId不一致造成,解决方法:比如我配置的namenode位置为/home/wwd/hadoop/dfs/name,datanode位置为/home/wwd/hadoop/dfs/data,那么修改 dfs/data/current/VERSION 文件当中clusterId项,与namenode当中dfs/name/current/VERSION当中的clusterId一致即可,如果为完全集群模式,则所有的namenode和datanode当中的clusterId

应该与master当中一致。

3、集群模式下启动yarn资源管理器后访问http://master:8088 ,点击nodes 后发现某些节点无法正常启动

去问题节点上查看Nodemanager相关日志可以发现是由于文件系统使用率达到了90%导致的

删除不需要的垃圾文件,将磁盘使用率降到90%以下即可,注意不需要重启,满足注册条件后hadoop会自动将该节点注册到yarn资源管理器上

注:图片来自其他博主博客

相关文章推荐

- Hadoop集群问题汇总

- Hadoop2.7.2 Centos 完全分布式集群环境搭建 (3) - 问题汇总

- hadoop集群环境安装 遇到的问题汇总

- mac中myeclipse10连接hadoop-2.6.0集群开发环境问题汇总

- Hadoop集群搭建及测试过程中碰到的问题汇总

- hadoop2.7.3分布式集群问题汇总(持续更新)

- Hadoop、Spark 集群环境搭建问题汇总

- 解决典型Hadoop分布式集群环境搭建问题

- Hadoop + HBase 常见问题的解决汇总

- Hadoop集群配置问题

- hadoop集群部署常见问题

- hadoop问题汇总

- Hadoop问题汇总

- hadoop集群环境安装中的hosts 配置问题

- Hadoop集群中hosts文件配置问题

- hadoop配置问题解决汇总

- linux下搭建hadoop集群问题备忘录

- RHEL 5下配置Hadoop集群:java.net.NoRouteToHostException: No route to host问题的解决

- Hadoop常见问题汇总

- hadoop集群配置以及配置中遇到的问题详解