Spark常用函数讲解之Action操作

2017-02-02 14:00

246 查看

RDD:弹性分布式数据集,是一种特殊集合 ‚ 支持多种来源 ‚ 有容错机制 ‚ 可以被缓存 ‚

支持并行操作,一个RDD代表一个分区里的数据集

RDD有两种操作算子:

Transformation(转换):Transformation属于延迟计算,当一个RDD转换成另一个RDD时并没有立即进行转换,仅仅是记住 了数据集的逻辑操作

Ation(执行):触发Spark作业的运行,真正触发转换算子的计算

本章所讲函数

1.reduce

2.collect

3.count

4.first

5.take

6.top

7.takeOrdered

8.countByKey

9.collectAsMap

10.lookup

11.aggregate

12.fold

13.saveAsFile

14.saveAsSequenceFile

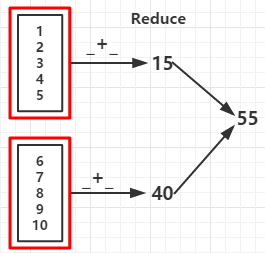

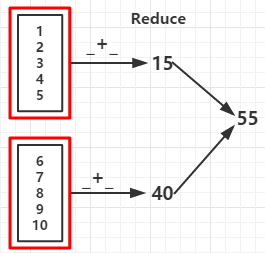

1.reduce(func):通过函数func先聚集各分区的数据集,再聚集分区之间的数据,func接收两个参数,返回一个新值,新值再做为参数继续传递给函数func,直到最后一个元素

2.collect():以数据的形式返回数据集中的所有元素给Driver程序,为防止Driver程序内存溢出,一般要控制返回的数据集大小

3.count():返回数据集元素个数

4.first():返回数据集的第一个元素

5.take(n):以数组的形式返回数据集上的前n个元素

6.top(n):按默认或者指定的排序规则返回前n个元素,默认按降序输出

7.takeOrdered(n,[ordering]): 按自然顺序或者指定的排序规则返回前n个元素

例1:

输出:

(RDD依赖图:红色块表示一个RDD区,黑色块表示该分区集合,下同)

(RDD依赖图)

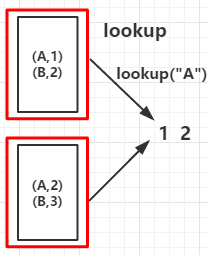

8.countByKey():作用于K-V类型的RDD上,统计每个key的个数,返回(K,K的个数)

9.collectAsMap():作用于K-V类型的RDD上,作用与collect不同的是collectAsMap函数不包含重复的key,对于重复的key。后面的元素覆盖前面的元素

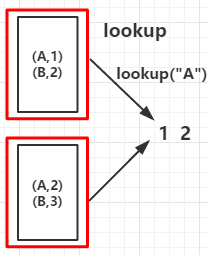

10.lookup(k):作用于K-V类型的RDD上,返回指定K的所有V值

例2:

输出:

(RDD依赖图)

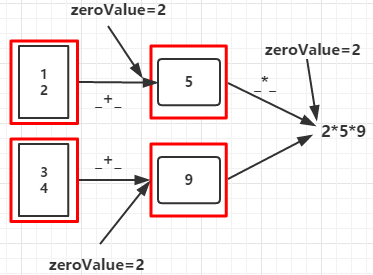

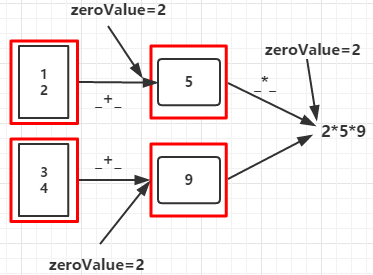

11.aggregate(zeroValue:U)(seqOp:(U,T) => U,comOp(U,U) => U):

seqOp函数将每个分区的数据聚合成类型为U的值,comOp函数将各分区的U类型数据聚合起来得到类型为U的值

输出:

步骤1:分区1:zeroValue+1+2=5 分区2:zeroValue+3+4=9

步骤2:zeroValue*分区1的结果*分区2的结果=90

(RDD依赖图)

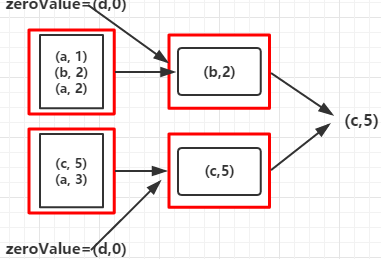

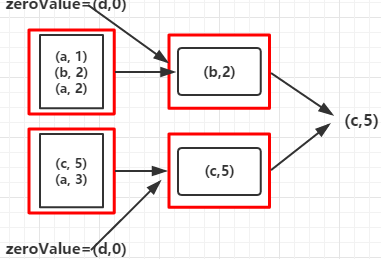

12.fold(zeroValue:T)(op:(T,T) => T):通过op函数聚合各分区中的元素及合并各分区的元素,op函数需要两个参数,在开始时第一个传入的参数为zeroValue,T为RDD数据集的数据类型,,其作用相当于SeqOp和comOp函数都相同的aggregate函数

例3

输出:

其过程如下:

1.开始时将(“d”,0)作为op函数的第一个参数传入,将Array中和第一个元素("a",1)作为op函数的第二个参数传入,并比较value的值,返回value值较大的元素

2.将上一步返回的元素又作为op函数的第一个参数传入,Array的下一个元素作为op函数的第二个参数传入,比较大小

3.重复第2步骤

每个分区的数据集都会经过以上三步后汇聚后再重复以上三步得出最大值的那个元素,对于其他op函数也类似,只不过函数里的处理数据的方式不同而已

(RDD依赖图)

13.saveAsFile(path:String):将最终的结果数据保存到指定的HDFS目录中

14.saveAsSequenceFile(path:String):将最终的结果数据以sequence的格式保存到指定的HDFS目录中

支持并行操作,一个RDD代表一个分区里的数据集

RDD有两种操作算子:

Transformation(转换):Transformation属于延迟计算,当一个RDD转换成另一个RDD时并没有立即进行转换,仅仅是记住 了数据集的逻辑操作

Ation(执行):触发Spark作业的运行,真正触发转换算子的计算

本章所讲函数

1.reduce

2.collect

3.count

4.first

5.take

6.top

7.takeOrdered

8.countByKey

9.collectAsMap

10.lookup

11.aggregate

12.fold

13.saveAsFile

14.saveAsSequenceFile

1.reduce(func):通过函数func先聚集各分区的数据集,再聚集分区之间的数据,func接收两个参数,返回一个新值,新值再做为参数继续传递给函数func,直到最后一个元素

2.collect():以数据的形式返回数据集中的所有元素给Driver程序,为防止Driver程序内存溢出,一般要控制返回的数据集大小

3.count():返回数据集元素个数

4.first():返回数据集的第一个元素

5.take(n):以数组的形式返回数据集上的前n个元素

6.top(n):按默认或者指定的排序规则返回前n个元素,默认按降序输出

7.takeOrdered(n,[ordering]): 按自然顺序或者指定的排序规则返回前n个元素

例1:

func +: 55 func -: 15 //如果分区数据为1结果为 -53 count: 10 first: 1 take: 1 2 3 4 5 top: 10 9 8 takeOrdered: 1 2 3

(RDD依赖图:红色块表示一个RDD区,黑色块表示该分区集合,下同)

(RDD依赖图)

8.countByKey():作用于K-V类型的RDD上,统计每个key的个数,返回(K,K的个数)

9.collectAsMap():作用于K-V类型的RDD上,作用与collect不同的是collectAsMap函数不包含重复的key,对于重复的key。后面的元素覆盖前面的元素

10.lookup(k):作用于K-V类型的RDD上,返回指定K的所有V值

例2:

countByKey: (B,2)(A,2) collectAsMap: (A,2)(B,3)

(RDD依赖图)

11.aggregate(zeroValue:U)(seqOp:(U,T) => U,comOp(U,U) => U):

seqOp函数将每个分区的数据聚合成类型为U的值,comOp函数将各分区的U类型数据聚合起来得到类型为U的值

90

步骤1:分区1:zeroValue+1+2=5 分区2:zeroValue+3+4=9

步骤2:zeroValue*分区1的结果*分区2的结果=90

(RDD依赖图)

12.fold(zeroValue:T)(op:(T,T) => T):通过op函数聚合各分区中的元素及合并各分区的元素,op函数需要两个参数,在开始时第一个传入的参数为zeroValue,T为RDD数据集的数据类型,,其作用相当于SeqOp和comOp函数都相同的aggregate函数

例3

1.开始时将(“d”,0)作为op函数的第一个参数传入,将Array中和第一个元素("a",1)作为op函数的第二个参数传入,并比较value的值,返回value值较大的元素

2.将上一步返回的元素又作为op函数的第一个参数传入,Array的下一个元素作为op函数的第二个参数传入,比较大小

3.重复第2步骤

每个分区的数据集都会经过以上三步后汇聚后再重复以上三步得出最大值的那个元素,对于其他op函数也类似,只不过函数里的处理数据的方式不同而已

(RDD依赖图)

13.saveAsFile(path:String):将最终的结果数据保存到指定的HDFS目录中

14.saveAsSequenceFile(path:String):将最终的结果数据以sequence的格式保存到指定的HDFS目录中

相关文章推荐

- Spark常用函数讲解之Action操作

- Spark常用函数讲解--Action操作

- Spark常用函数讲解--Action操作

- Spark常用函数讲解之Action操作

- Spark常用函数之Action操作

- Spark常用函数讲解--键值RDD转换

- Spark常用transformation和action操作

- Spark常用函数讲解

- spark常用函数:transformation和action

- Spark常用函数讲解之键值RDD转换

- Spark基础的transformation 和 action的函数操作

- Spark常用函数讲解之RDD基本转换

- Opencv--常用操作函数讲解

- Spark常用函数讲解之键值RDD转换

- Spark Streaming中的操作函数讲解

- spark的RDD中的action(执行)和transformation(转换)两种操作中常见函数介绍

- Spark Streaming中的操作函数讲解

- Spark常用函数讲解之键值RDD转换

- Spark常用函数:transformation和action

- Spark常用函数讲解之键值RDD转换