coursera机器学习笔记之“Neural Networks (part two)”

2016-11-15 09:45

381 查看

content:

5 Neural Networks (part two)5.1 cost function

5.2 Back Propagation

5.3 神经网络总结

接上一篇4. Neural Networks (part one). 本文将先定义神经网络的代价函数,然后介绍逆向传播(Back Propagation:

BP)算法,它能有效求解代价函数对连接权重的偏导,最后对训练神经网络的过程进行总结。

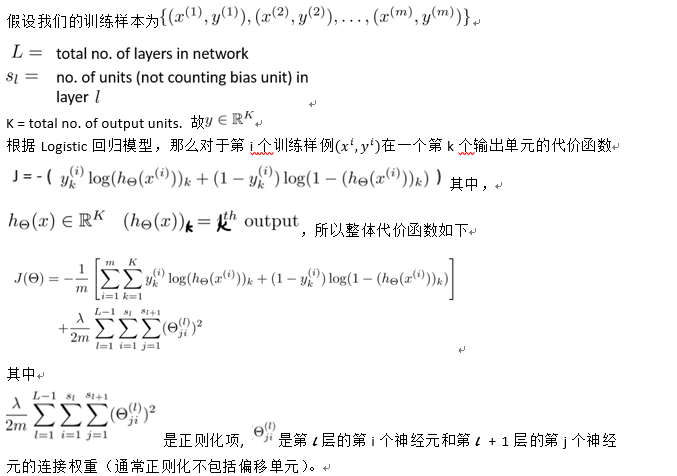

5.1 cost function

(注:正则化相关内容参见3.Bayesian statistics and Regularization)

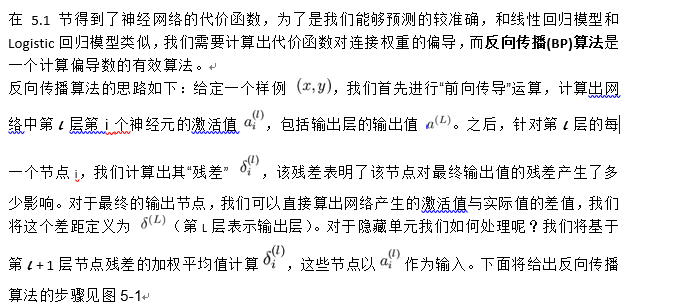

5.2 Back Propagation

(详细推导过程参见反向传播算法)。

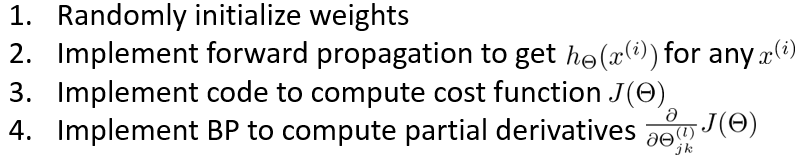

图5-1 BP算法步骤

在实现反向传播算法时,有如下几个需要注意的地方。

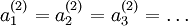

需要对所有的连接权重(包括偏移单元)初始化为接近0但不全等于0的随机数。如果所有参数都用相同的值作为初始值,那么所有隐藏层单元最终会得到与输入值有关的、相同的函数(也就是说,所有神经元的激活值都会取相同的值,对于任何输入x 都会有:

)。随机初始化的目的是使对称失效。具体地,我们可以如图5-2一样随机初始化。(matlab实现见后文代码1)

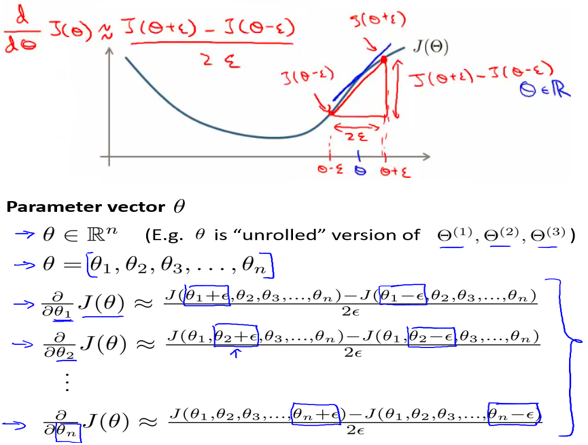

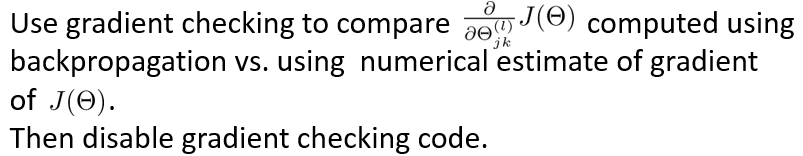

如果实现的BP算法计算出的梯度(偏导数)是错误的,那么用该模型来预测新的值肯定是不科学的。所以,我们应该在应用之前就判断BP算法是否正确。具体的,可以通过数值的方法(如图5-3所示的)计算出较精确的偏导,然后再和BP算法计算出来的进行比较,若两者相差在正常的误差范围内,则BP算法计算出的应该是比较正确的,否则说明算法实现有误。注意在检查完后,在真正训练模型时不应该再运行数值计算偏导的方法,否则将会运行很慢。(matlab实现见后文代码2)

用matlab实现时要注意matlab的函数参数不能为矩阵,而连接权重为矩阵,所以在传递初始化连接权重前先将其向量化,再用reshape函数恢复。(见后文代码3)

图5-2 随机初始化连接权重

图5-3 数值方法求代价函数偏导的近似值

5.3 神经网络总结

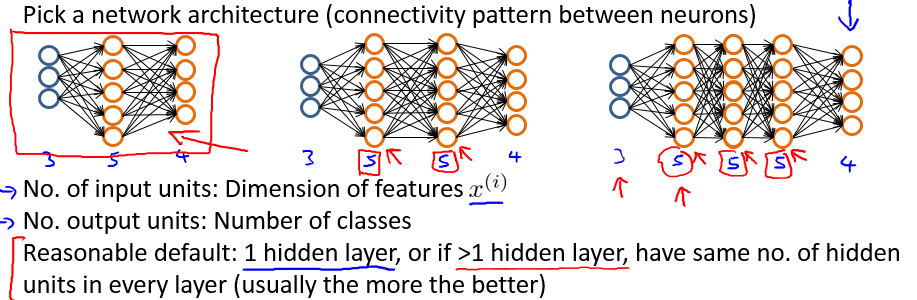

第一步,设计神经网络结构。

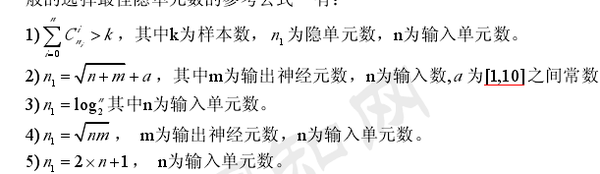

隐藏层单元个数通常都是不确定的。

一般选取神经网络隐藏层单元个数的几个经验公式如下:

参考https://www.zhihu.com/question/46530834

此外,MNIST手写数字识别中给出了以不同的神经网络结构训练的结果,供参考

第二步,实现正向传播(FP)和反向传播算法,这一步包括如下的子步骤。

第三步,用数值方法检查求偏导的正确性

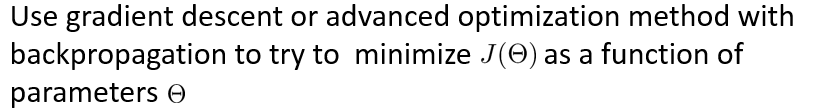

第四步,用梯度下降法或更先进的优化算法求使得代价函数最小的连接权重

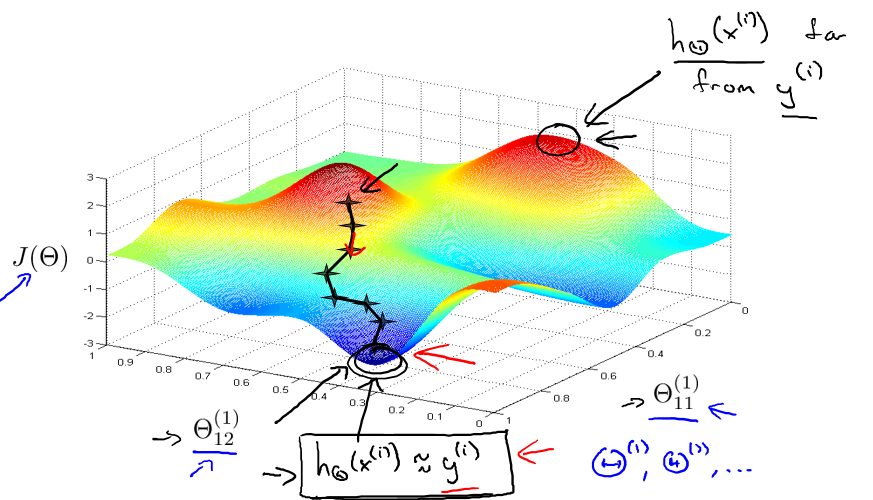

在第四步中,由于代价函数是非凸(non-convex)函数,所以在优化过程中可能陷入局部最优值,但不一定比全局最优差很多(如图5-4),在实际应用中通常不是大问题。也会有一些启发式的算法(如模拟退火算法,遗传算法等)来帮助跳出局部最优。

图5-4 陷入局部最优(不一定比全局最优差很多)

相关文章推荐

- Coursera-吴恩达-机器学习-(第4周笔记)Neural Networks——Representation

- Coursera公开课笔记: 斯坦福大学机器学习第九课“神经网络的学习(Neural Networks: Learning)”

- coursera机器学习笔记之“Neural Networks (part one)”

- Coursera公开课笔记: 斯坦福大学机器学习第八课“神经网络的表示(Neural Networks: Representation)”

- Coursera公开课笔记: 斯坦福大学机器学习第九课“神经网络的学习(Neural Networks: Learning)”

- Coursera台大机器学习课程笔记4 -- Training versus Testing

- Coursera台大机器学习课程笔记6 -- The VC Dimension

- Coursera公开课笔记: 斯坦福大学机器学习第四课“多变量线性回归(Linear Regression with Multiple Variables)”

- Coursera公开课笔记: 斯坦福大学机器学习第六课“逻辑回归(Logistic Regression)”

- Coursera公开课笔记: 斯坦福大学机器学习第七课“正则化(Regularization)”

- 笔记:机器学习-Coursera-Andrew Ng

- Coursera台大机器学习课程笔记3 – 机器学习的可能性

- Coursera公开课笔记: 斯坦福大学机器学习第二课“单变量线性回归(Linear regression with one variable)”

- Ng在coursera上的机器学习公开课——zai总结(5)_Neural Networks: Representation

- 笔记: 斯坦福大学机器学习第九课“神经网络的学习(Neural Networks: Learning)”

- Coursera台大机器学习课程笔记4 -- Training versus Testing

- Coursera台大机器学习基础课程学习笔记1 -- 机器学习定义及PLA算法

- Coursera公开课笔记: 斯坦福大学机器学习第六课“逻辑回归(Logistic Regression)”

- Coursera公开课笔记: 斯坦福大学机器学习第四课“多变量线性回归(Linear Regression with Multiple Variables)”

- Coursera公开课笔记: 斯坦福大学机器学习第二课“单变量线性回归(Linear regression with one variable)”