神经网络中的重要概念

2016-11-07 14:50

831 查看

摘自:点击打开链接

感知机:输入层、输出层和一个隐含层。

输入的特征向量通过隐含层变换达到输出层,在输出层得到分类结果;

使用离散的传输函数;

多层感知器:= 神经网络

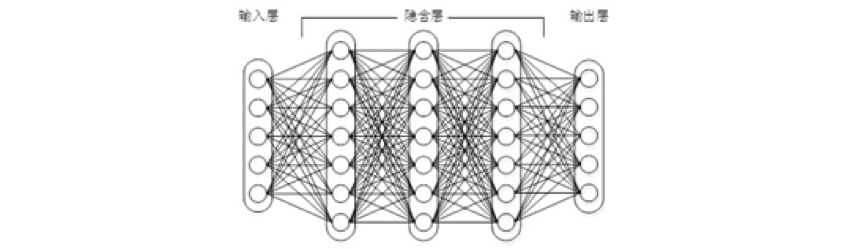

上图展示了多层感知器的结构

使用sigmoid或tanh等连续函数模拟神经元对激励的相应

训练算法:反向传播BP算法

神经网络的层数直接决定了它对现实的刻画能力。但是随着神经网络层数的加深,优化函数越来越容易陷入局部最优解。

同时,另一个不可忽略的问题是随着网络层数增加,“梯度消失”现象更加严重。即,对于幅度为1的信号,在BP反向传播时,每传递一层,梯度衰减为原来的0.25。层数一多,梯度指数衰减后底层基本上接收不到有效的训练信号。

深度学习:

利用预训练方法缓解了局部最优解问题,将隐含层推动到更多层;

为了克服梯度消失,ReLU、maxout等传输函数代替了sigmoid,形成了DNN的基本形式;

单从结构上来说,全连接的DNN和上图的多层感知器是没有任何区别的。

存在的问题:全连接DNN 的结构里下层神经元和所有上层神经元都能够形成连接,导致的潜在问题是参数数量的膨胀。

CNN卷积神经网络:

图像中有固有的局部模式(比如轮廓、边界、眼睛)可以利用,显然应该将图像处理中的概念和神经网络技术形结合。 得到卷积神经网络CNN;

CNN中,不是所有上下层神经元都能直接相连,而是通过“卷积核”作为中介。同一个卷积核在所有图像内是共享的,图像通过卷积操作后仍然保留原来的位置关系;

RNN 循环神经网络:

应对全连接的DNN 存在的一个问题:无法对时间序列上的变化进行建模。样本出现的时间顺序对于自然语言处理、语音识别、手写体识别等应用非常重要。

感知机:输入层、输出层和一个隐含层。

输入的特征向量通过隐含层变换达到输出层,在输出层得到分类结果;

使用离散的传输函数;

多层感知器:= 神经网络

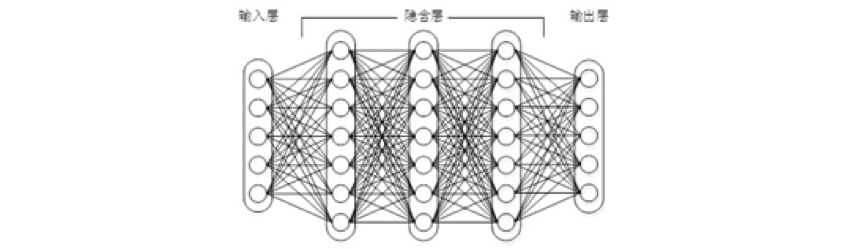

上图展示了多层感知器的结构

使用sigmoid或tanh等连续函数模拟神经元对激励的相应

训练算法:反向传播BP算法

神经网络的层数直接决定了它对现实的刻画能力。但是随着神经网络层数的加深,优化函数越来越容易陷入局部最优解。

同时,另一个不可忽略的问题是随着网络层数增加,“梯度消失”现象更加严重。即,对于幅度为1的信号,在BP反向传播时,每传递一层,梯度衰减为原来的0.25。层数一多,梯度指数衰减后底层基本上接收不到有效的训练信号。

深度学习:

利用预训练方法缓解了局部最优解问题,将隐含层推动到更多层;

为了克服梯度消失,ReLU、maxout等传输函数代替了sigmoid,形成了DNN的基本形式;

单从结构上来说,全连接的DNN和上图的多层感知器是没有任何区别的。

存在的问题:全连接DNN 的结构里下层神经元和所有上层神经元都能够形成连接,导致的潜在问题是参数数量的膨胀。

CNN卷积神经网络:

图像中有固有的局部模式(比如轮廓、边界、眼睛)可以利用,显然应该将图像处理中的概念和神经网络技术形结合。 得到卷积神经网络CNN;

CNN中,不是所有上下层神经元都能直接相连,而是通过“卷积核”作为中介。同一个卷积核在所有图像内是共享的,图像通过卷积操作后仍然保留原来的位置关系;

RNN 循环神经网络:

应对全连接的DNN 存在的一个问题:无法对时间序列上的变化进行建模。样本出现的时间顺序对于自然语言处理、语音识别、手写体识别等应用非常重要。

相关文章推荐

- 常用网络术语 && HTTP协议的几个重要概念 && HTTPS传输协议

- 人工神经网络基础概念、原理知识(补)

- 神经网络学习笔记-01-基本概念

- 神经网络概念理解

- 神经网络一些概念

- 计算机网络中的几个重要概念

- 深度神经网络概述:从基本概念到实际模型和硬件基础

- 结合sklearn的例子理解神经网络的基本概念

- 神经网络 之 感知器的概念和实现

- 神经网络模型符号解释!!!蛮重要的,记不住的可以参考下。

- 有趣的机器学习概念纵览:从多元拟合,神经网络到深度学习,给每个感兴趣的人

- 神经网络(一):概念

- 神经网络学习笔记-01-基本概念

- Deep Learning 学习系列001 —— 神经网络基本概念

- 计算机网络运输层重要概念

- 神经网络基本的一些概念

- 神经网络读书笔记:《神经网络与机器学习/Simon Haykin》导言概念总结

- 计算机网络(七)--重要概念

- 网络编程基础--重要概念介绍