Machine Learning week3

2016-07-19 15:43

344 查看

逻辑回归(Logistic Regression)

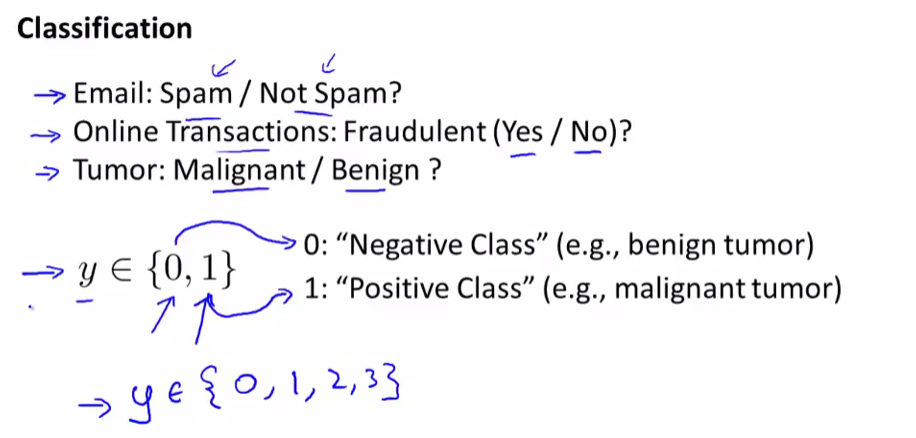

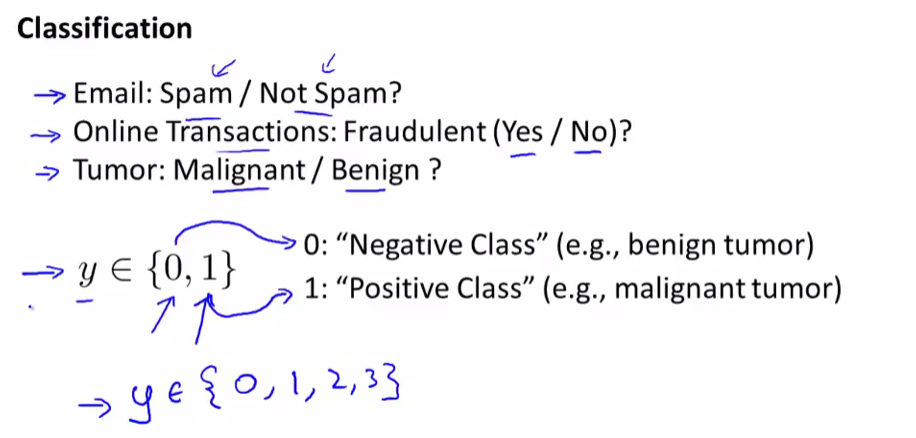

逻辑回归是用来解决分类问题的一种分类算法,适用于标签y取值离散的情况

Classification(分类问题):二元分类问题、多元分类问题

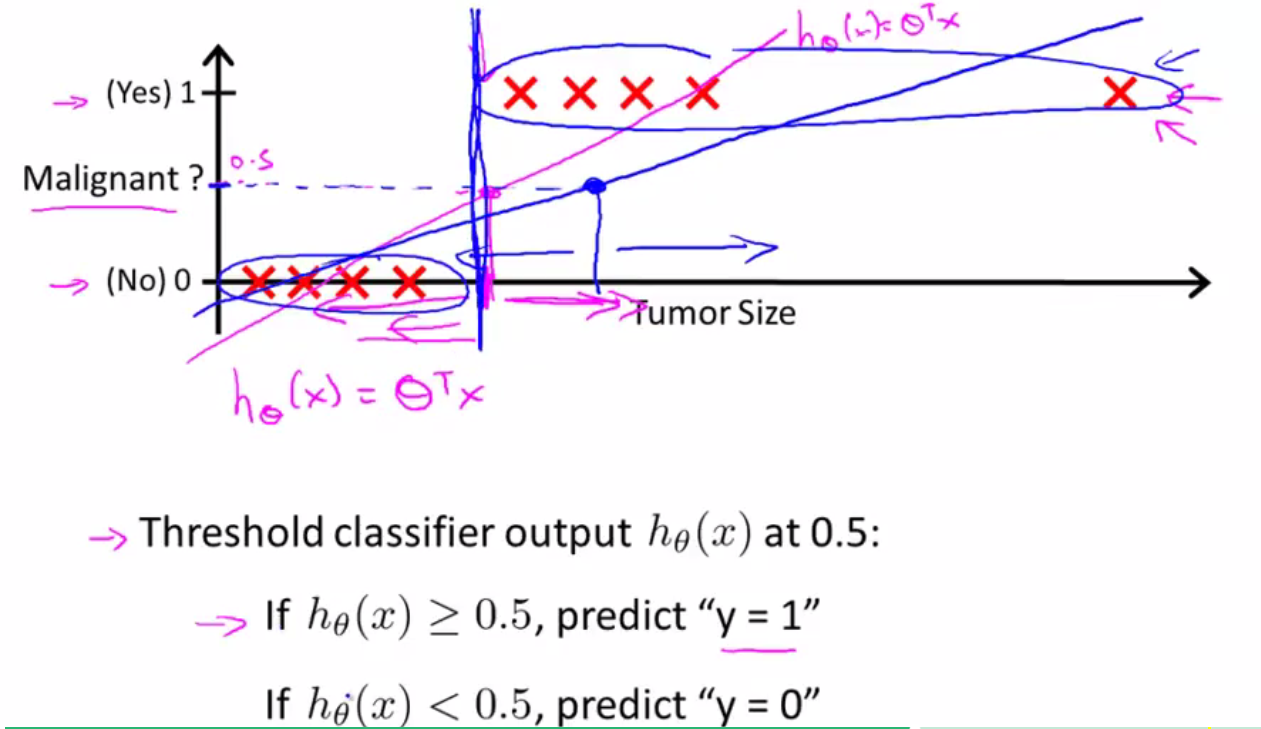

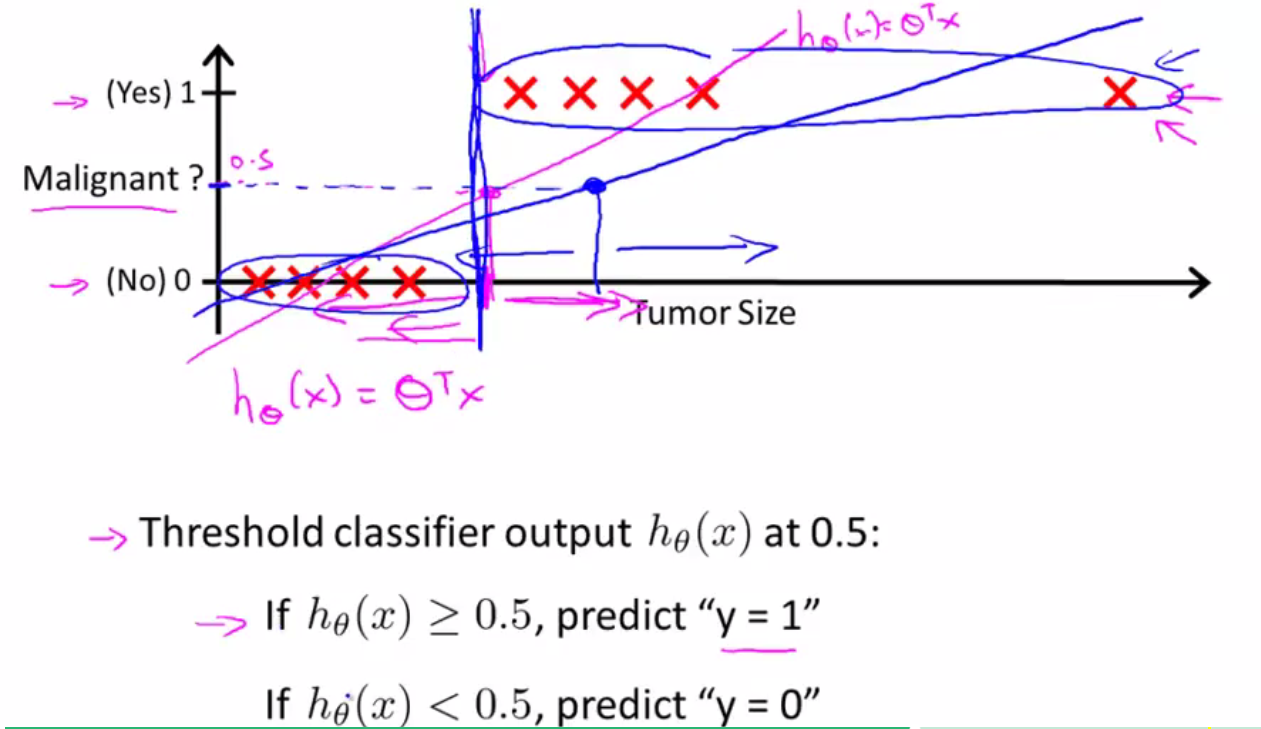

线性回归不适合用来解决分类问题:

1、在分类问题中y值取0或者1,但是线性回归的预测值可以存在>1或者<0,二者相矛盾

2、线性回归对点的拟合度不是很好

3、如果出现离群点(最右边的红色X),那么很容易将线性回归的图像的拟合度大幅降低

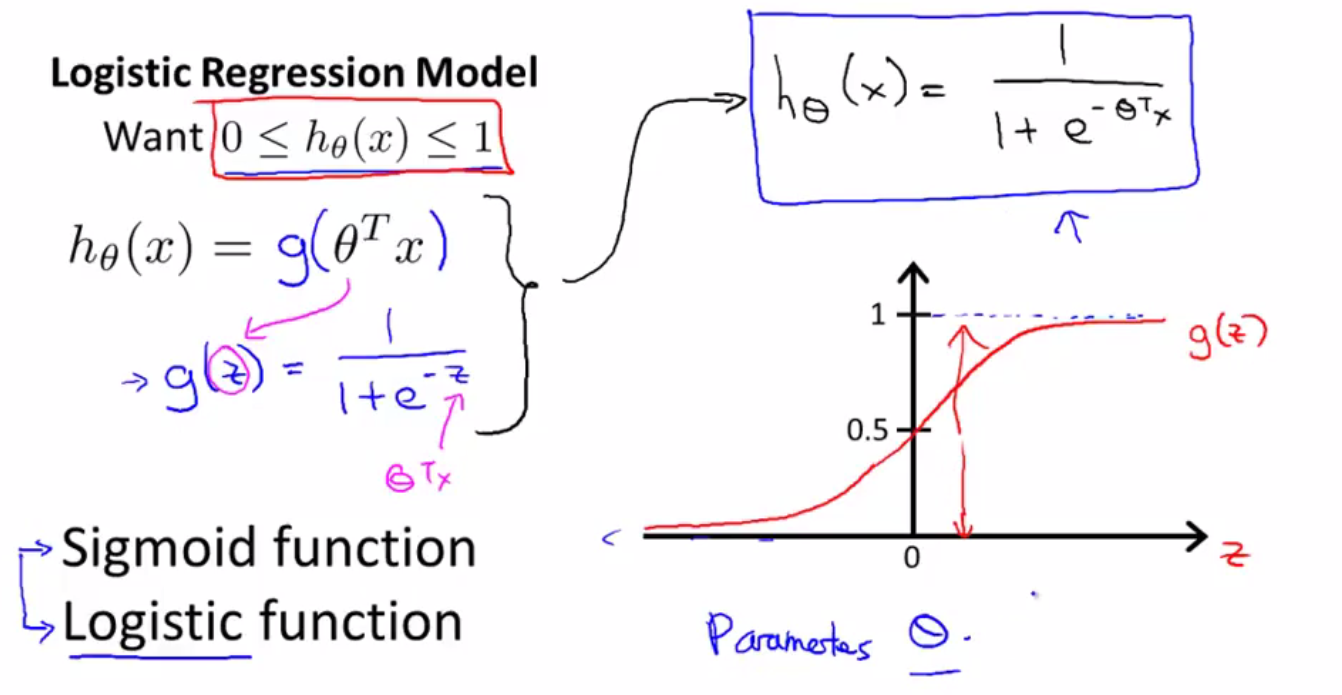

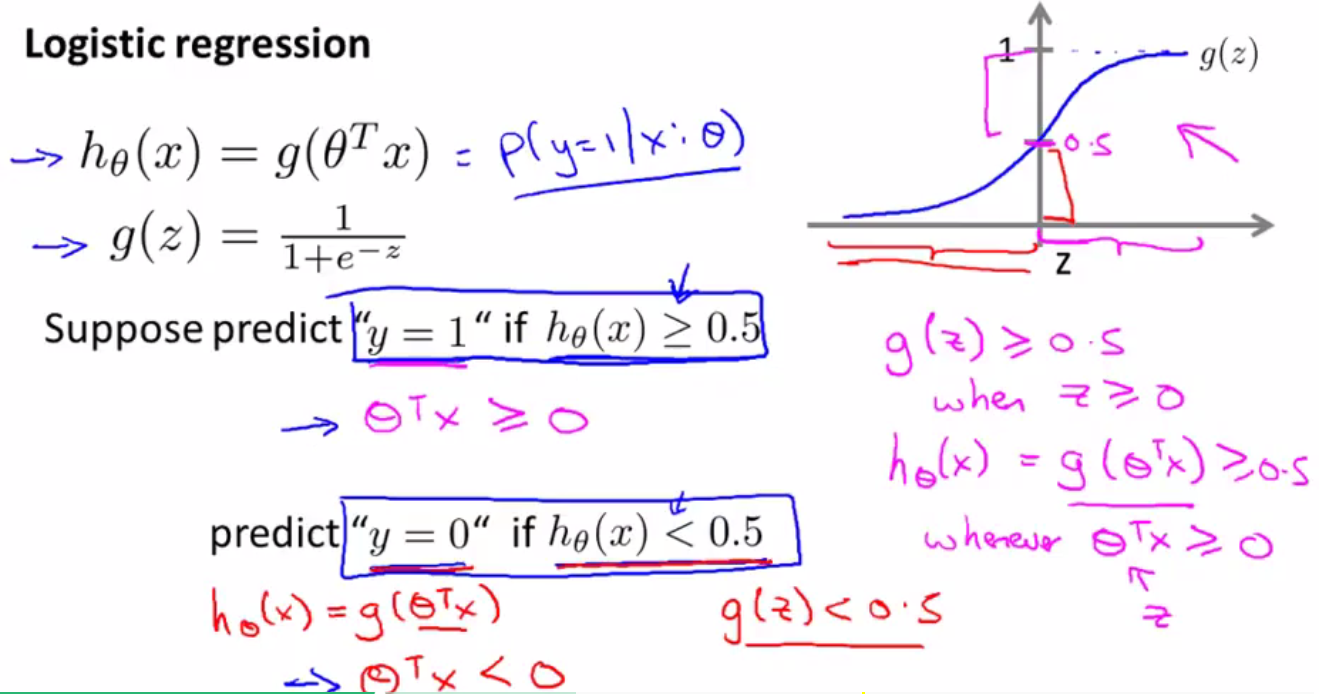

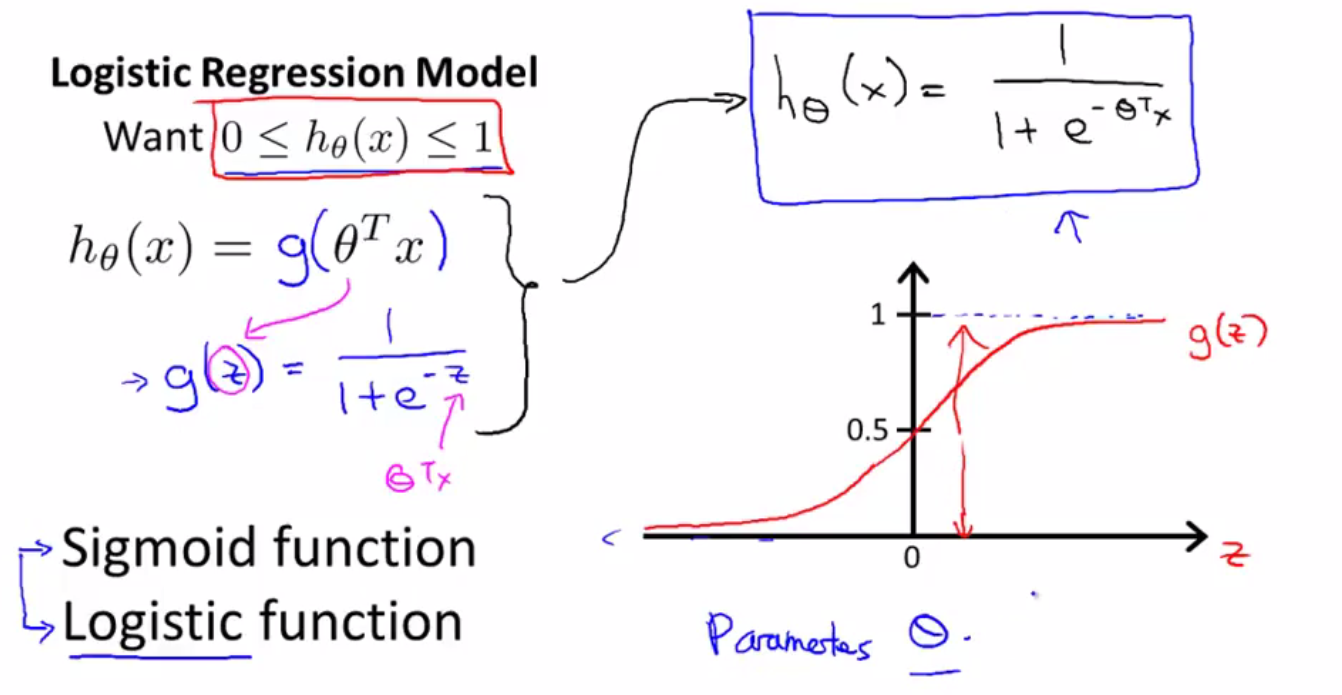

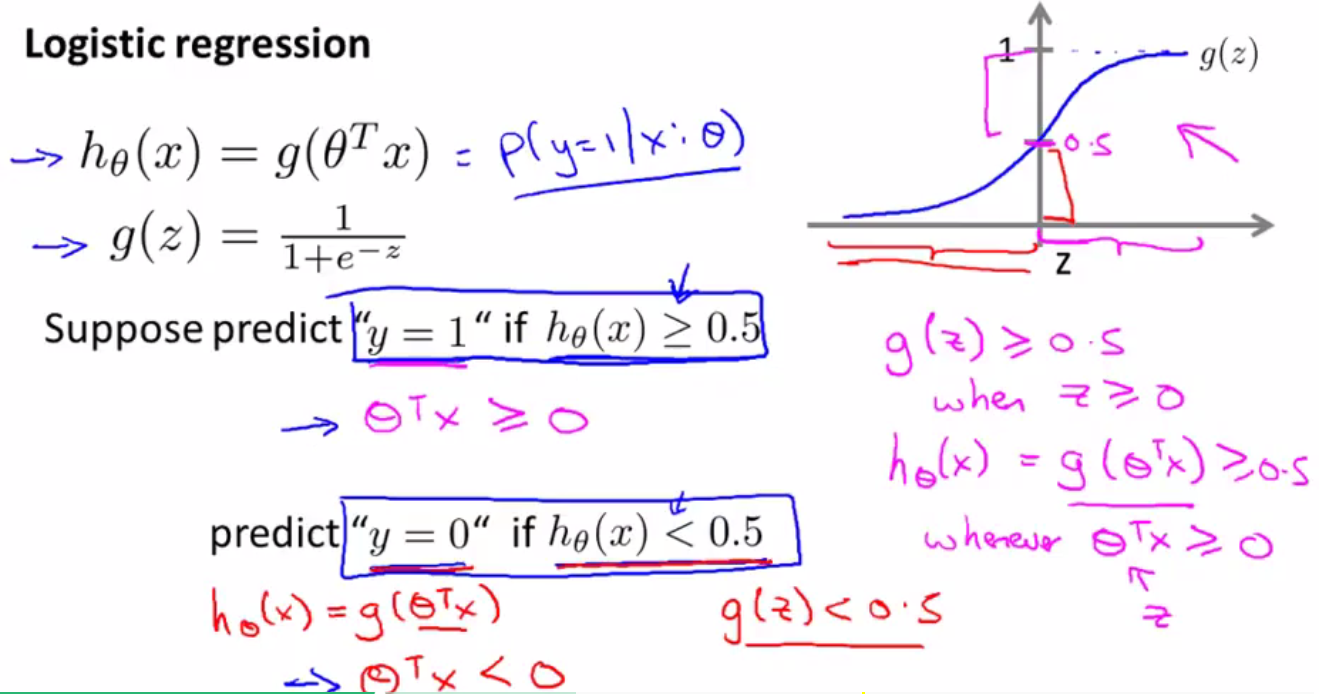

逻辑回归中假设函数的表示(Hypothesis Representation):

S型函数(Sigmoid function)、逻辑函数(Logistic Function)是指代同一个东西

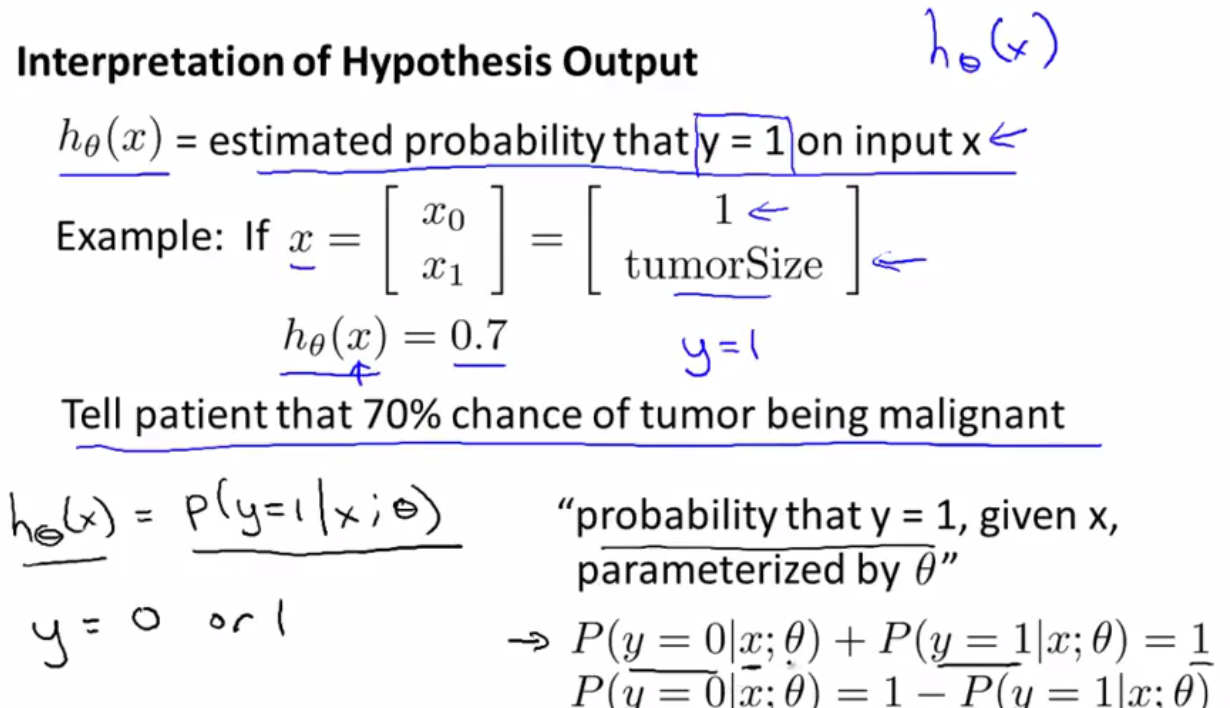

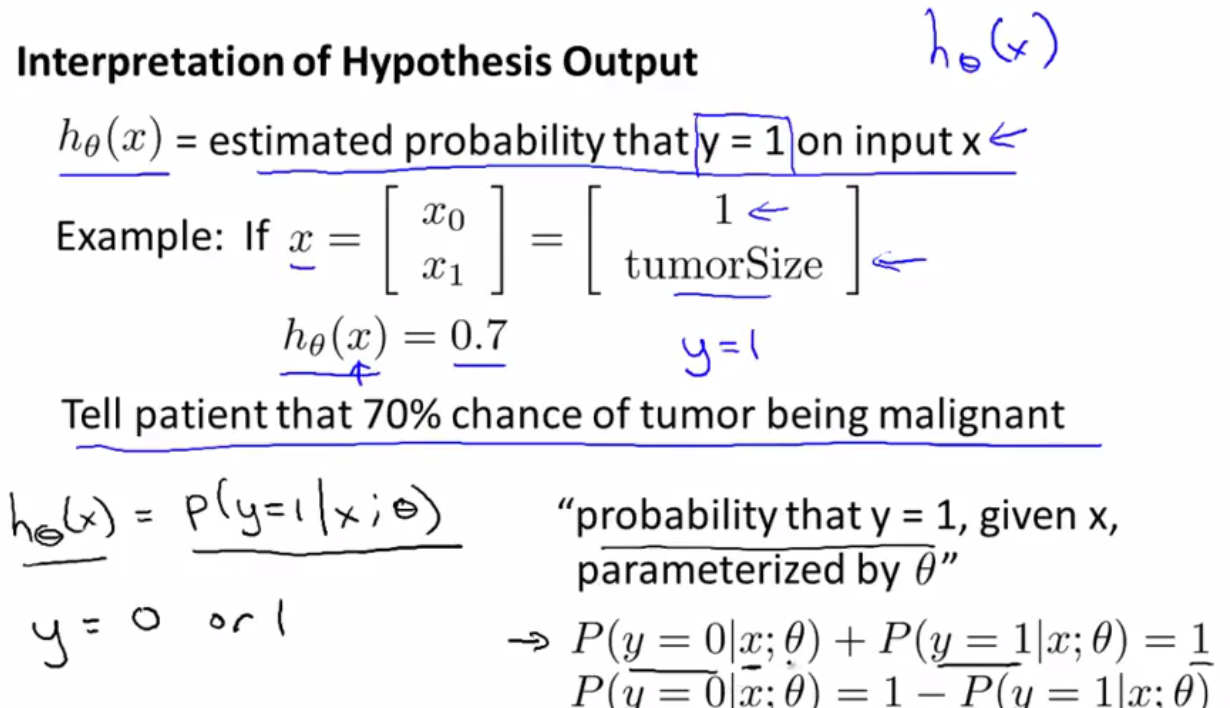

对逻辑函数的输出值的解释:

输出值如果为0.7的话,表明在给定参数theta、特征值x1(肿瘤的大小)的情况下,病人肿瘤为恶性的概率为0.7。

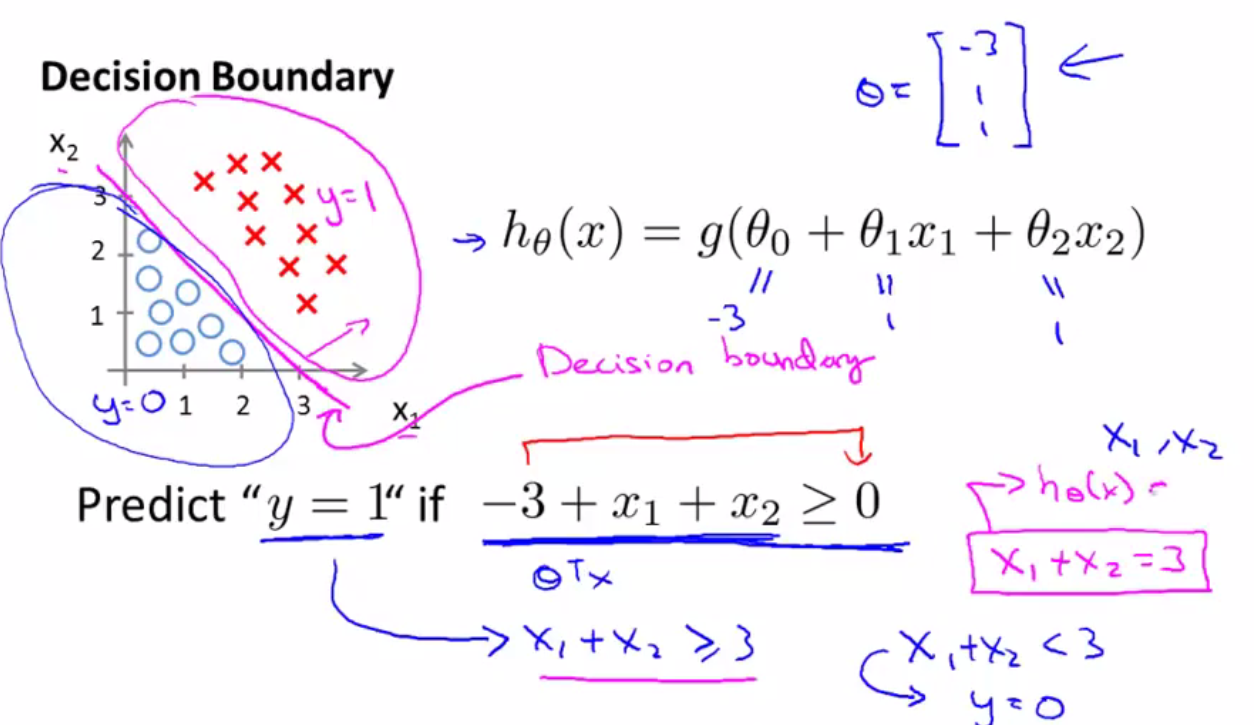

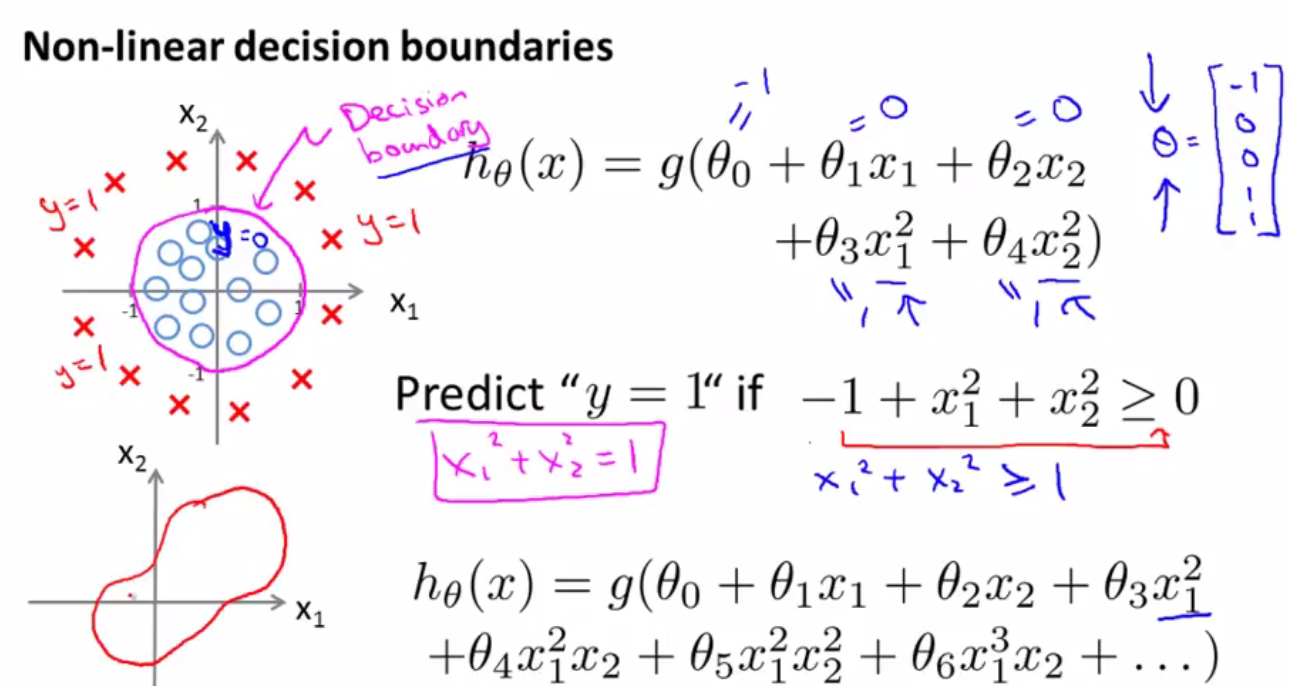

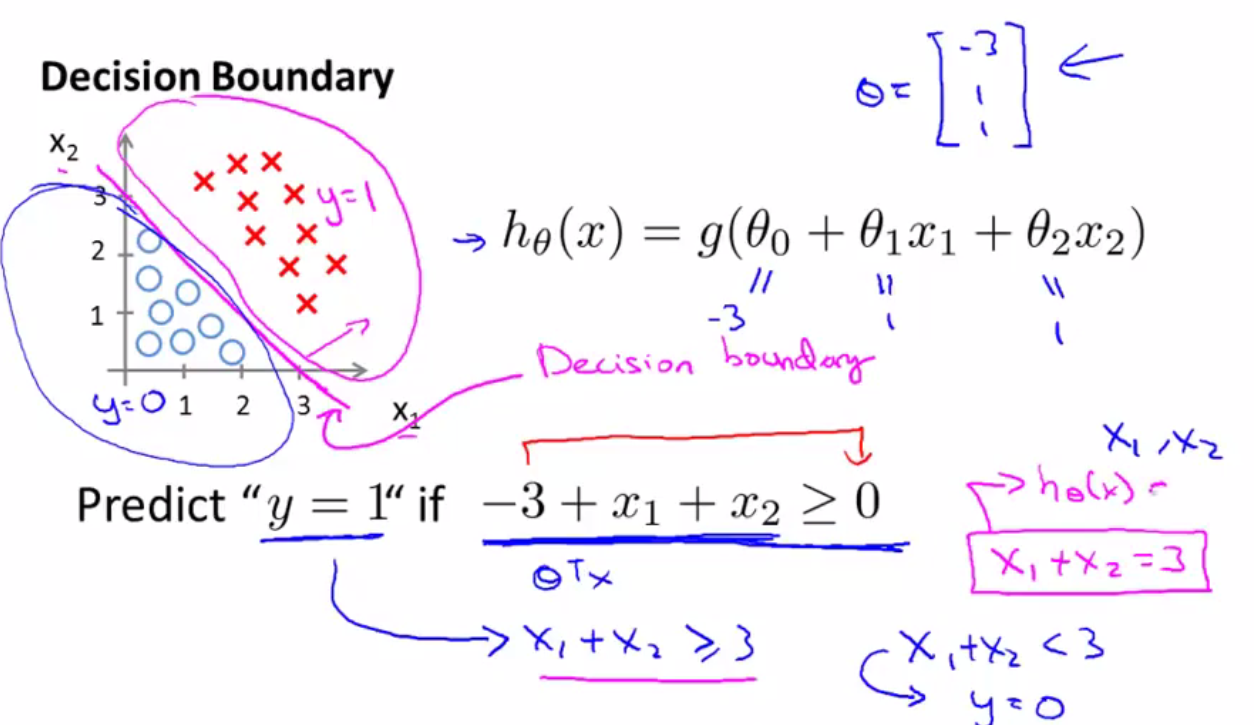

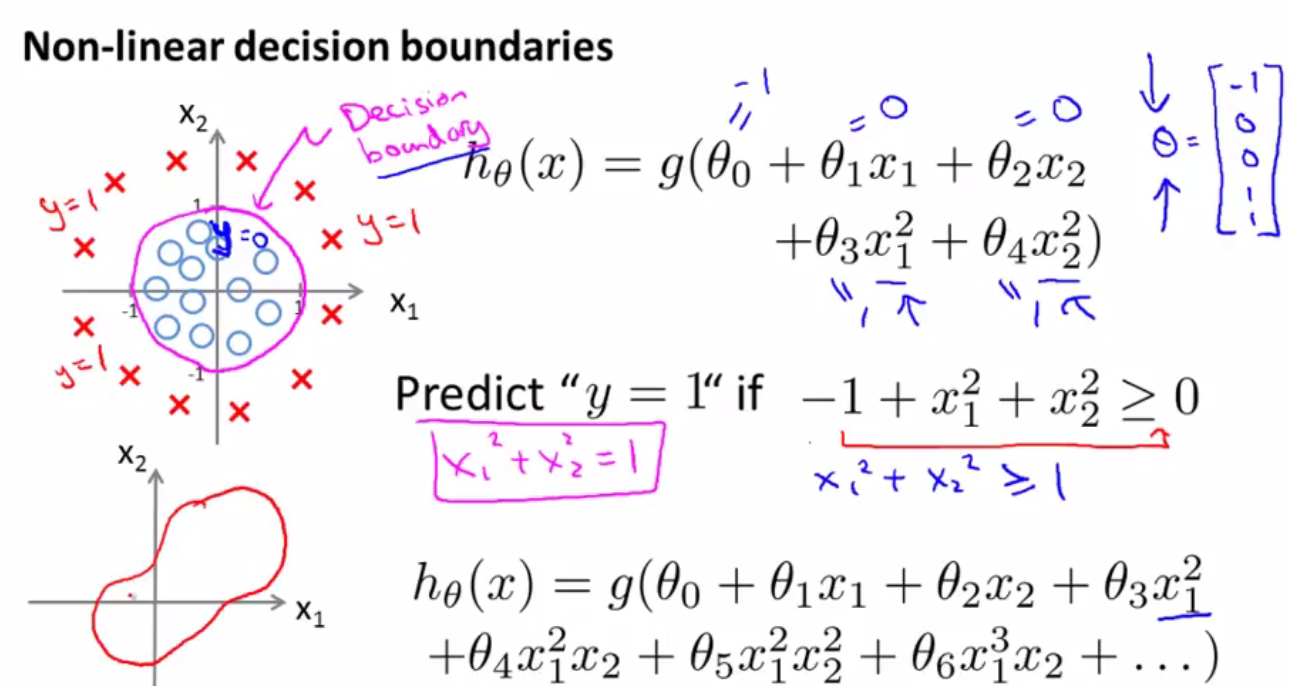

决策边界(Decision boundary)

由逻辑函数的图像可以看出:

当z>=0时,g(z)>=0.5≈1

当z<0时,g(z)<0.5≈0

所以,可以令z=0,来求得一根线,那根线就是决策边界

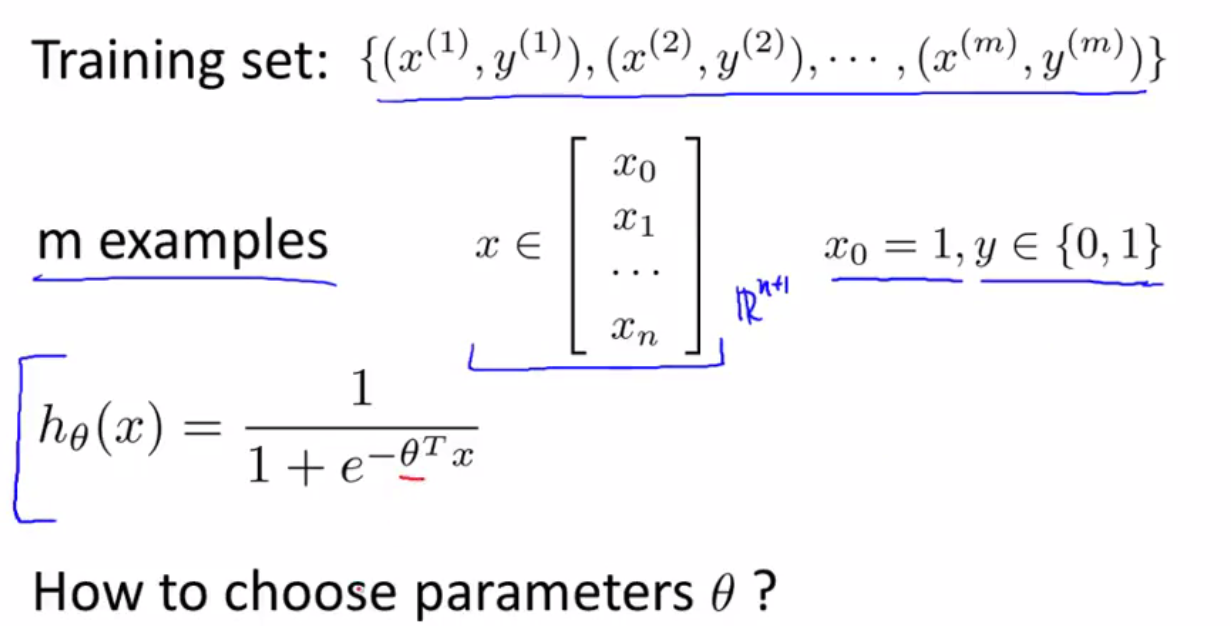

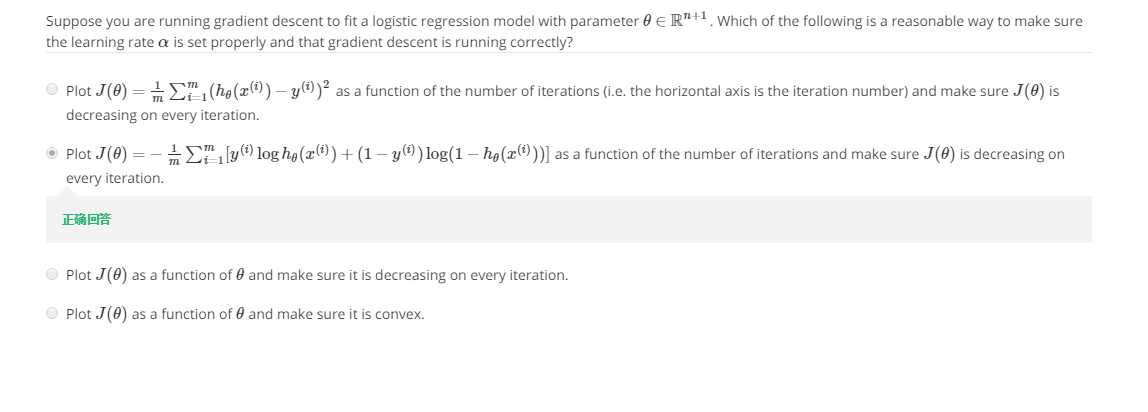

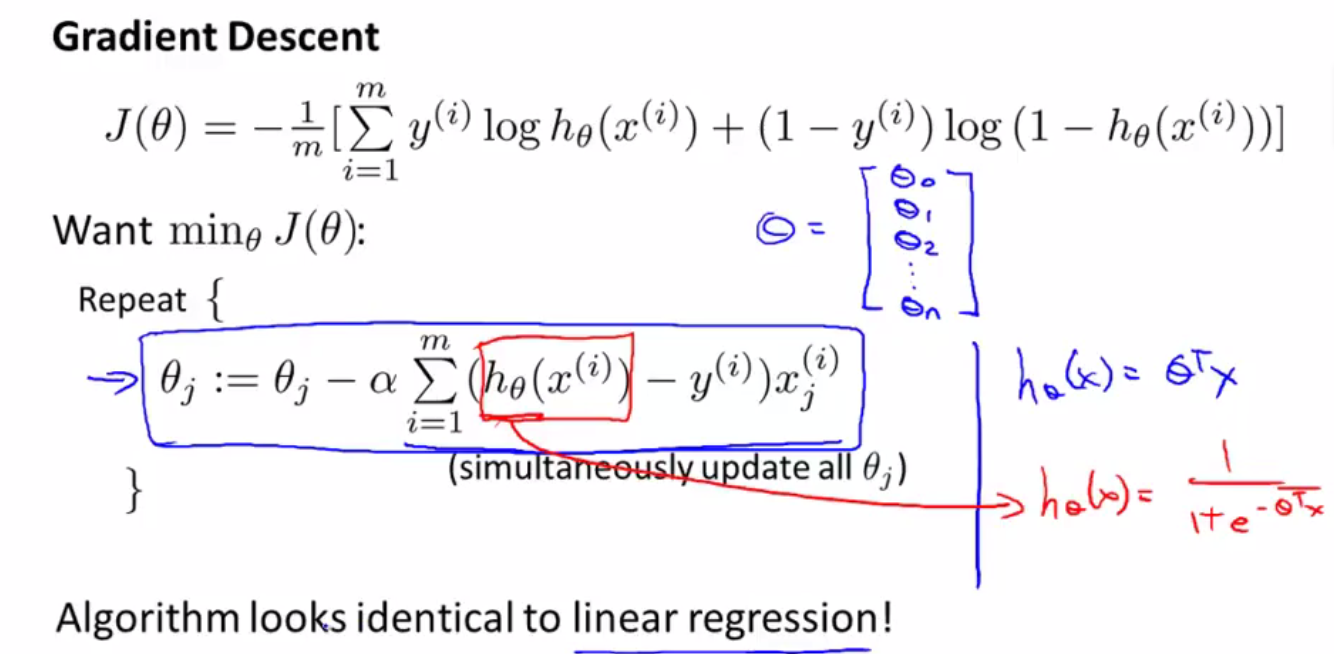

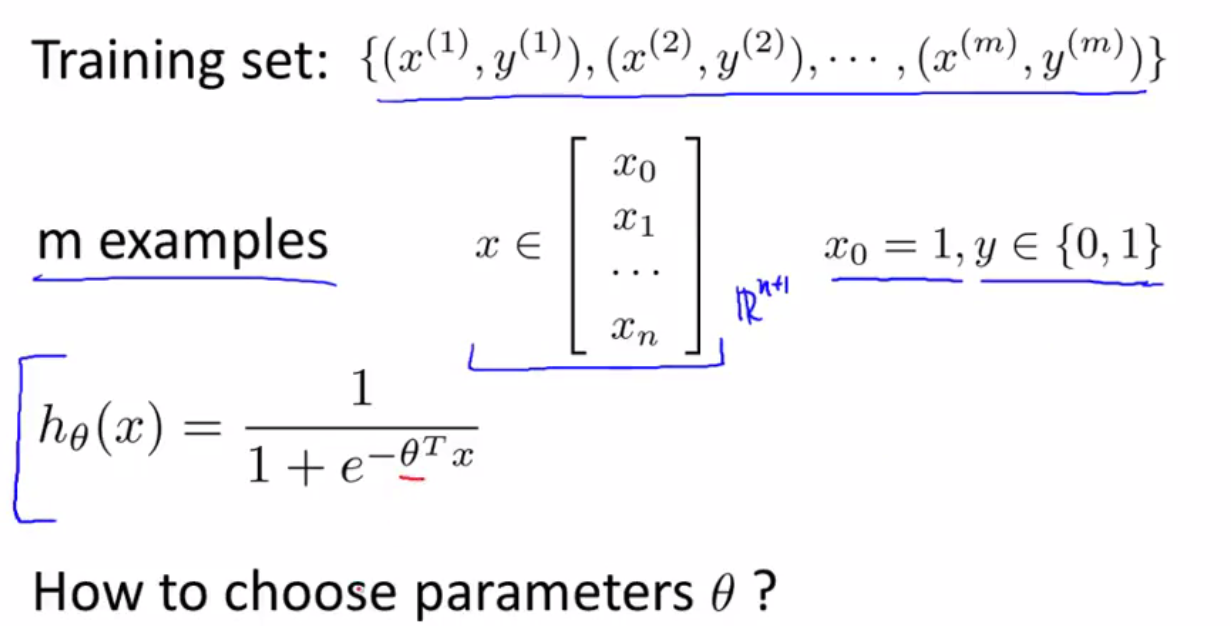

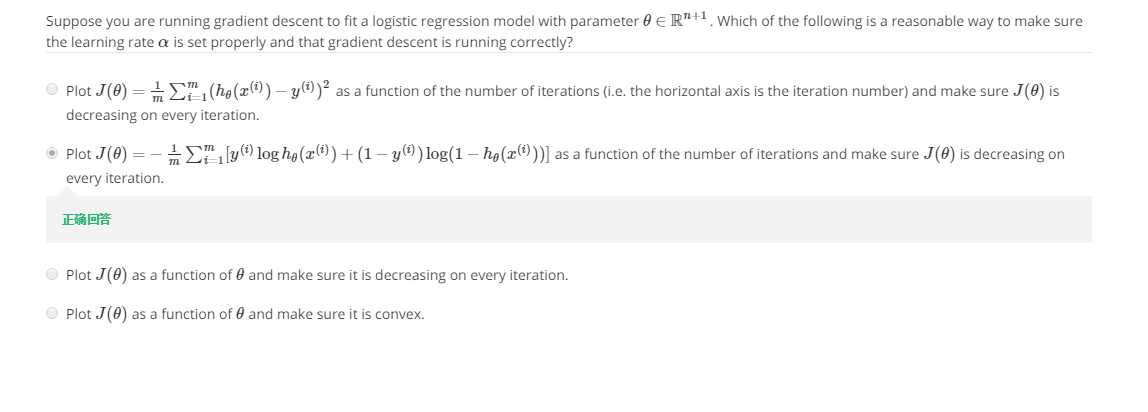

如何寻找合适的theta值来拟合数据集:

数据集有m组数据,有n个特征(feature),y取值为0或1,假设函数h(x)

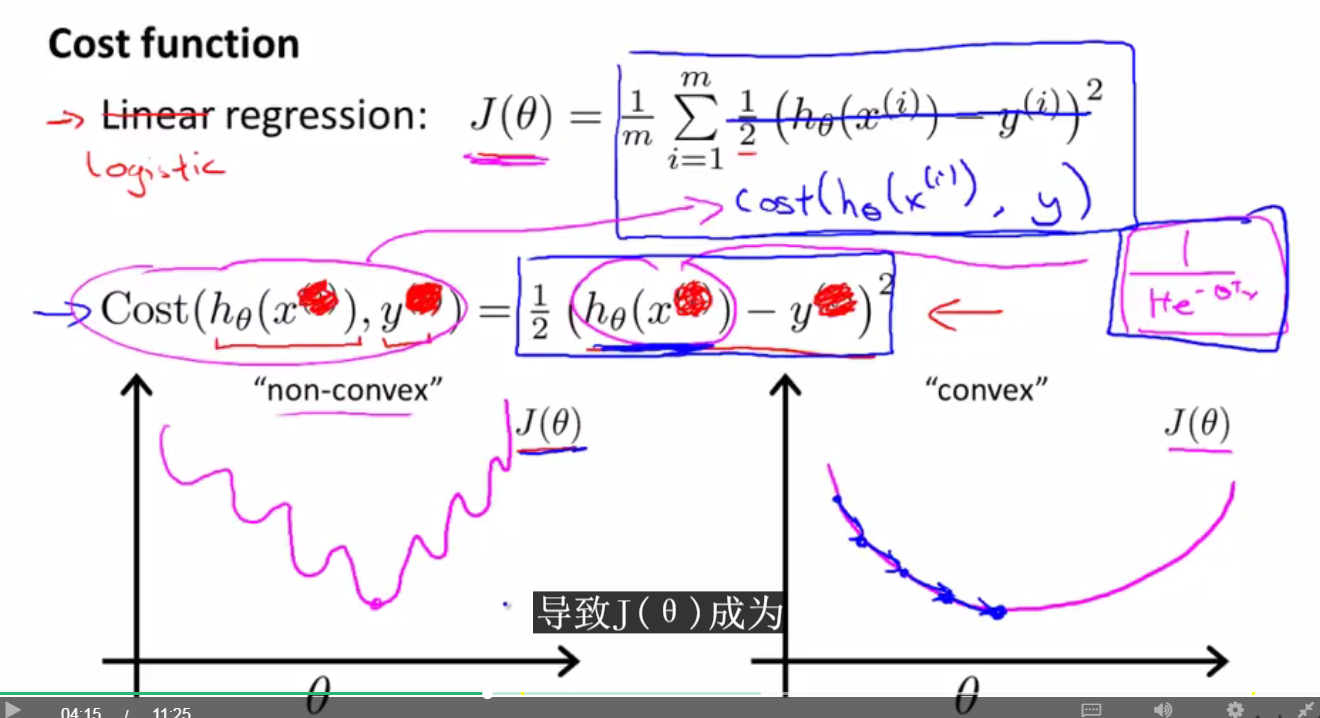

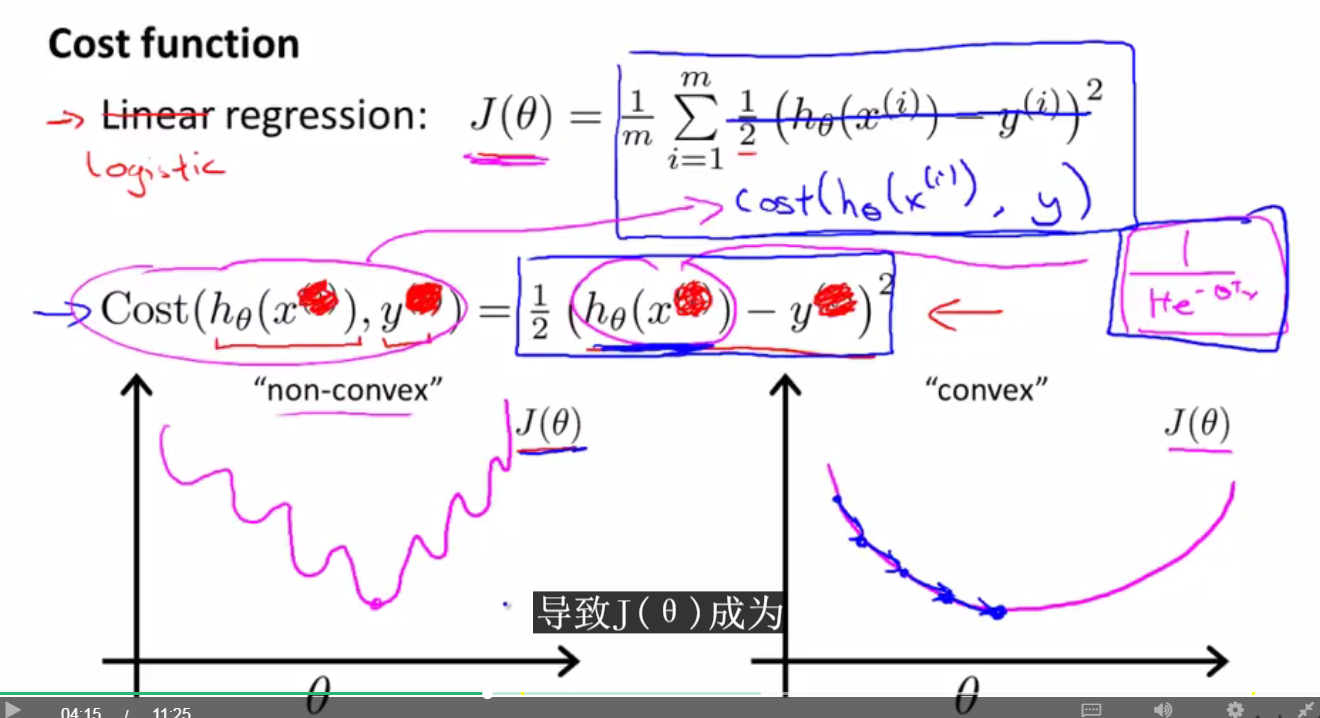

按照线性回归的步骤求得逻辑回归的代价函数(Cost Function) J(theta),通过函数图像发现它是一个非凸函数(non-convex function),存在很多局部最小值。所以对于逻辑回归,我们使用另外的代价函数。

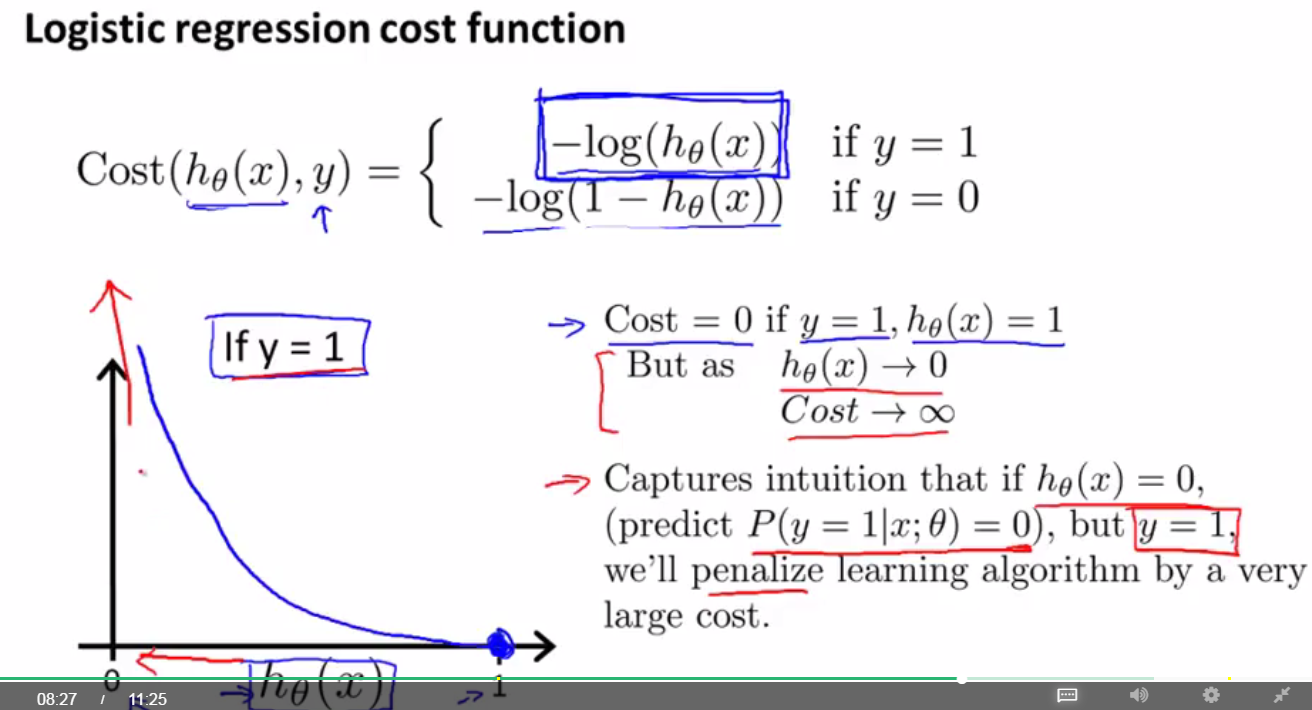

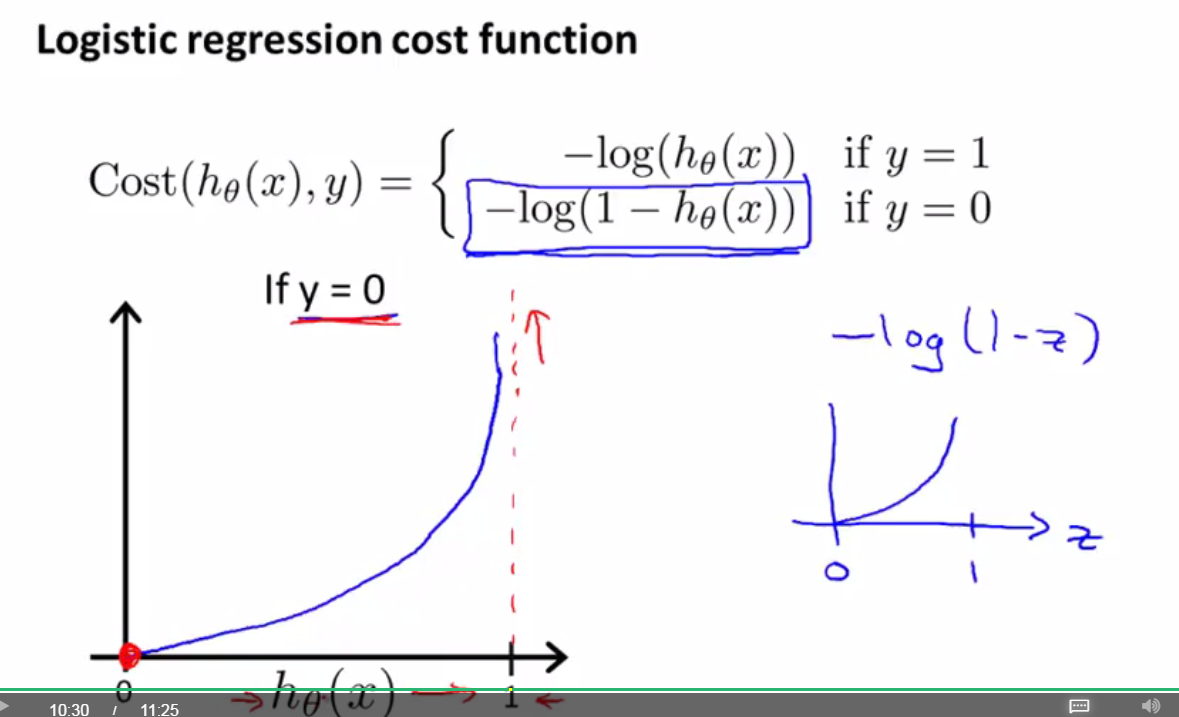

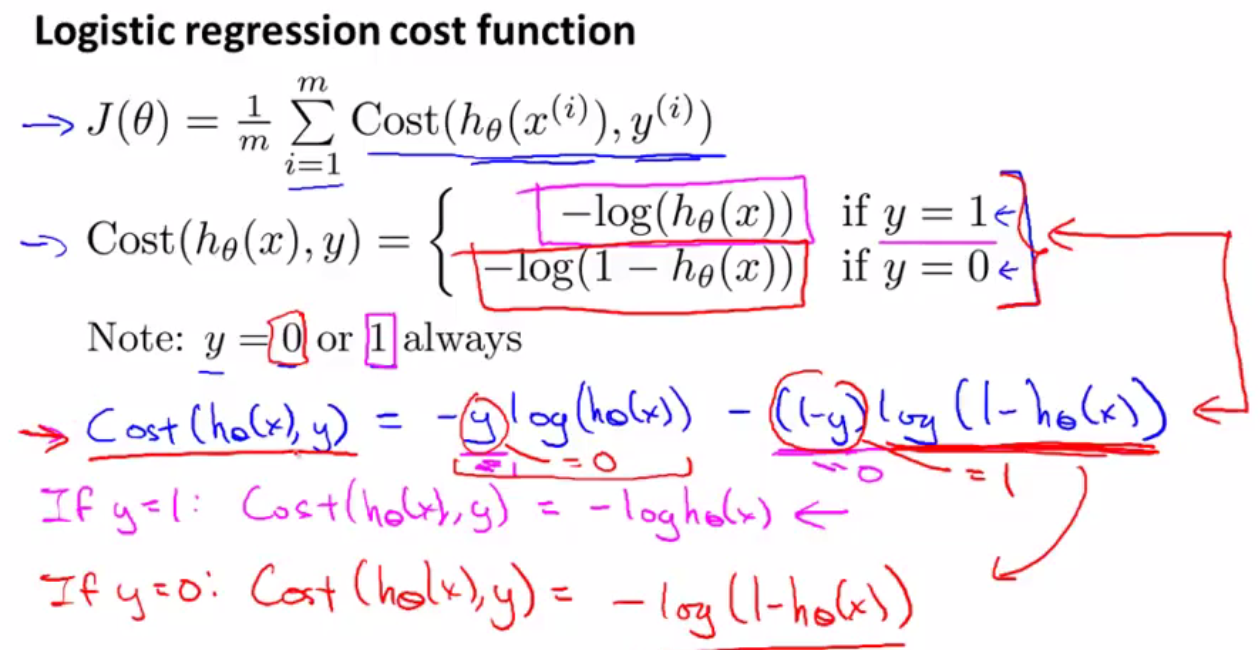

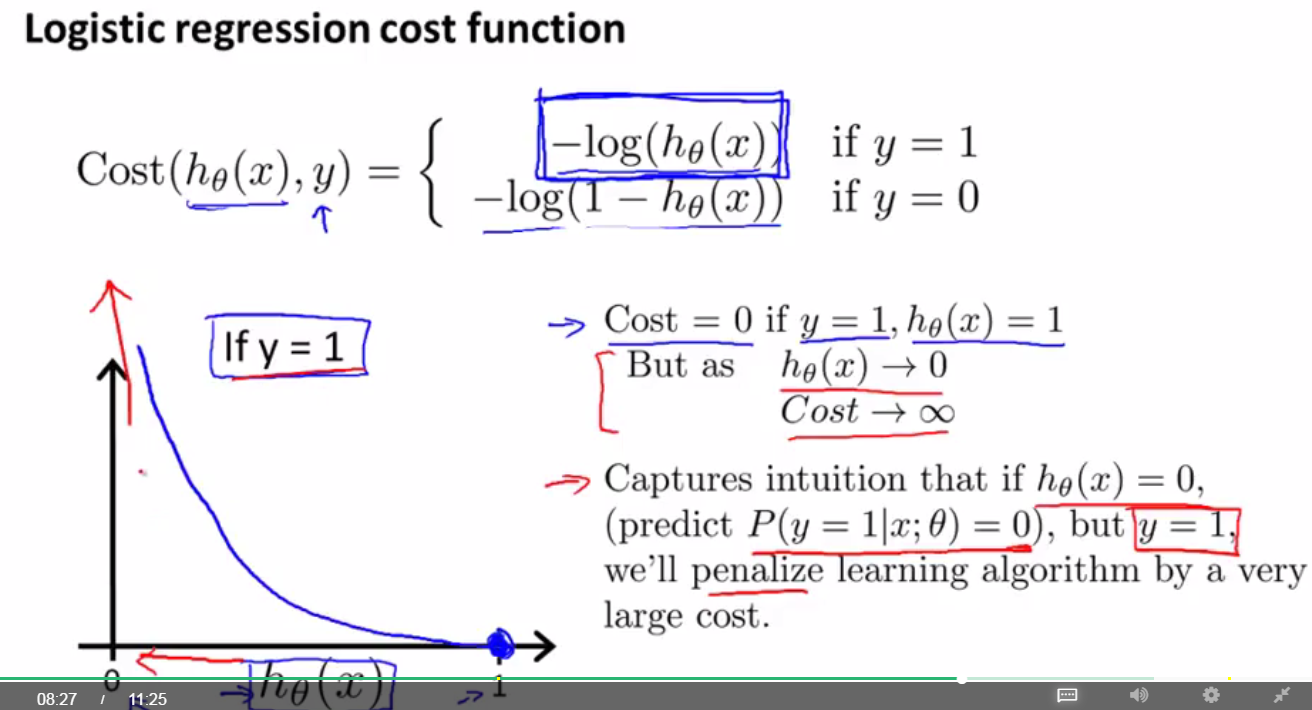

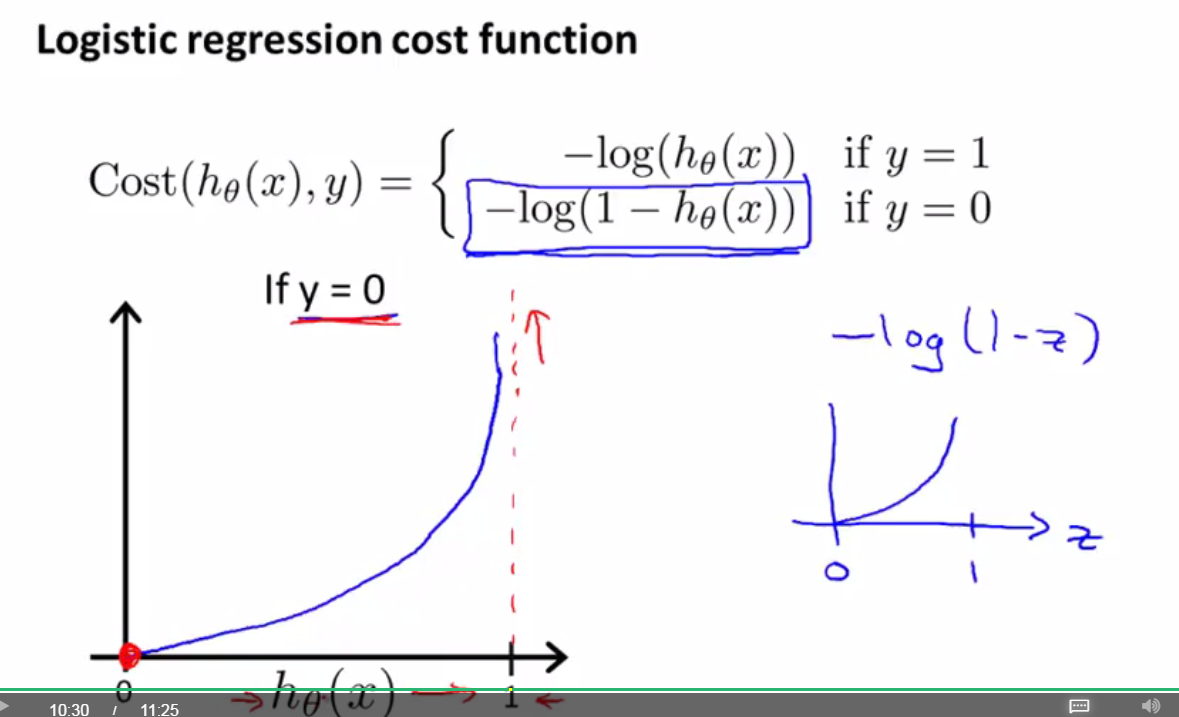

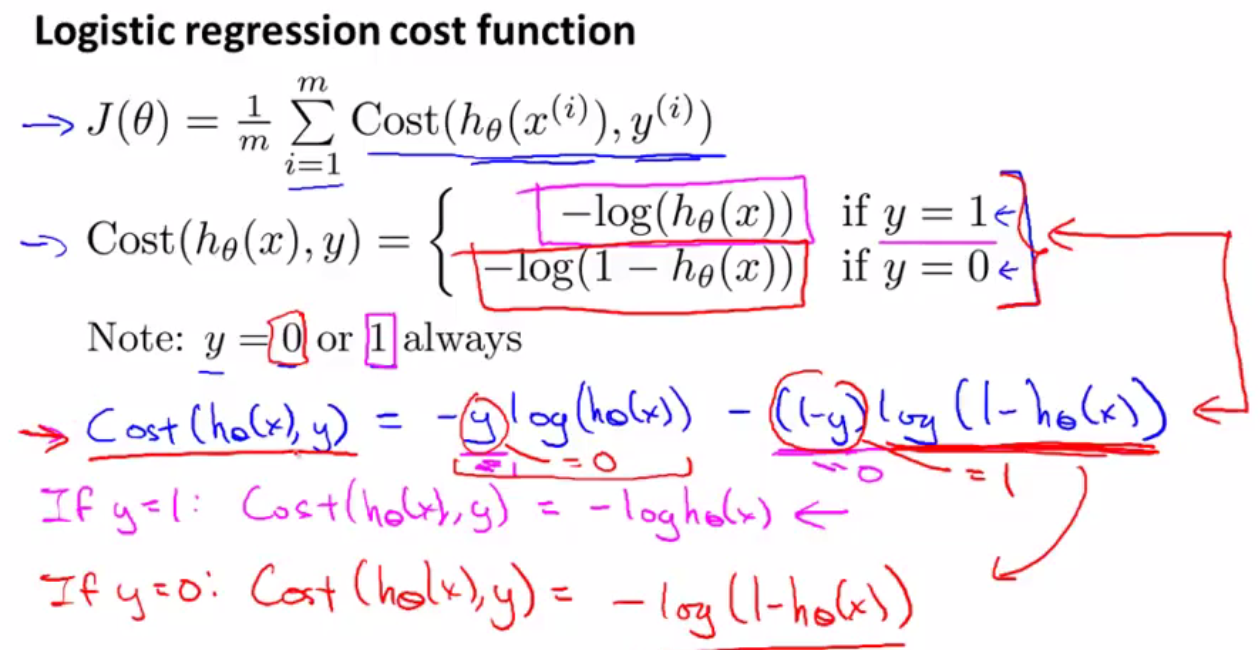

逻辑回归的代价函数如下所示:

当y=1时,如果h(theta)=1,就是说我们的假设函数计算出来的数值(肿瘤为恶性的概率)与实际的数值完全一样,那么J(theta)=0,对应右下角的蓝色点。如果当y=1时,h(theta)=0,就是说预测的数值与实际情况完全相矛盾,完全不符合,那么从图像上可以看到J(theta)=无穷大,意味着我们需要付出很大的代价。

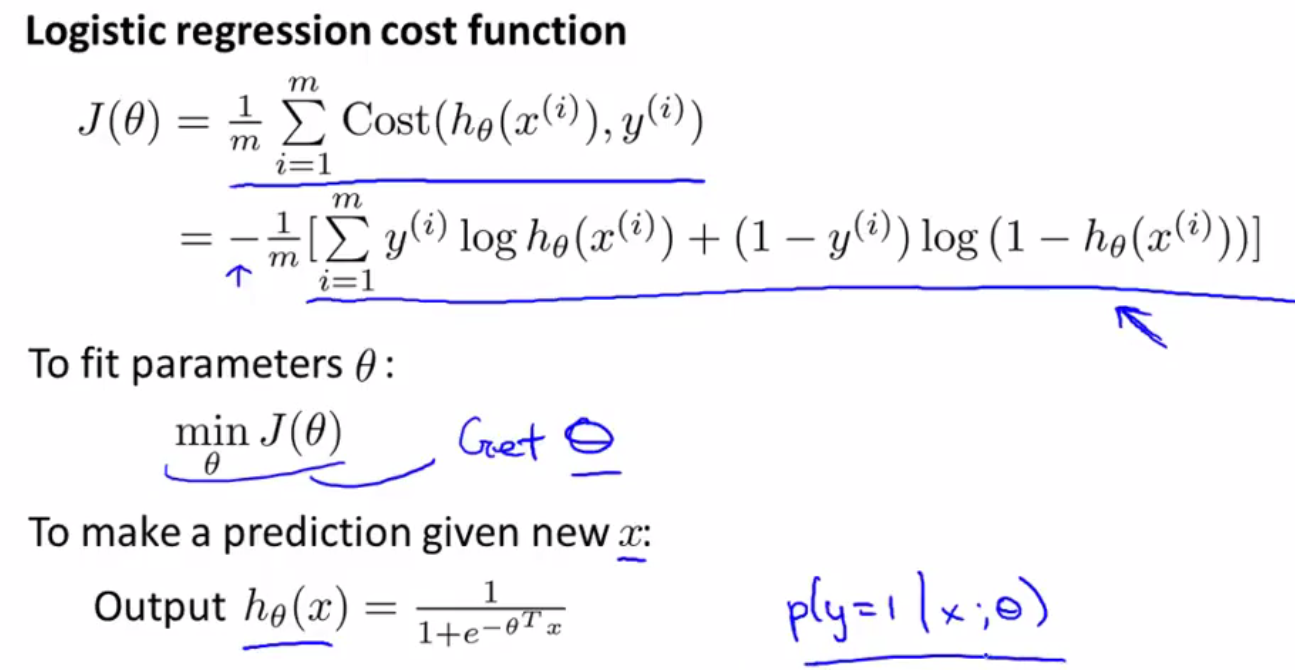

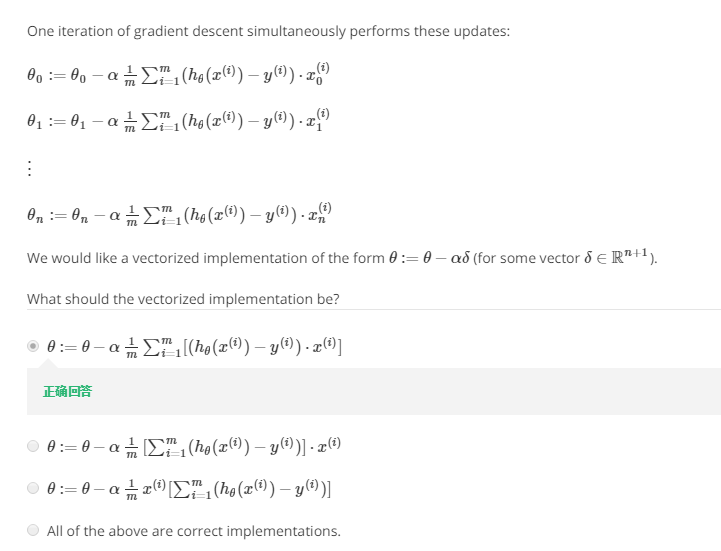

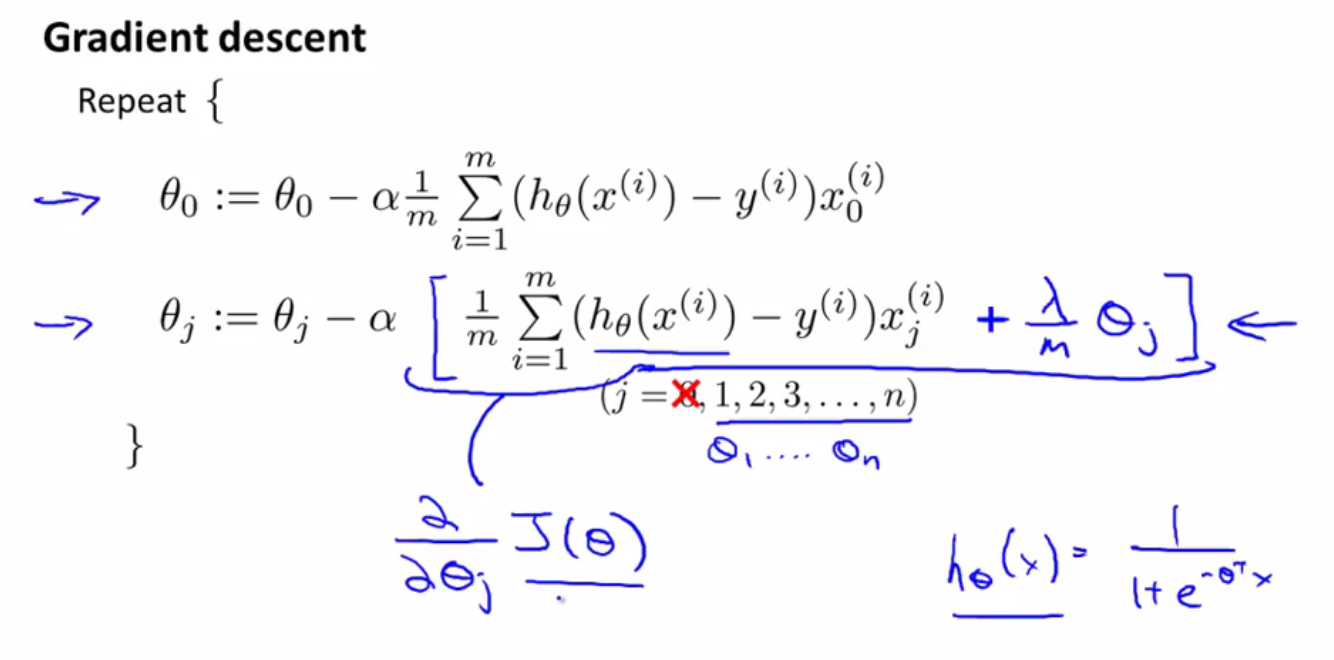

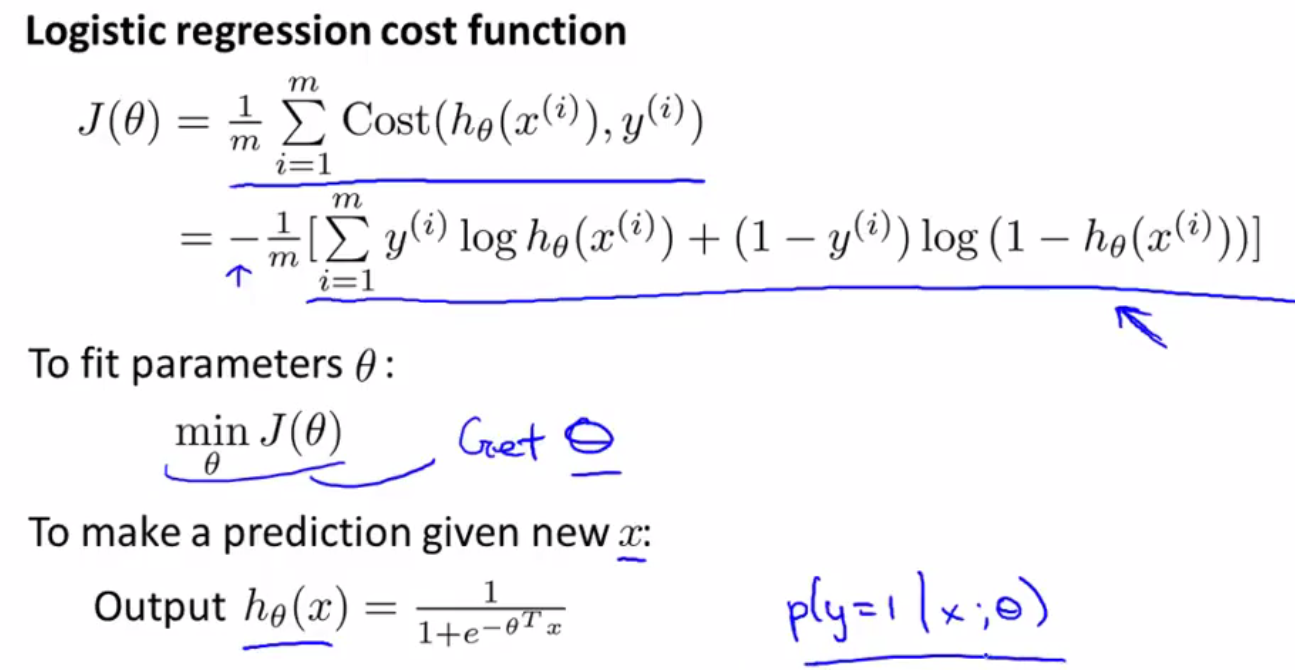

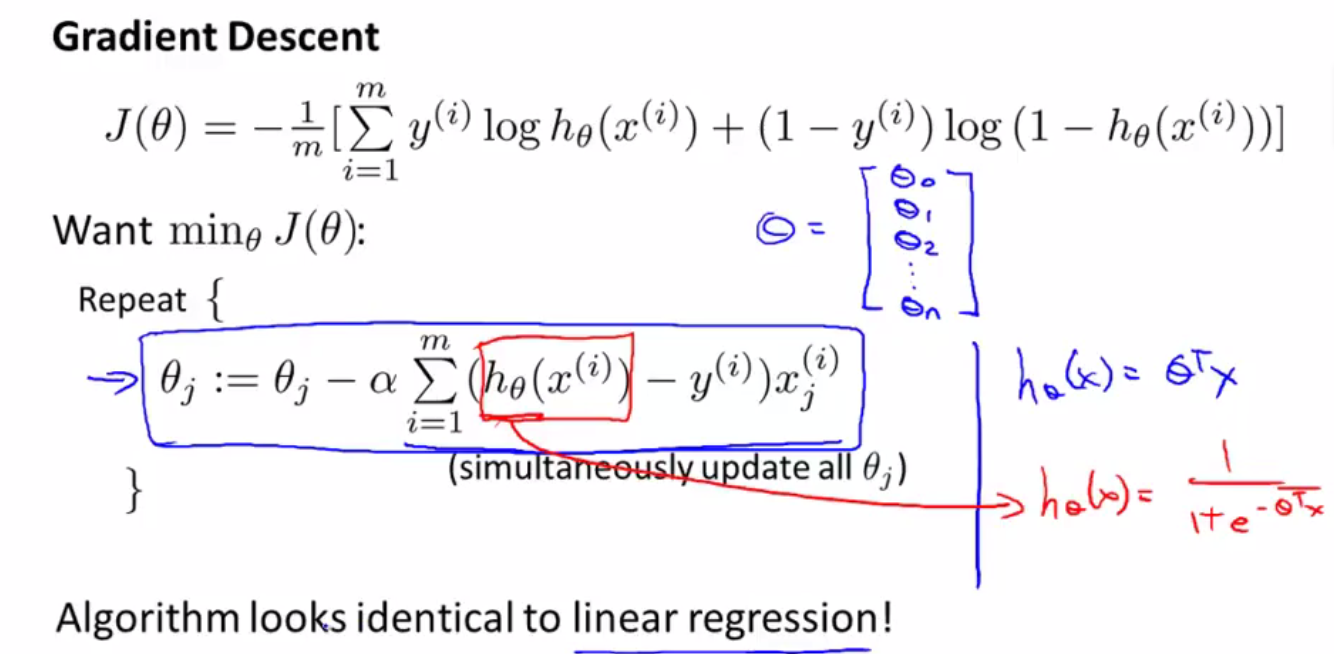

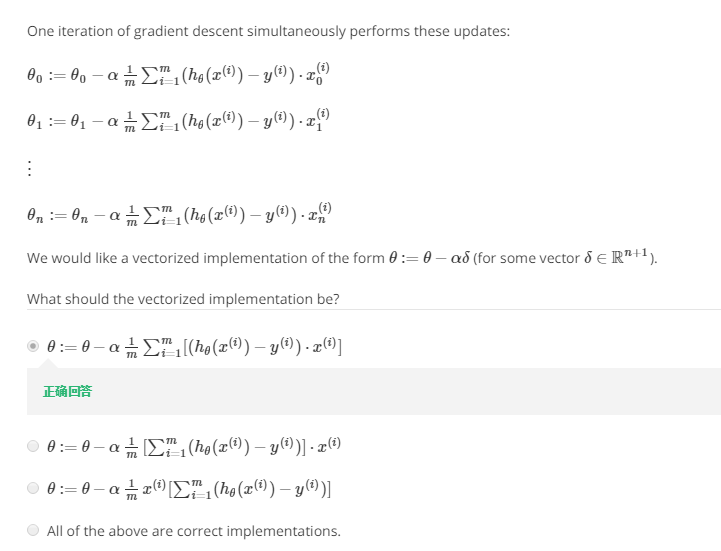

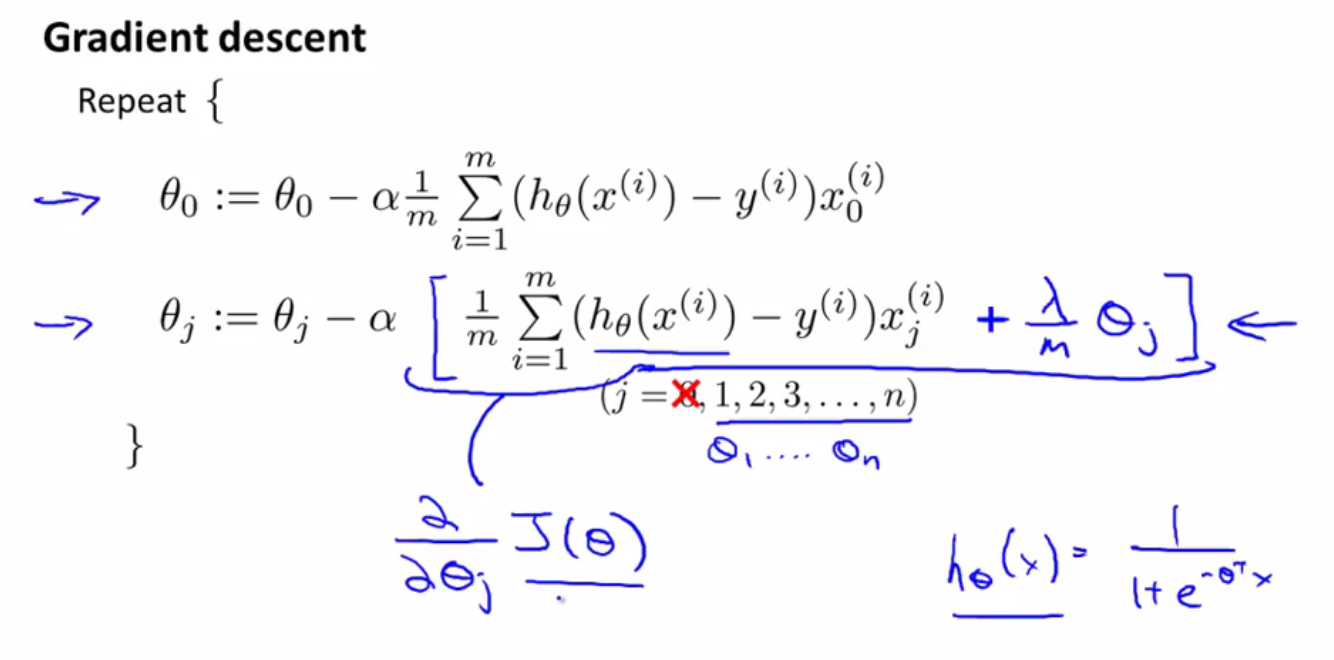

使用梯度下降法来拟合逻辑回归的参数

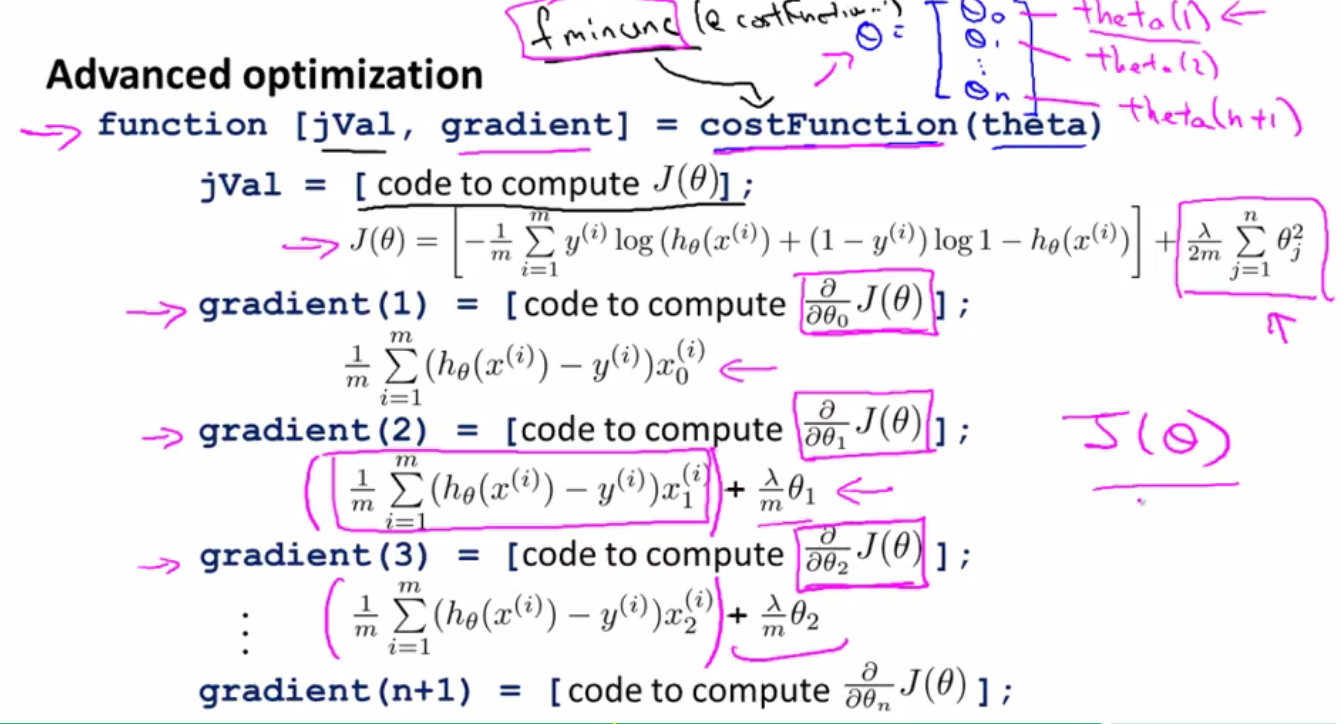

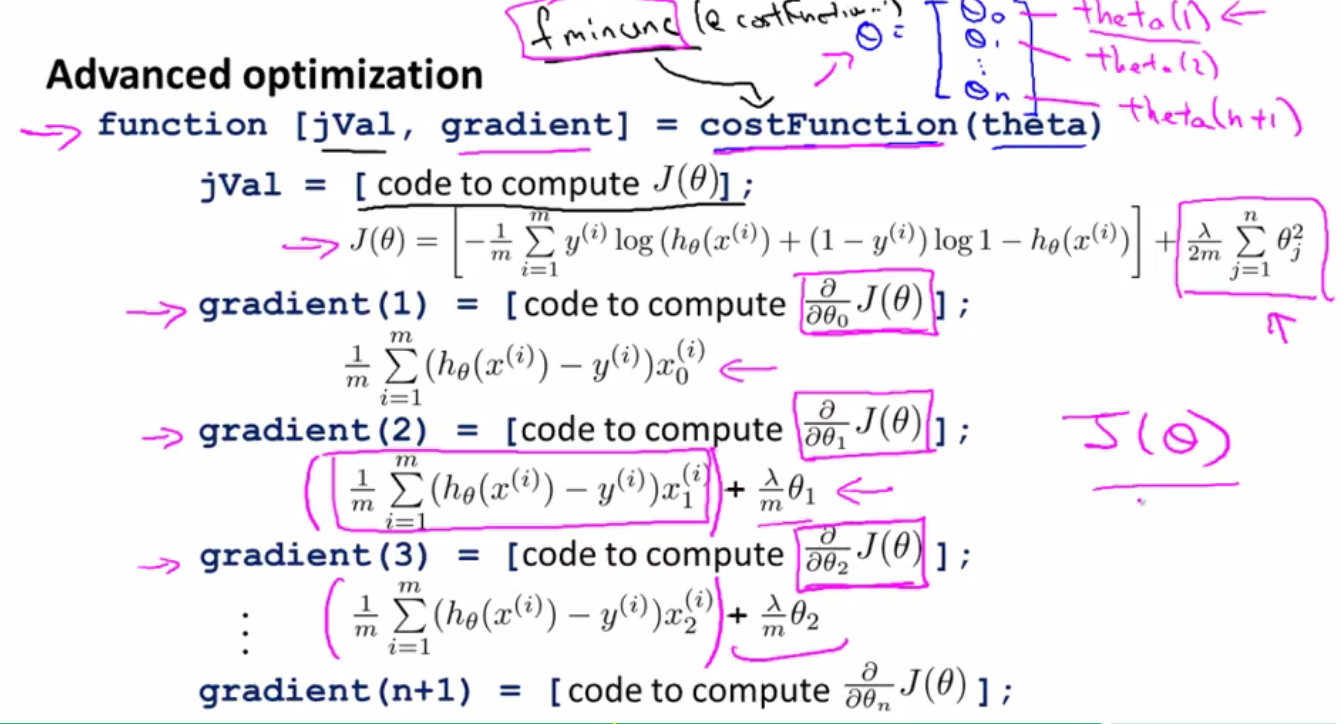

高级优化算法

只需要学会使用即可,不需要理解,具体操作在第三周第二节课

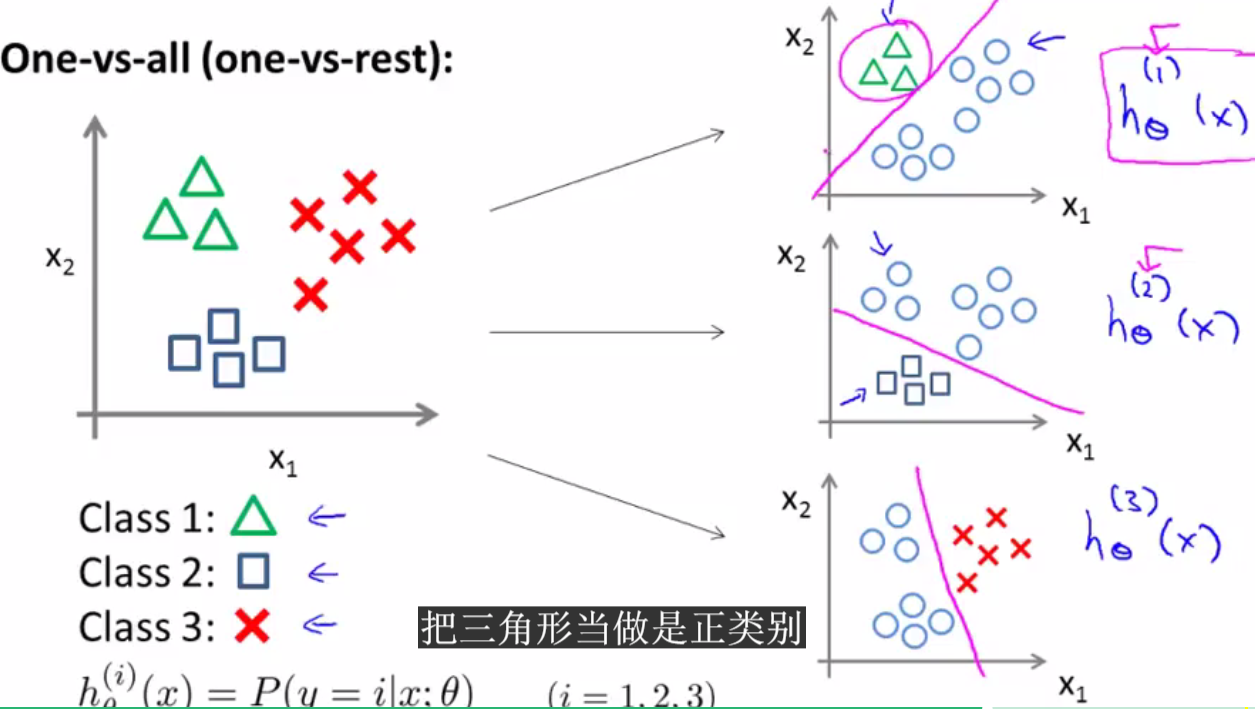

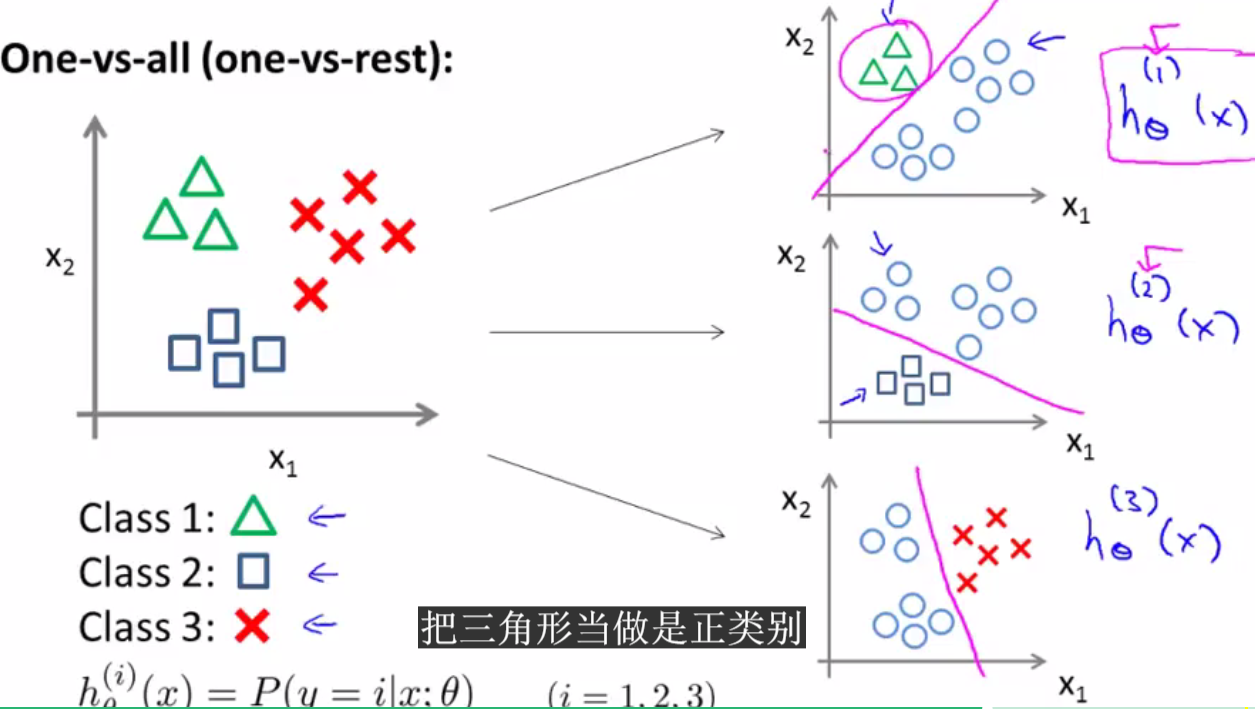

多类别分类问题:

one-vs-all(一对多)分类算法

有n个类别就设置n个分类器

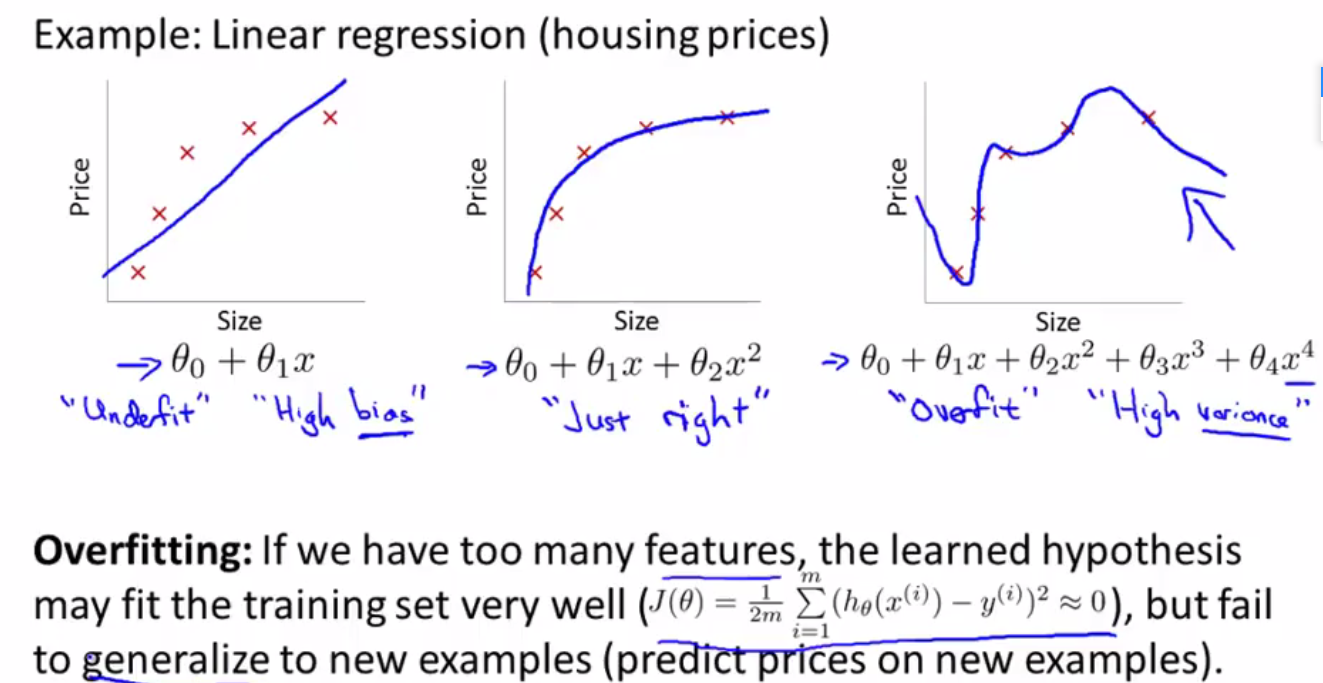

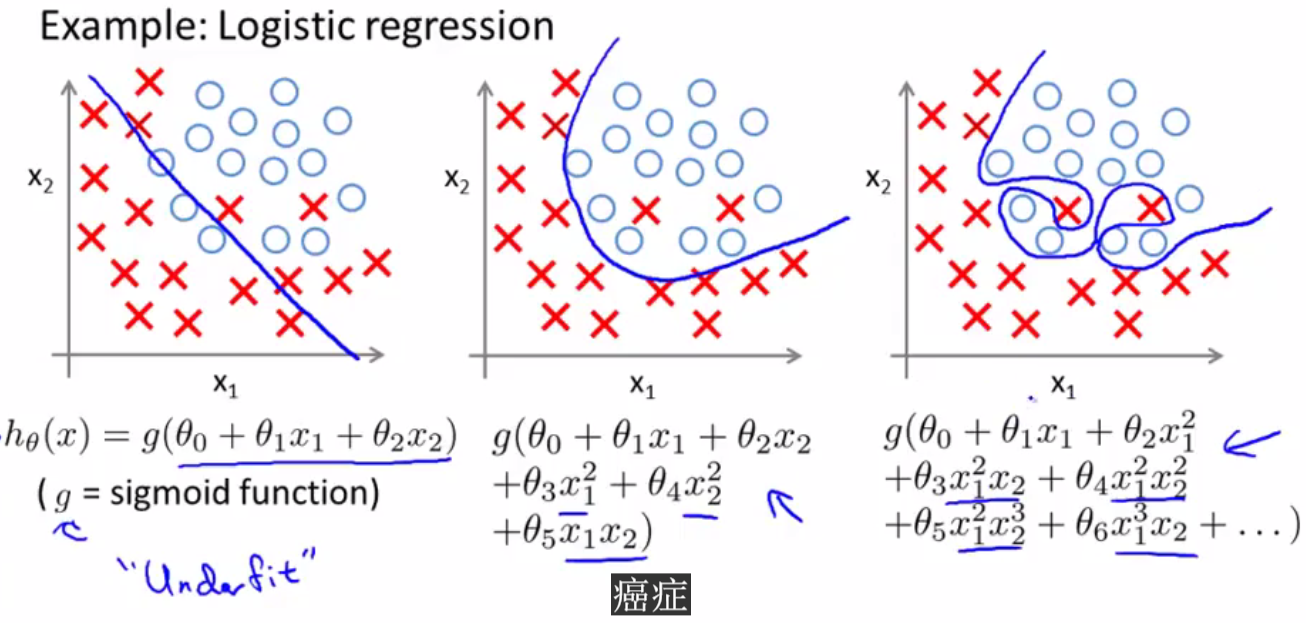

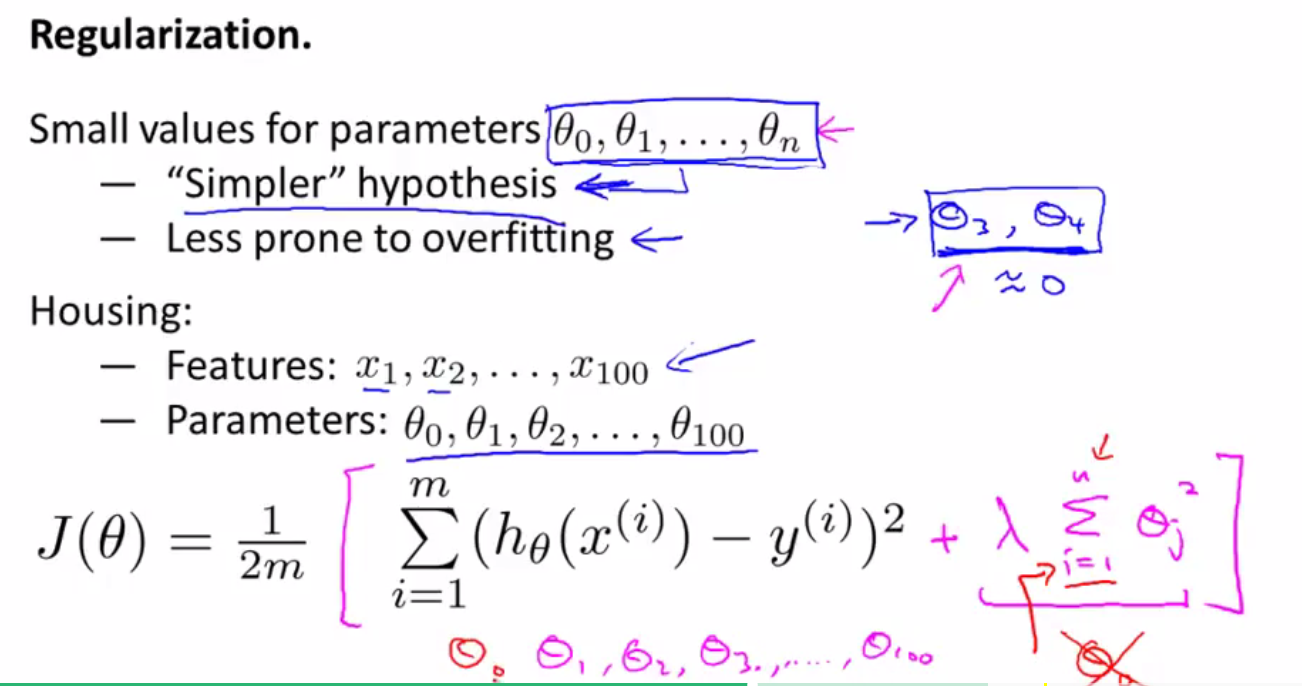

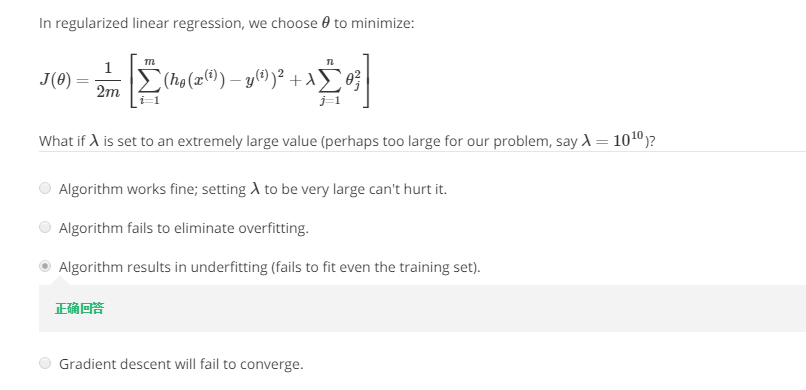

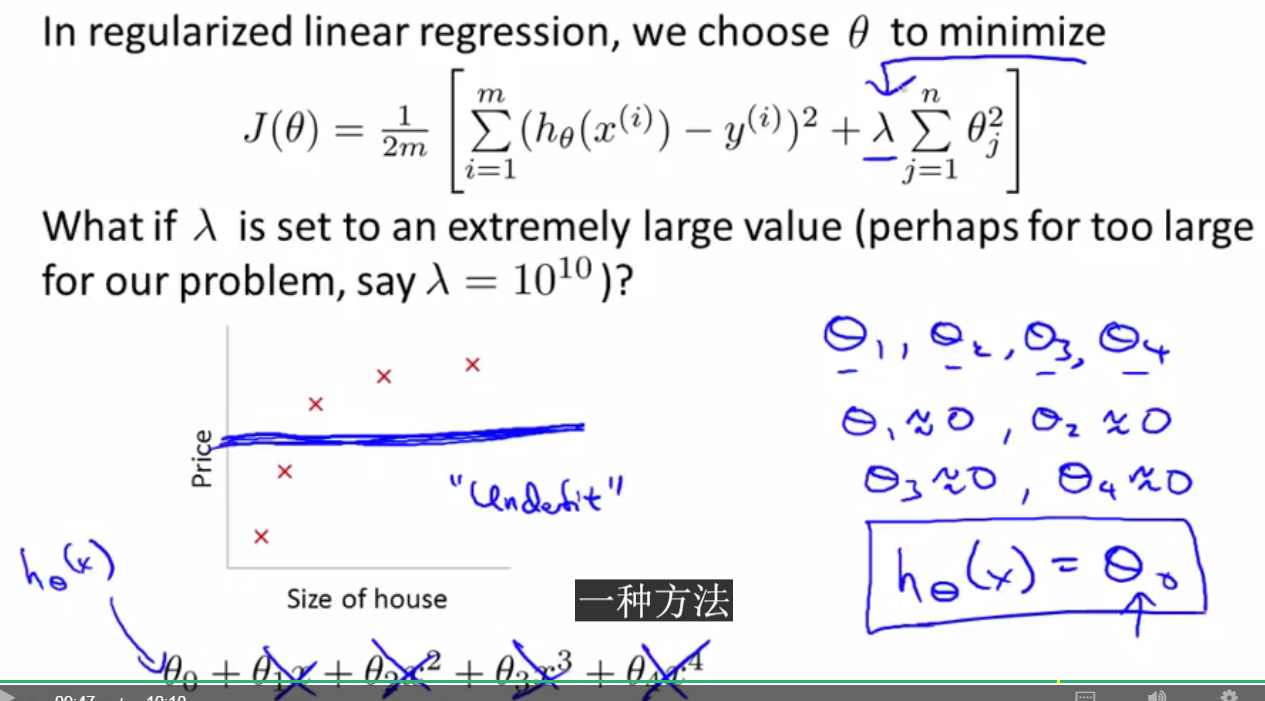

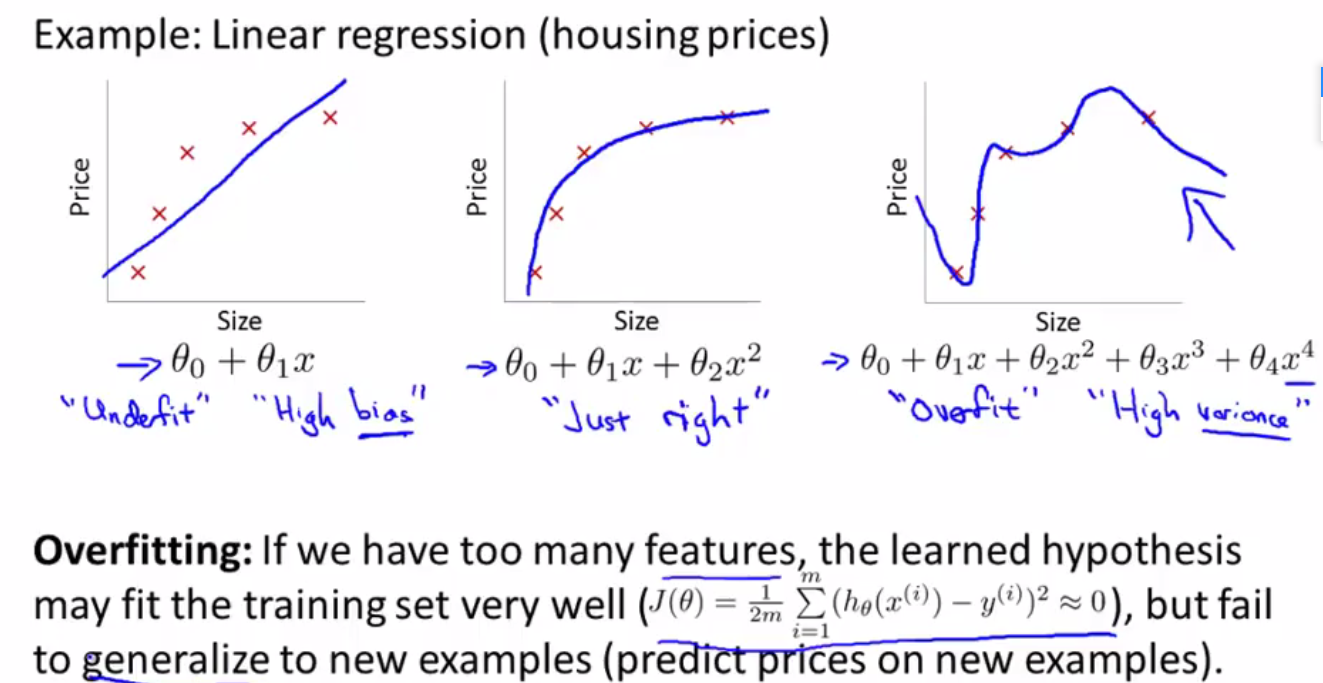

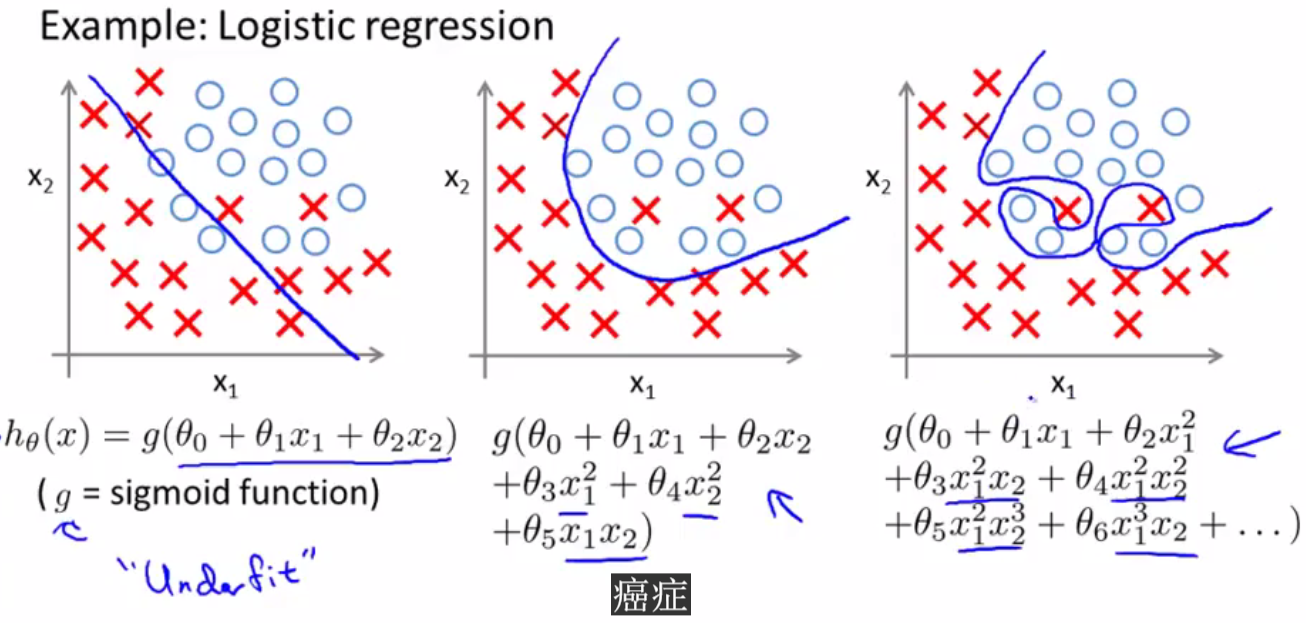

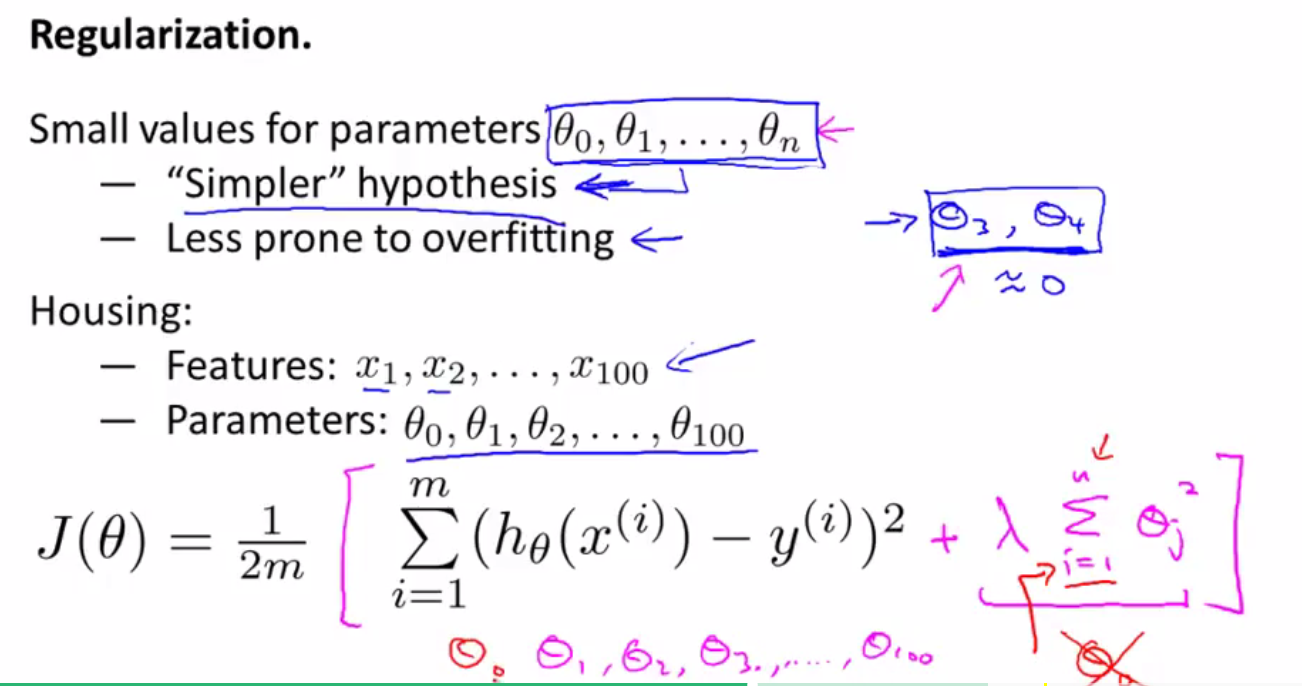

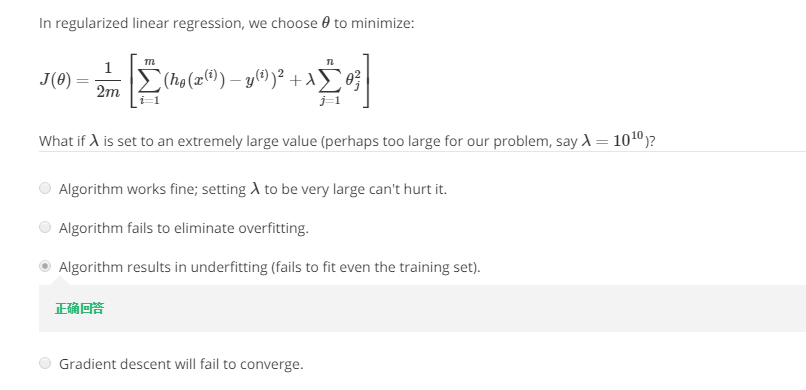

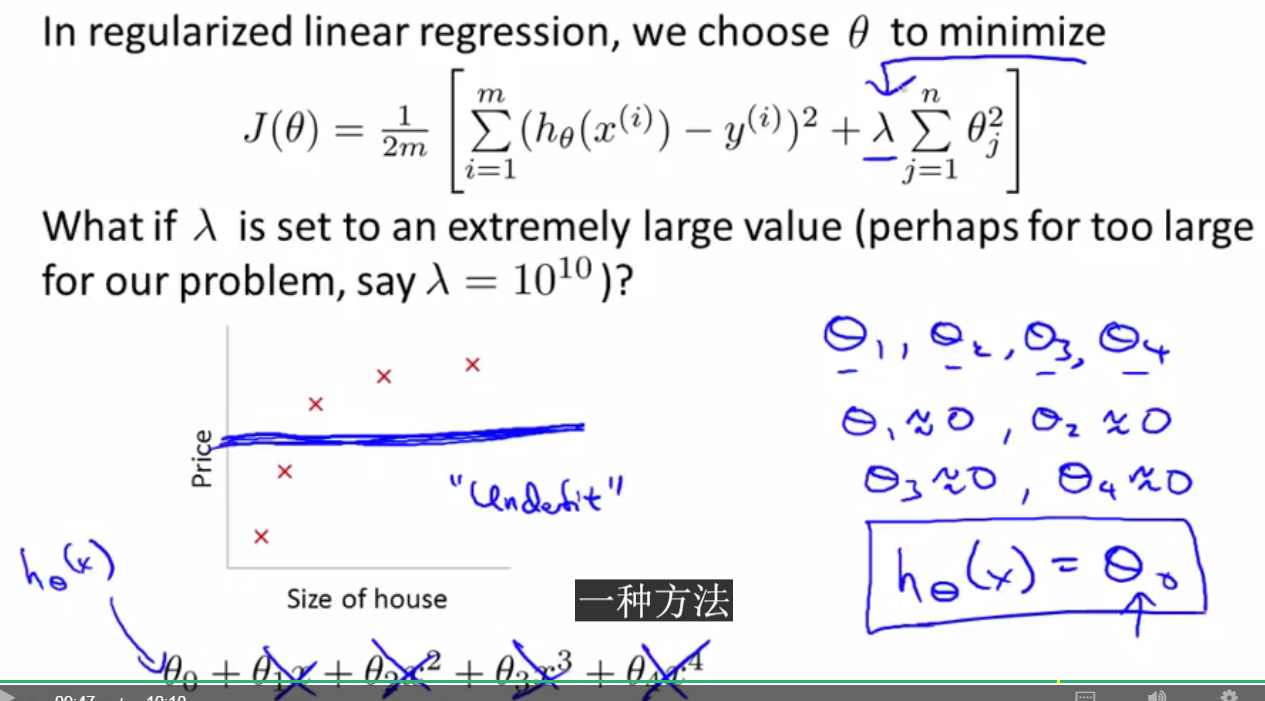

过度拟合问题(The problem of overfitting)与正则化(regularization)

过度拟合问题通常出现在样本数量少,但是特征值多的情况下

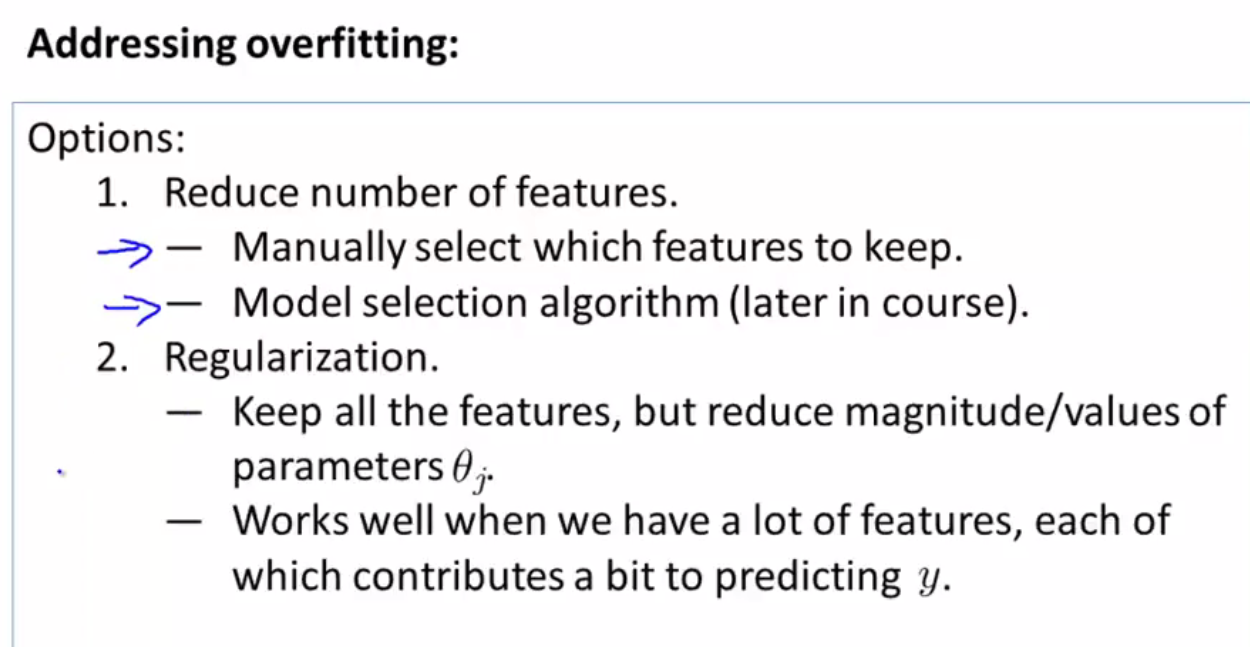

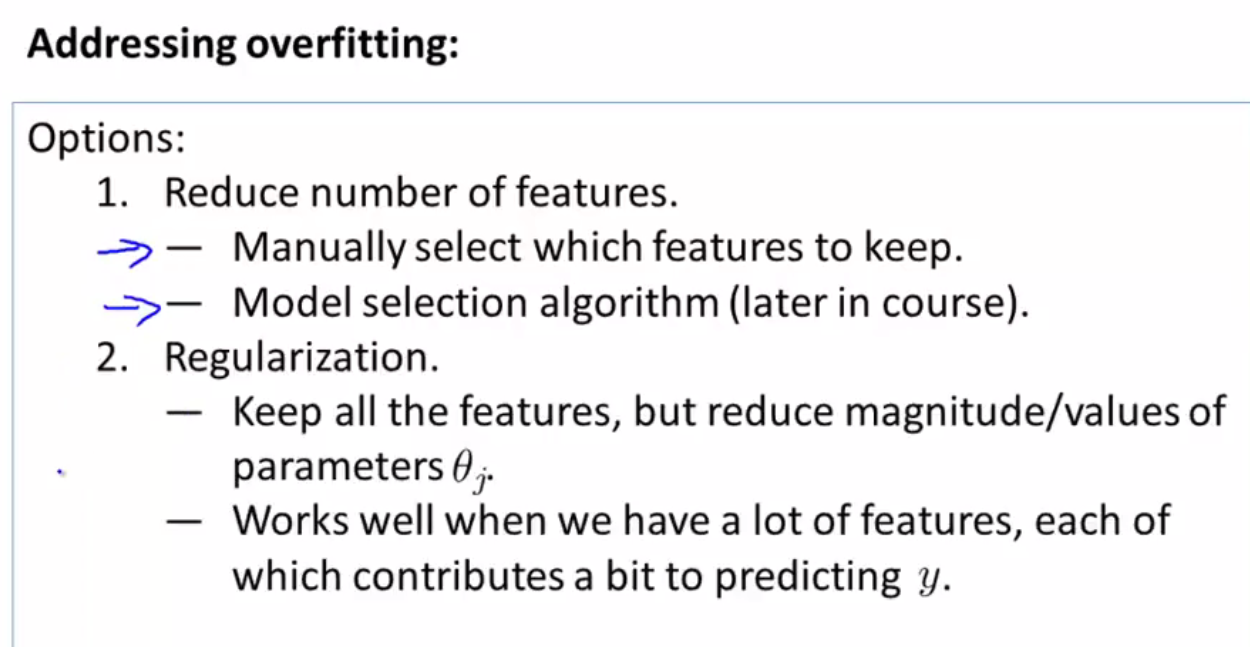

解决过度拟合的方法:

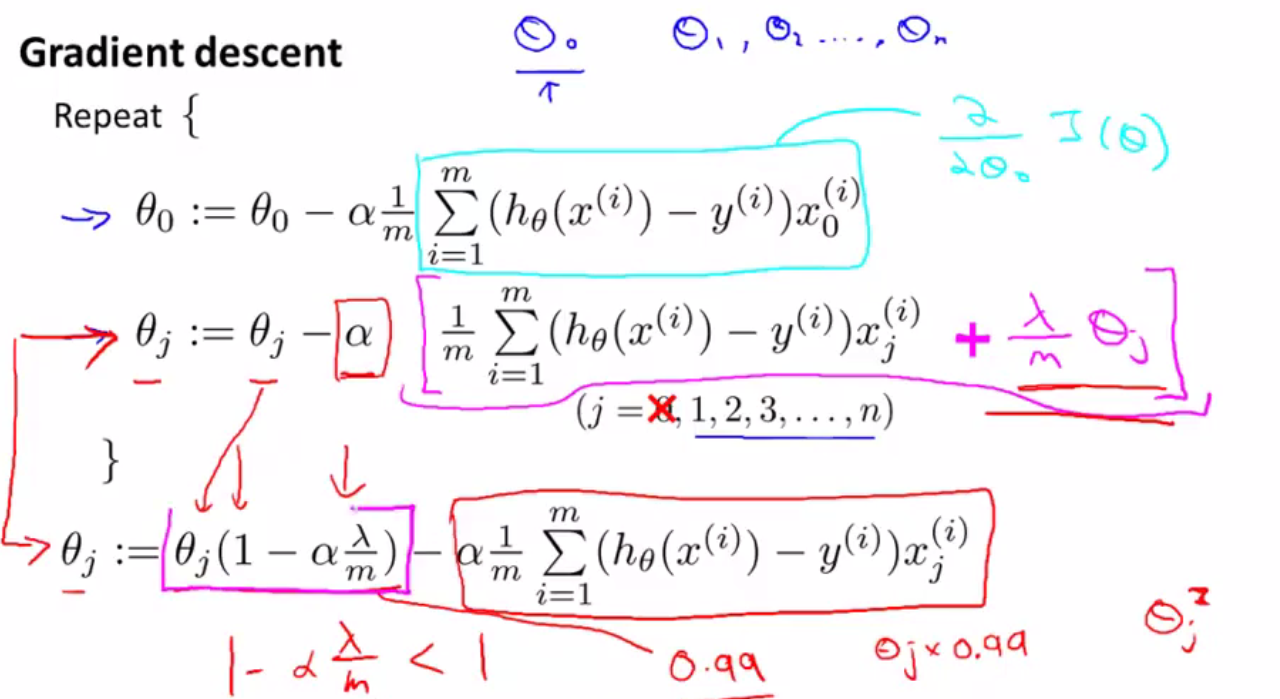

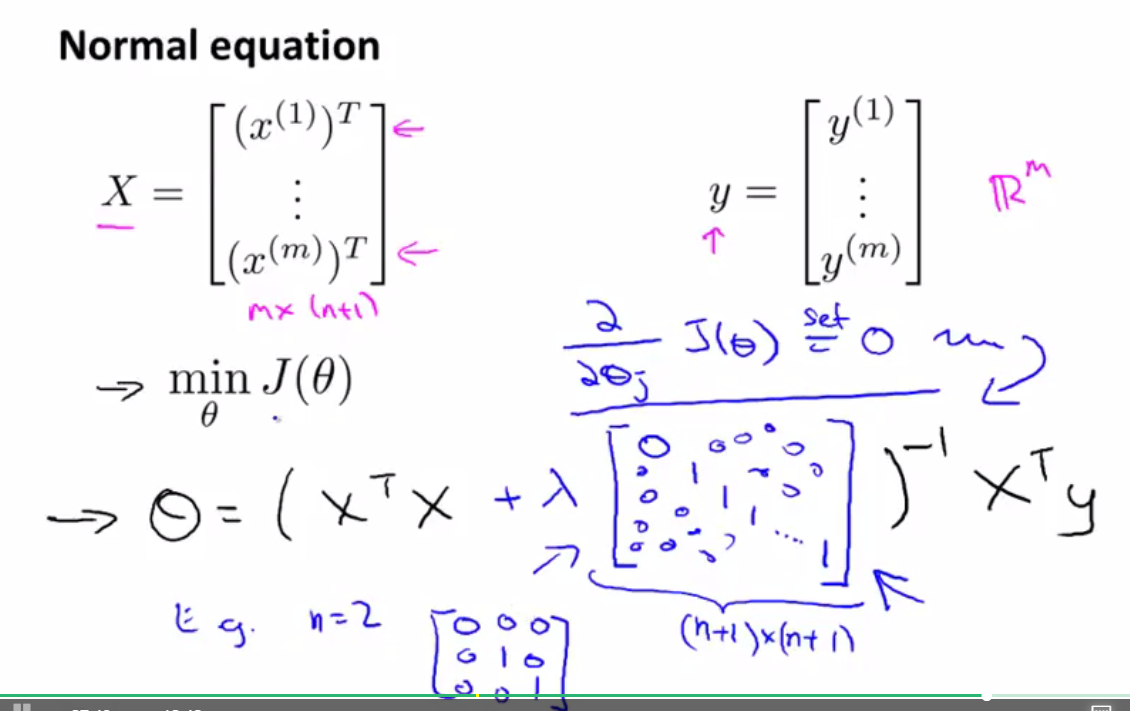

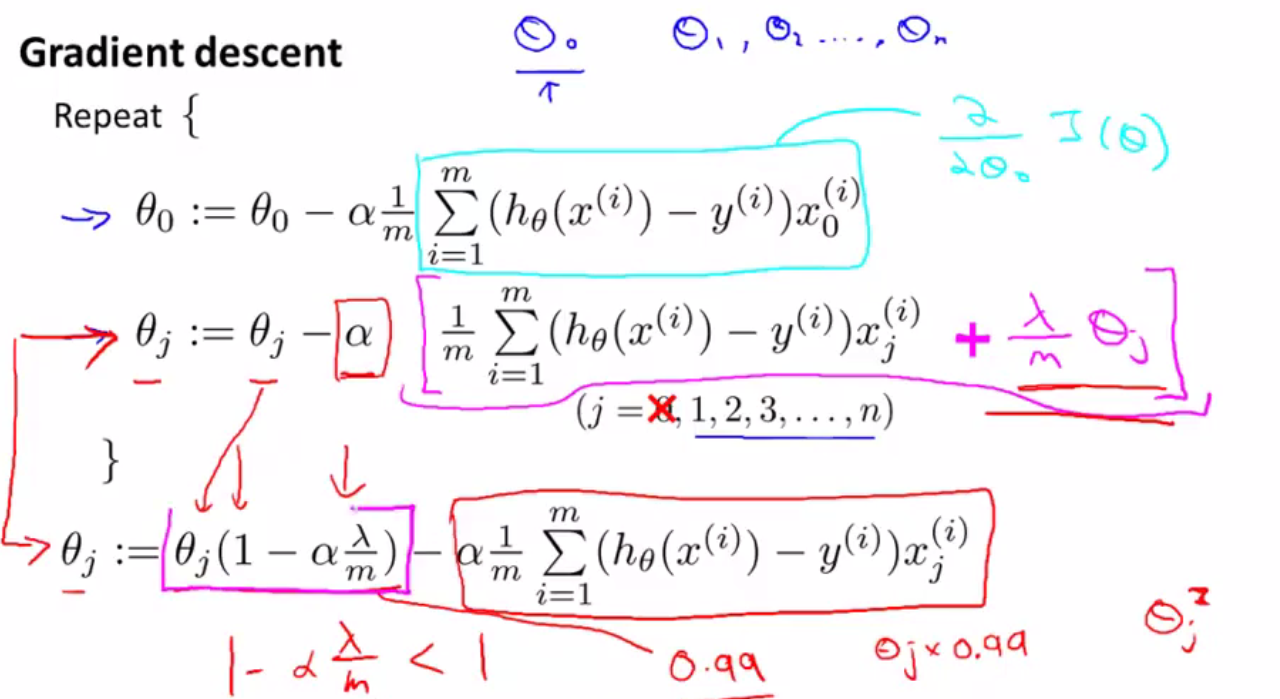

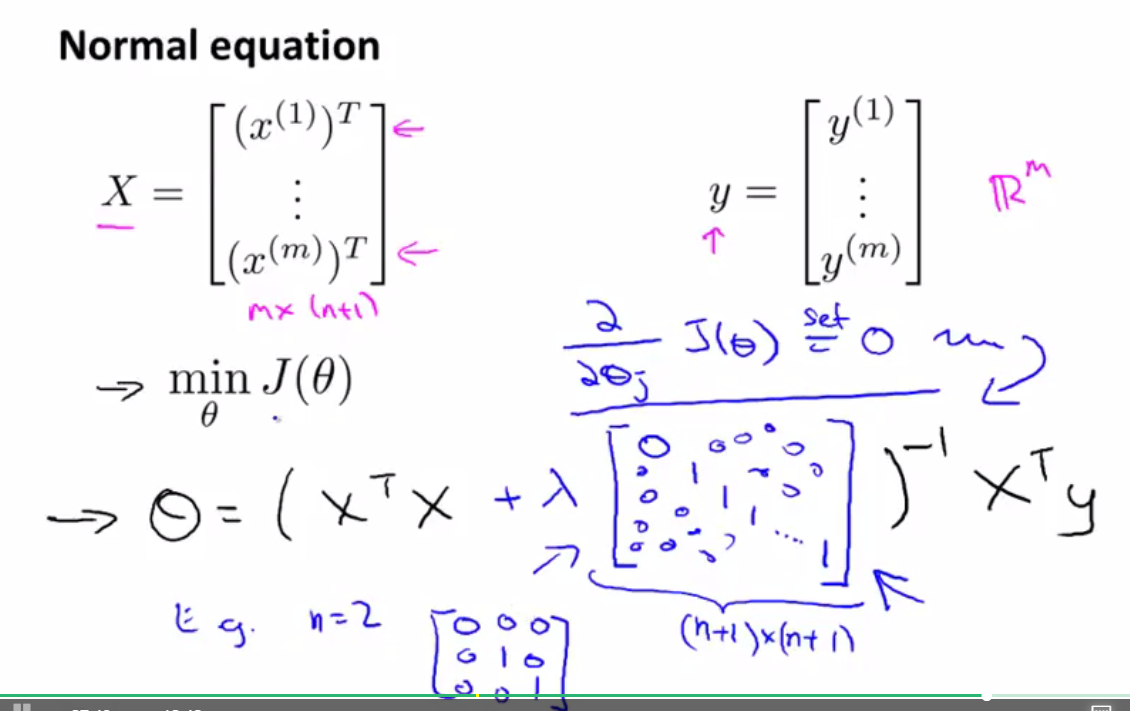

正则化线性回归(Regularization linear regression)

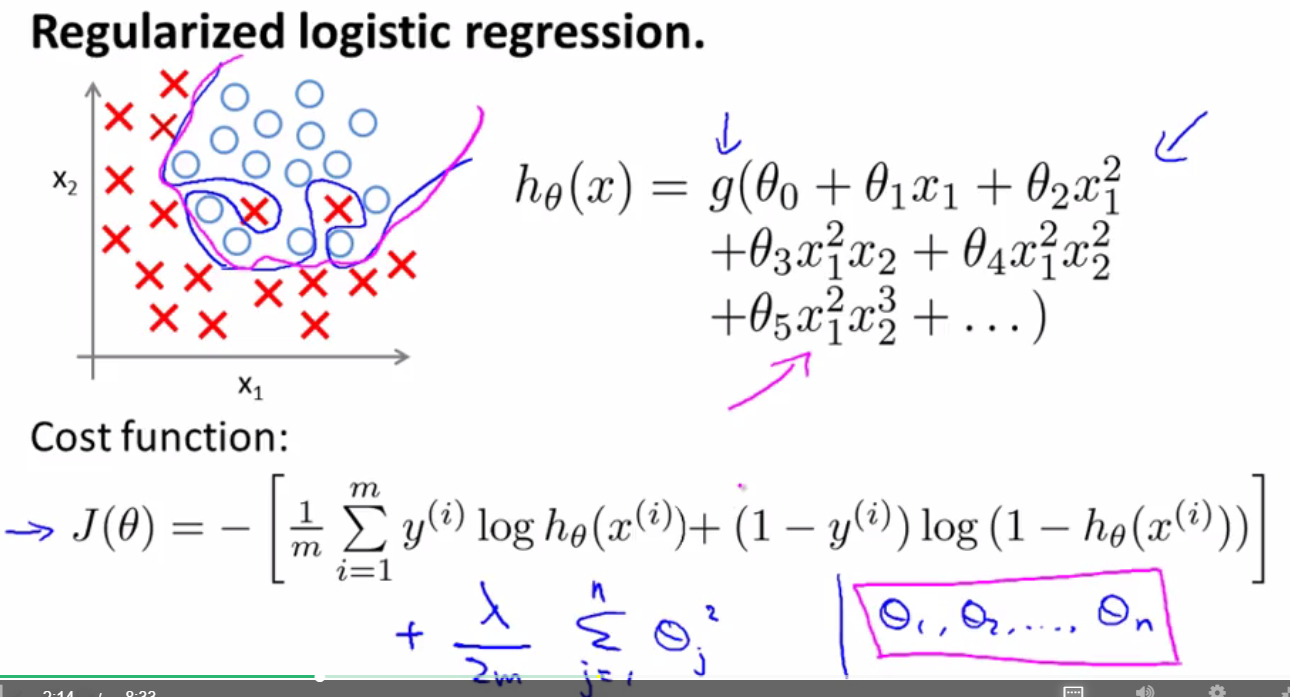

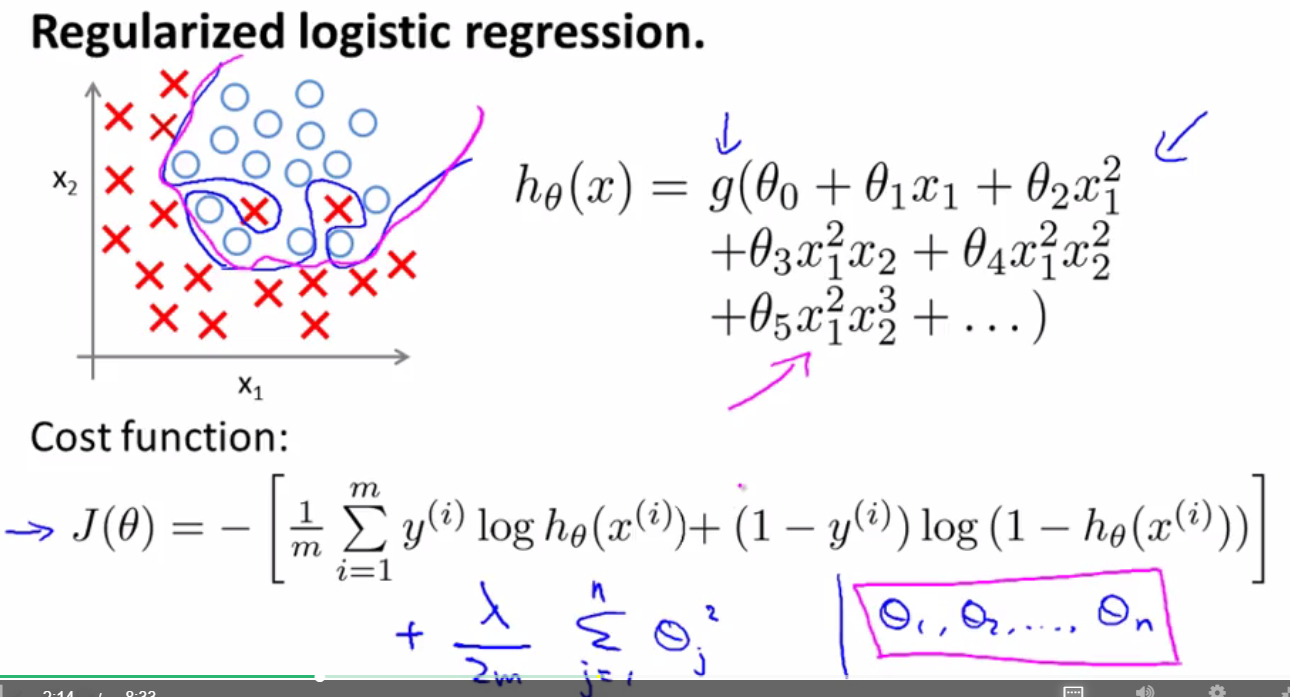

正则化逻辑回归(Regularization logistic regression)

逻辑回归是用来解决分类问题的一种分类算法,适用于标签y取值离散的情况

Classification(分类问题):二元分类问题、多元分类问题

线性回归不适合用来解决分类问题:

1、在分类问题中y值取0或者1,但是线性回归的预测值可以存在>1或者<0,二者相矛盾

2、线性回归对点的拟合度不是很好

3、如果出现离群点(最右边的红色X),那么很容易将线性回归的图像的拟合度大幅降低

逻辑回归中假设函数的表示(Hypothesis Representation):

S型函数(Sigmoid function)、逻辑函数(Logistic Function)是指代同一个东西

对逻辑函数的输出值的解释:

输出值如果为0.7的话,表明在给定参数theta、特征值x1(肿瘤的大小)的情况下,病人肿瘤为恶性的概率为0.7。

决策边界(Decision boundary)

由逻辑函数的图像可以看出:

当z>=0时,g(z)>=0.5≈1

当z<0时,g(z)<0.5≈0

所以,可以令z=0,来求得一根线,那根线就是决策边界

如何寻找合适的theta值来拟合数据集:

数据集有m组数据,有n个特征(feature),y取值为0或1,假设函数h(x)

按照线性回归的步骤求得逻辑回归的代价函数(Cost Function) J(theta),通过函数图像发现它是一个非凸函数(non-convex function),存在很多局部最小值。所以对于逻辑回归,我们使用另外的代价函数。

逻辑回归的代价函数如下所示:

当y=1时,如果h(theta)=1,就是说我们的假设函数计算出来的数值(肿瘤为恶性的概率)与实际的数值完全一样,那么J(theta)=0,对应右下角的蓝色点。如果当y=1时,h(theta)=0,就是说预测的数值与实际情况完全相矛盾,完全不符合,那么从图像上可以看到J(theta)=无穷大,意味着我们需要付出很大的代价。

使用梯度下降法来拟合逻辑回归的参数

高级优化算法

只需要学会使用即可,不需要理解,具体操作在第三周第二节课

多类别分类问题:

one-vs-all(一对多)分类算法

有n个类别就设置n个分类器

过度拟合问题(The problem of overfitting)与正则化(regularization)

过度拟合问题通常出现在样本数量少,但是特征值多的情况下

解决过度拟合的方法:

正则化线性回归(Regularization linear regression)

正则化逻辑回归(Regularization logistic regression)

相关文章推荐

- 使用spark和spark mllib进行股票预测

- 书评:《算法之美( Algorithms to Live By )》

- 动易2006序列号破解算法公布

- C#递归算法之分而治之策略

- Ruby实现的矩阵连乘算法

- C#插入法排序算法实例分析

- C#算法之大牛生小牛的问题高效解决方法

- C#算法函数:获取一个字符串中的最大长度的数字

- 超大数据量存储常用数据库分表分库算法总结

- C#数据结构与算法揭秘二

- C#冒泡法排序算法实例分析

- 算法练习之从String.indexOf的模拟实现开始

- C#算法之关于大牛生小牛的问题

- C#实现的算24点游戏算法实例分析

- 经典排序算法之冒泡排序(Bubble sort)代码

- c语言实现的带通配符匹配算法

- 浅析STL中的常用算法

- 算法之排列算法与组合算法详解

- C++实现一维向量旋转算法

- Ruby实现的合并排序算法