Andrew NG 《machine learning》week 3,class5 —Solving the Problem of Overfitting

2016-06-18 22:47

239 查看

Andrew NG 《machine learning》week 3,class5 —Solving the Problem of Overfitting

5.1 The problem of overfitting

本节主要讨论什么是过度拟合?以及how to solve it and make the algorithm work well。5.1.1 过拟合与欠拟合的概念

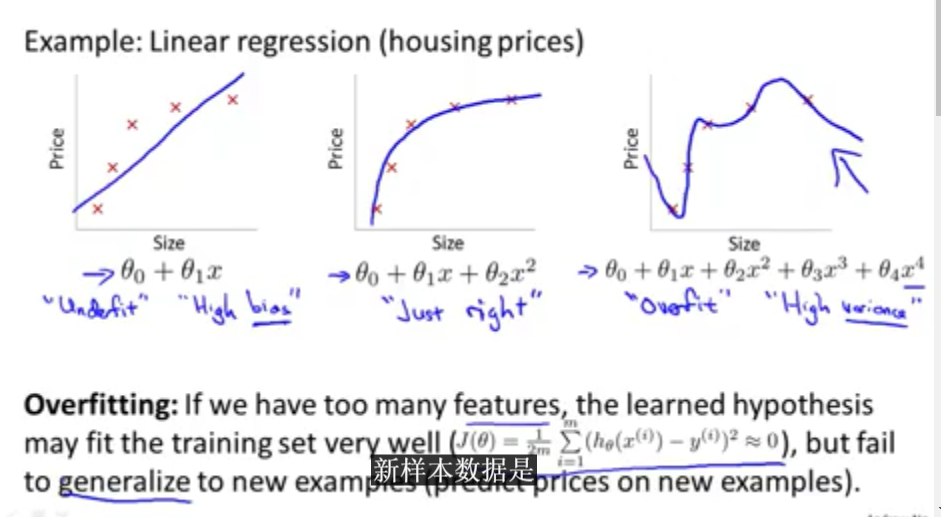

下图展示了什么 是线性回归的欠拟合,什么是过拟合。

上图中的左图表示的是欠拟合的情况,也叫High bias,中间图是正常情况,右图是过拟合情况,也叫high variance。

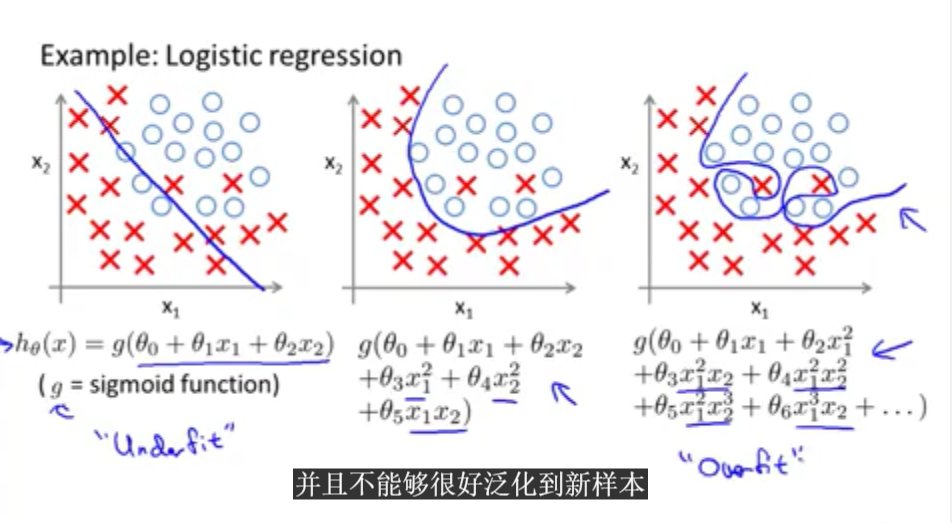

接着举例说明逻辑回归的欠拟合,过拟合情况。如下图:

上图中的左图表示的是欠拟合的情况,也叫High bias,中间图是正常情况,右图是过拟合情况,也叫high variance。

虽然过拟合的cost function一般会等于0,但是并不代表它是最好的,因为对于训练集这个算法达到了可以说是完美的拟合状态,但是这个算法模型却不能很好的进行泛化,即对于需要预测的新数据集,就会表现出较差的预测结果。之后的课程将会讲解到怎么应用工具找到过拟合或者欠拟合的状态。

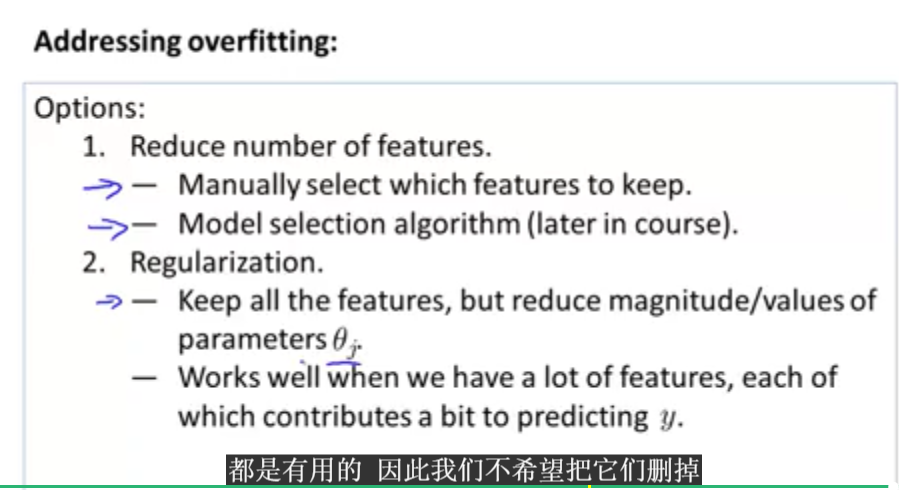

5.1.2 过拟合的解决办法(addressing overfitting)

有过多的特征变量以及较少的训练集,就会导致过拟合的情况发生。解决办法如下图:

上图所提到的两种解决办法中,第二解决办法更为合理。

5.2 Cost Function

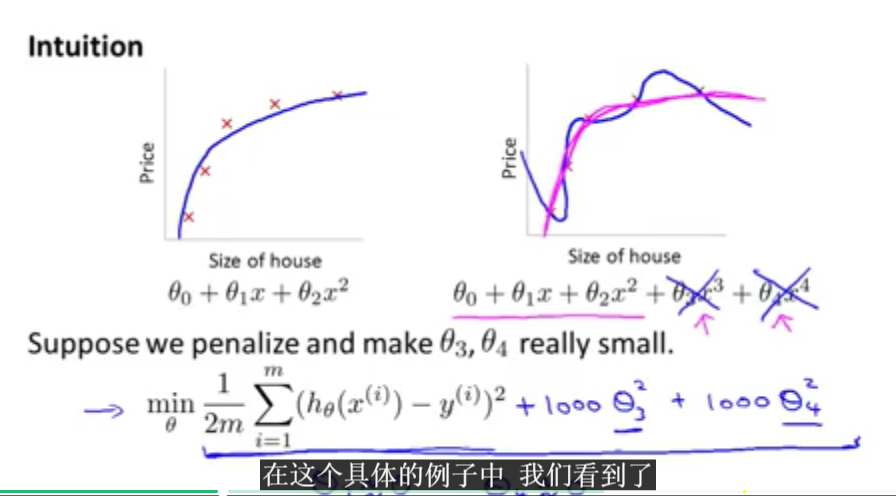

本节主要讲解的内容是上一节提到的解决过拟合办法中的第二项:正则化。之后会讲解运用正则化时需要使用的代价函数。

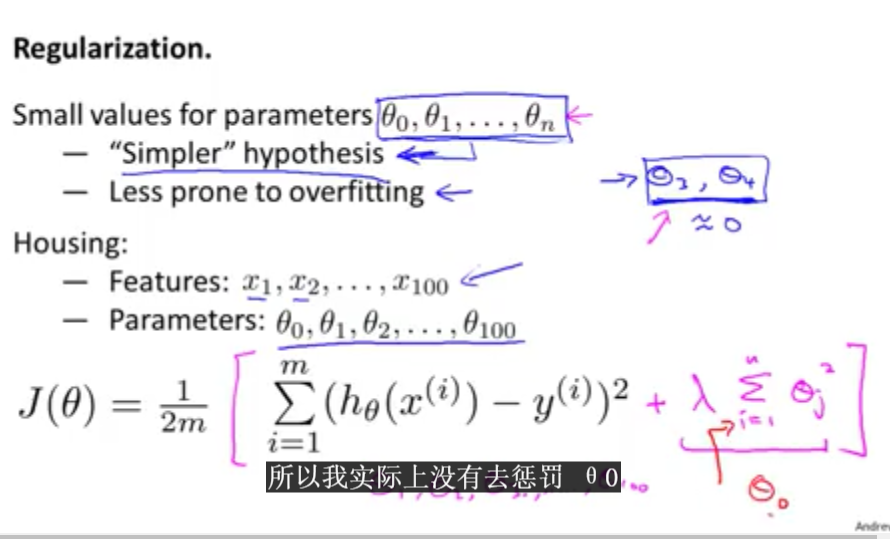

对于过拟合的函数模型,可以做如上图所示的处理,把threa3,threa4尽量减少对模型的影响。但是对于选择哪些参数使其减小,这是另一个问题。因此需要修改代价函数。改为如下图所示情况:

上图所示的代价函数时尽量减少每一个参数。但是i是从1开始的,一般很少会减少threa0的值。上面所示的就是正则化。正则化参数选择过大会导致欠拟合的情况出现,所以正则化参数的选择需要谨慎。

接下来的课程中将会将解决过拟合的方法运用到逻辑回归和线性回归之中。

5.3 Regularized linear regression

本节主要将正则化的代价函数应用于线性和逻辑回归函数。5.3.1 正则化的线性回归的梯度下降函数

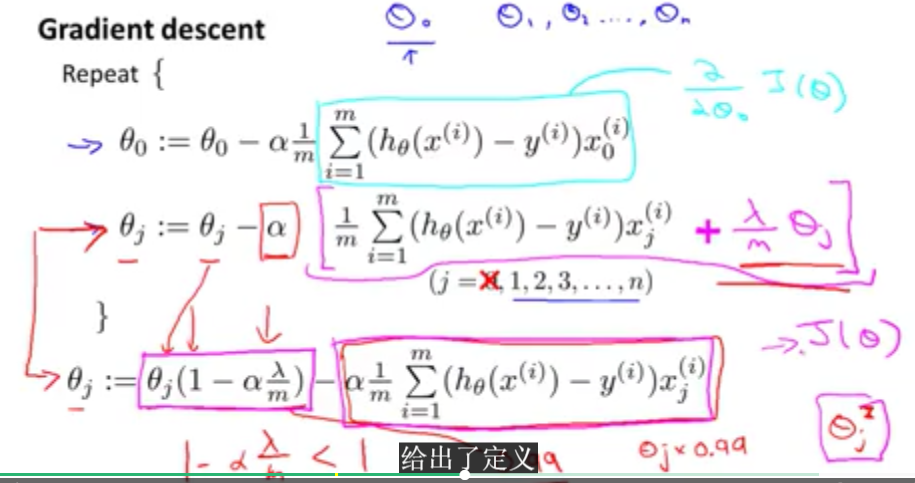

首先先介绍一下正则化之后的线性回归函数的梯度下降函数。

由上图可知,正则化之后的梯度下降函数缩小了threa的值。

5.3.2 正则化之后的线程回归的正规方程

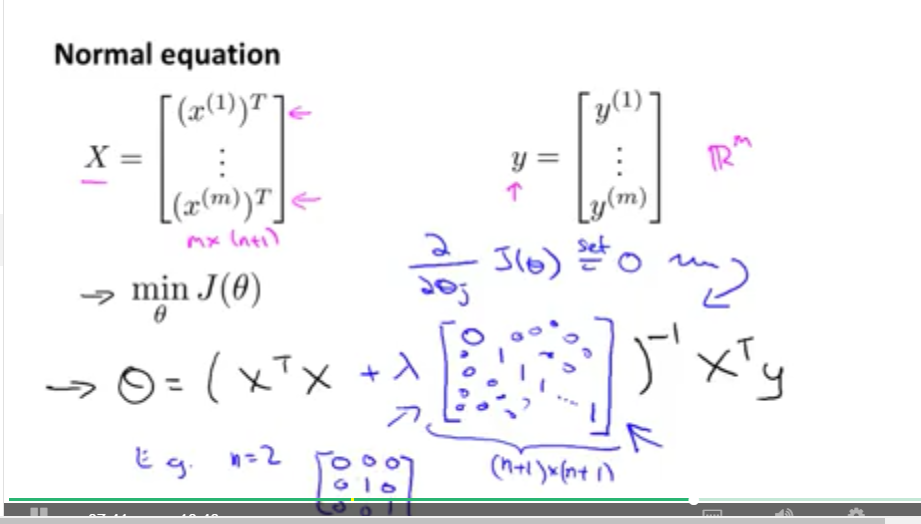

正则化之后的正规方程如下图:

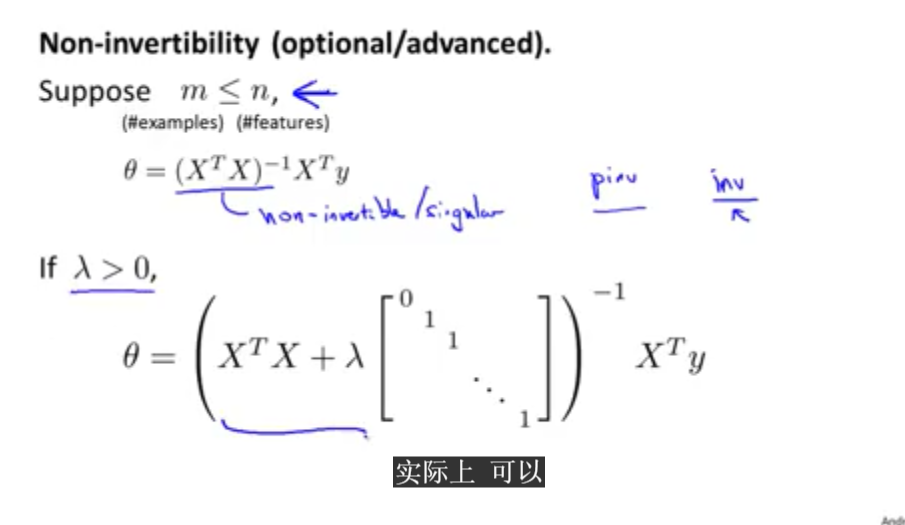

当然可能出现矩阵不可逆的情况,但是正则化的正规方程可以解决这个问题。

这种情况下,因为加了正则化的矩阵,因此不会出现不可逆的情况。

5.4 Regularized logistic regression

本小节主要讲述正则化的逻辑回归模型。5.4.1 正则化的逻辑回归函数的梯度下降函数

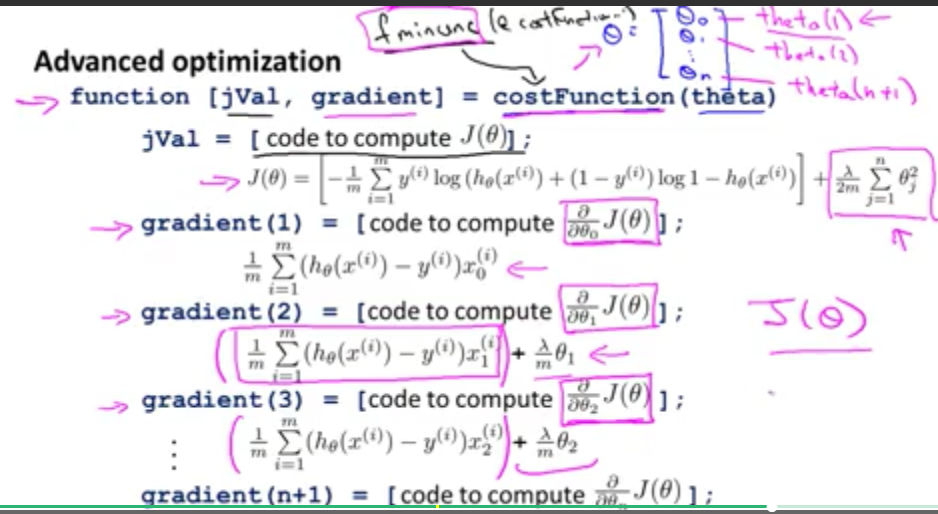

这部分所讲的内容与5.3节基本相同,只不过这里的h(x)是逻辑回归的模型。5.4.2 正则化的逻辑回归函数的优化函数

具体如下图:

只需要将其应用到fminunc中,和之前讨论到的优化函数时一样的。

相关文章推荐

- 用Python从零实现贝叶斯分类器的机器学习的教程

- My Machine Learning

- 机器学习---学习首页 3ff0

- Spark机器学习(一) -- Machine Learning Library (MLlib)

- 反向传播(Backpropagation)算法的数学原理

- 关于SVM的那点破事

- 也谈 机器学习到底有没有用 ?

- TensorFlow人工智能引擎入门教程之九 RNN/LSTM循环神经网络长短期记忆网络使用

- TensorFlow人工智能引擎入门教程之十 最强网络 RSNN深度残差网络 平均准确率96-99%

- TensorFlow人工智能引擎入门教程所有目录

- 如何用70行代码实现深度神经网络算法

- 量子计算机编程原理简介 和 机器学习

- 近200篇机器学习&深度学习资料分享(含各种文档,视频,源码等)

- 已经证实提高机器学习模型准确率的八大方法

- 初识机器学习算法有哪些?

- 机器学习相关的库和工具

- 10个关于人工智能和机器学习的有趣开源项目

- 机器学习实践中应避免的7种常见错误

- 机器学习常见的算法面试题总结

- 不平衡数据处理技术——RUSBoost