ML基石_LinearModelsForClassfication

2015-10-13 22:13

316 查看

retro

start

linear models for 01 classification

回顾线性模型

误差函数分析

解决步骤

stochastic gradient descent

概述

PLA比较与建议

multiclass via Logistic Regression

图形

OVA

multiclass via Binary Classfication

总结

linear classfication

linear regression

logistic regression

然后,根据

接下来,对梯度下降法进行了改进,梯度下降法每一次迭代权值需要遍历所有数据,改进的随机梯度下降法保证了平均的方向是梯度下降的方向,每次更新权值只需要其中某一个数据。

这个也可以和PLA比较,PLA每次更新权值也只需要一个数据。

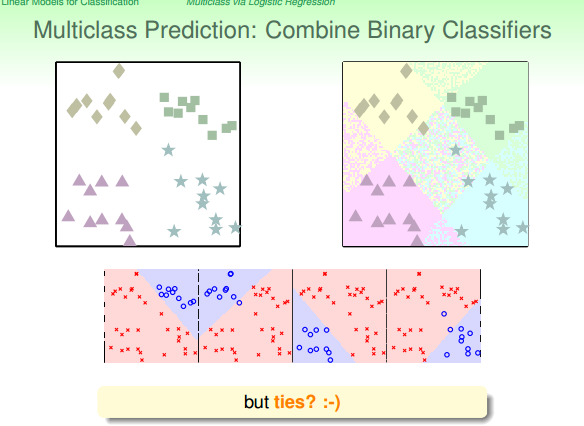

讨论了线性模型用于二分类问题后,讨论了其能否用于多分类问题。

多分类问题主要有两种担忧:

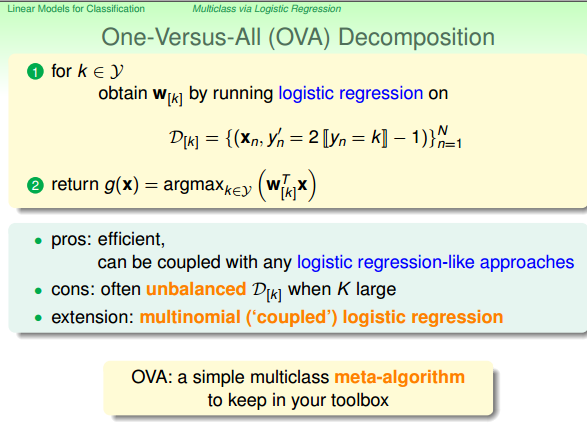

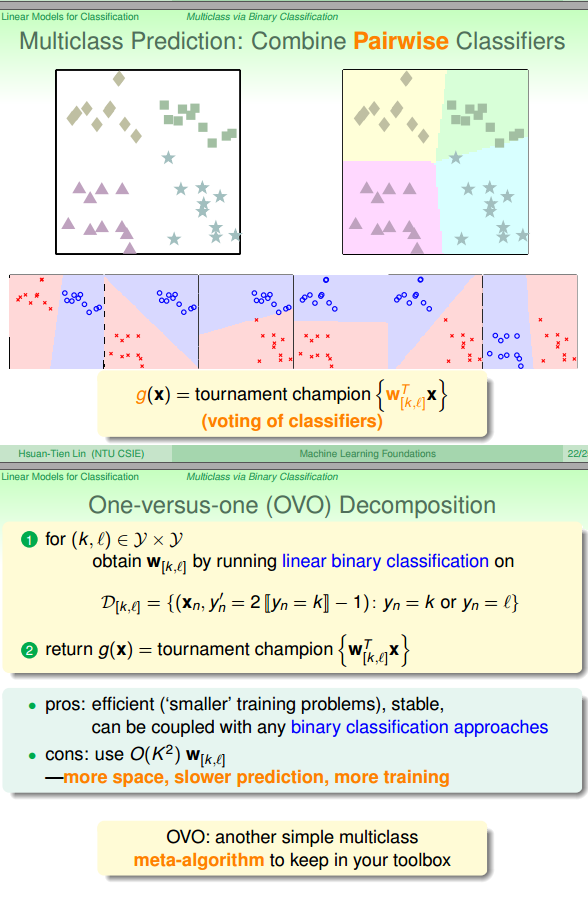

数据偏斜(OVA中表现明显,可以采用OVO)

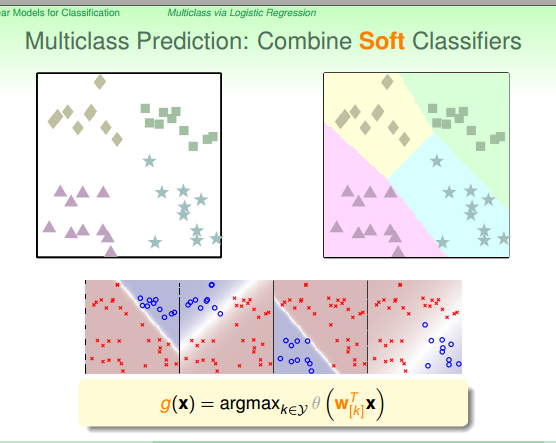

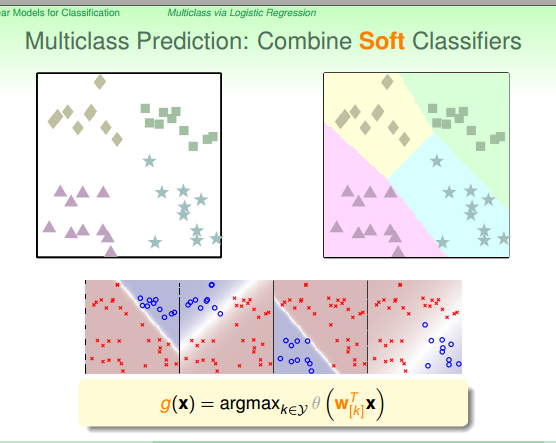

数据重叠(单个数据被几个模型都标示或者都不标示,可以采取logistic等的概率模型)

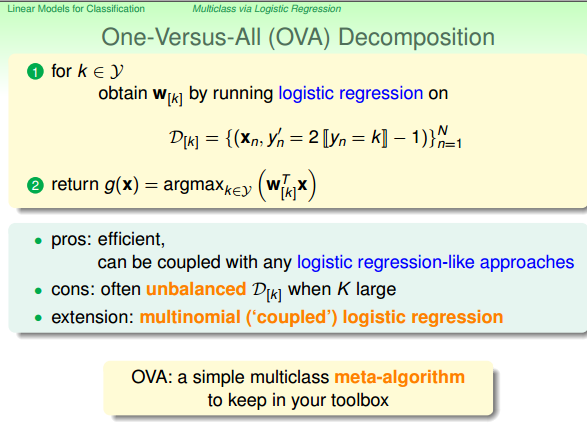

方法主要有两种

OVO

OVA

根据

实际工程中,对于二分类问题,一般采用:

用

使用

start

linear models for 01 classification

回顾线性模型

误差函数分析

解决步骤

stochastic gradient descent

概述

PLA比较与建议

multiclass via Logistic Regression

图形

OVA

multiclass via Binary Classfication

总结

retro

start

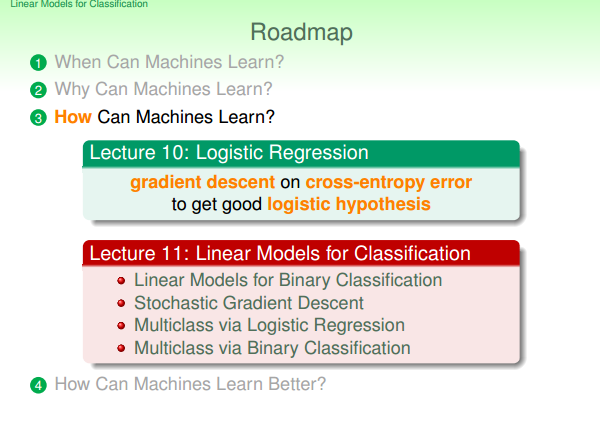

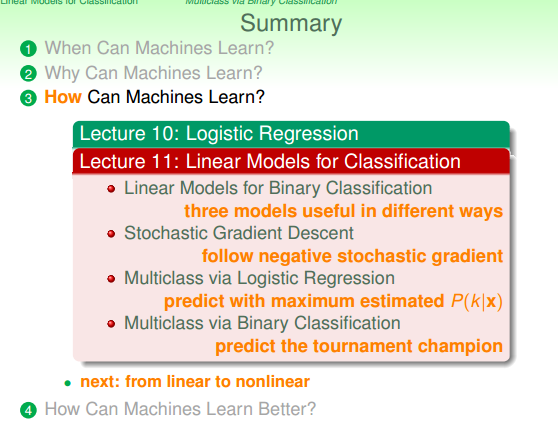

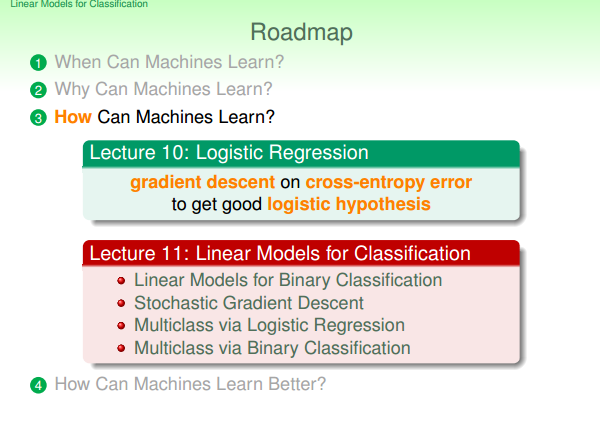

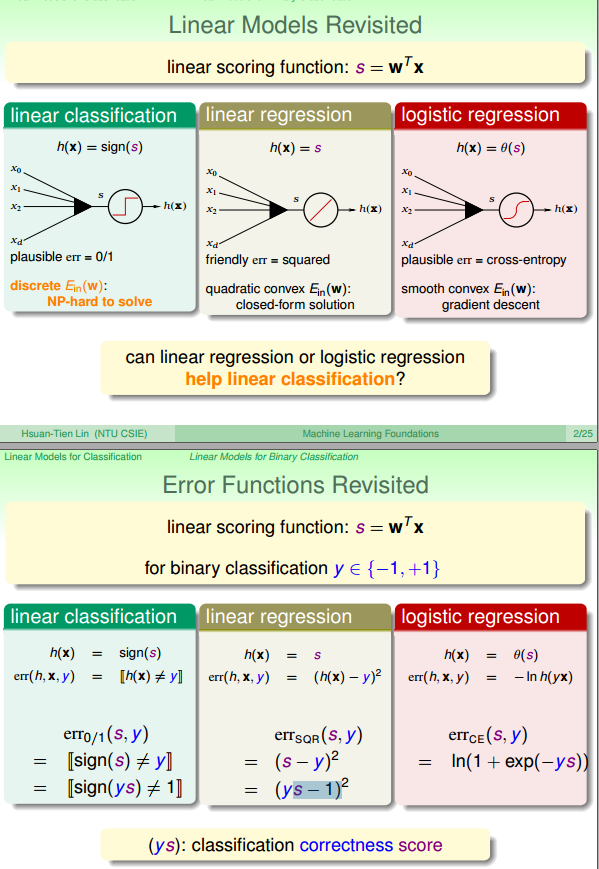

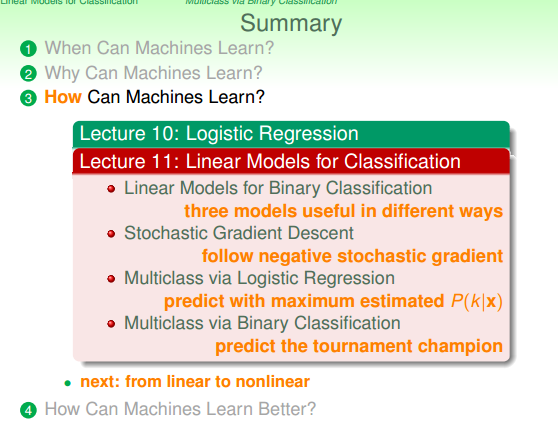

首先,回顾了学习过的几种线性模型,比较了它们的error measure等。

linear classfication

linear regression

logistic regression

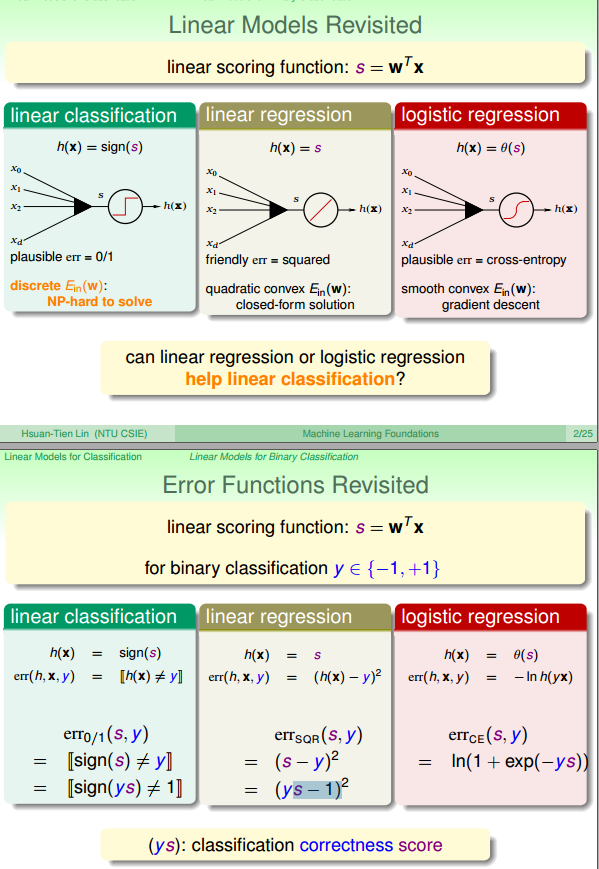

然后,根据

error measure的联系,可以将

linear regression和

logistic regression也应用到

linear classfication的问题中,也就是01分类问题中。

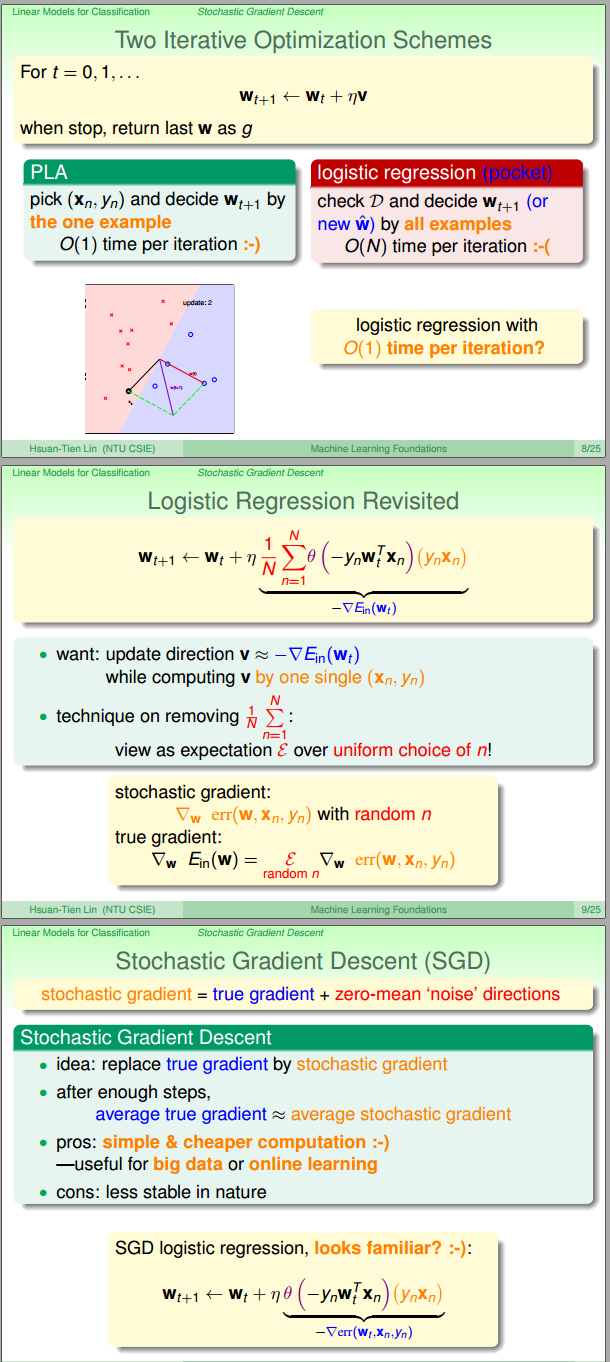

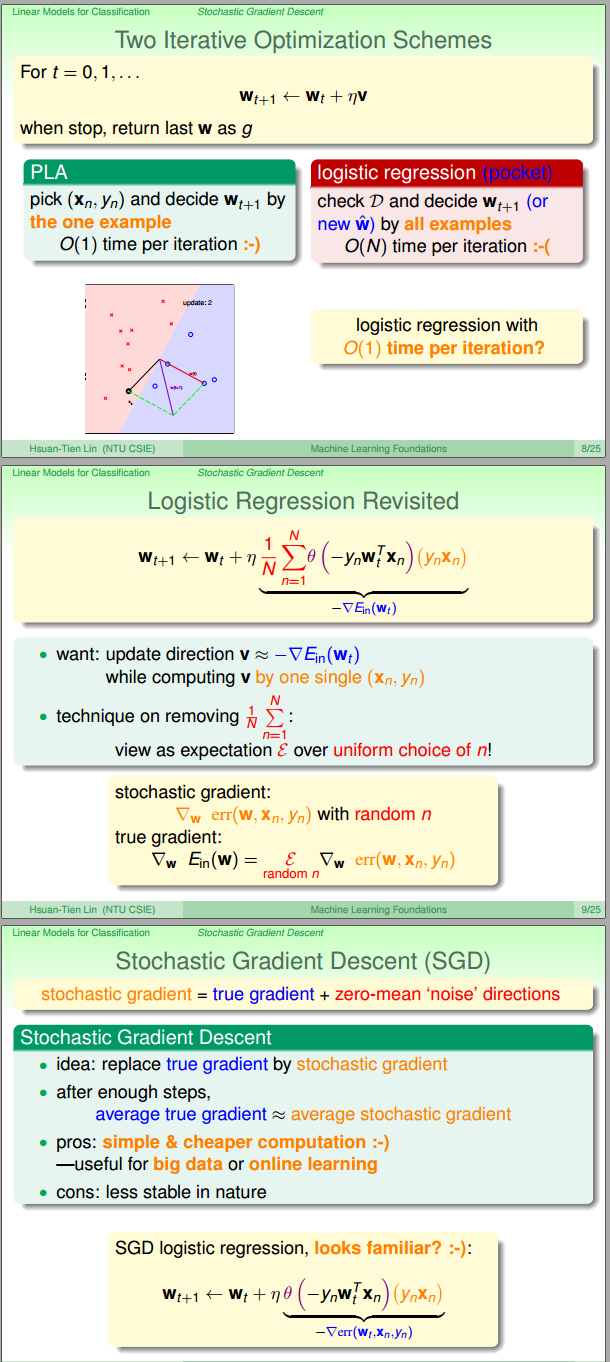

接下来,对梯度下降法进行了改进,梯度下降法每一次迭代权值需要遍历所有数据,改进的随机梯度下降法保证了平均的方向是梯度下降的方向,每次更新权值只需要其中某一个数据。

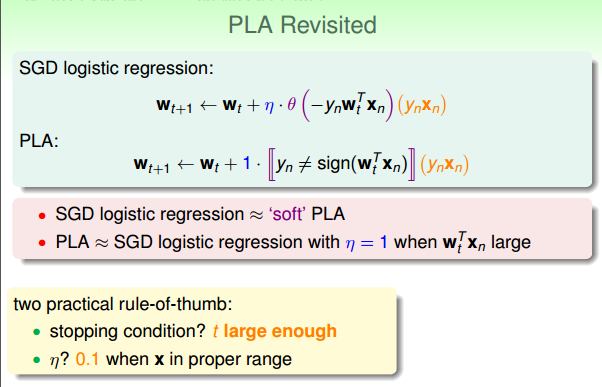

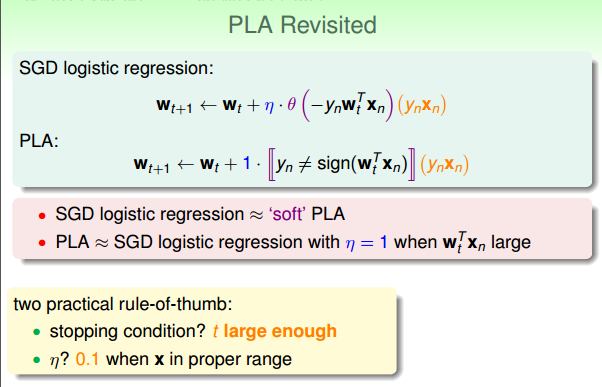

这个也可以和PLA比较,PLA每次更新权值也只需要一个数据。

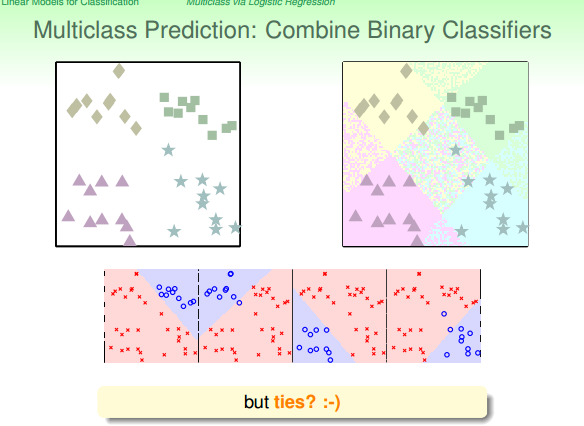

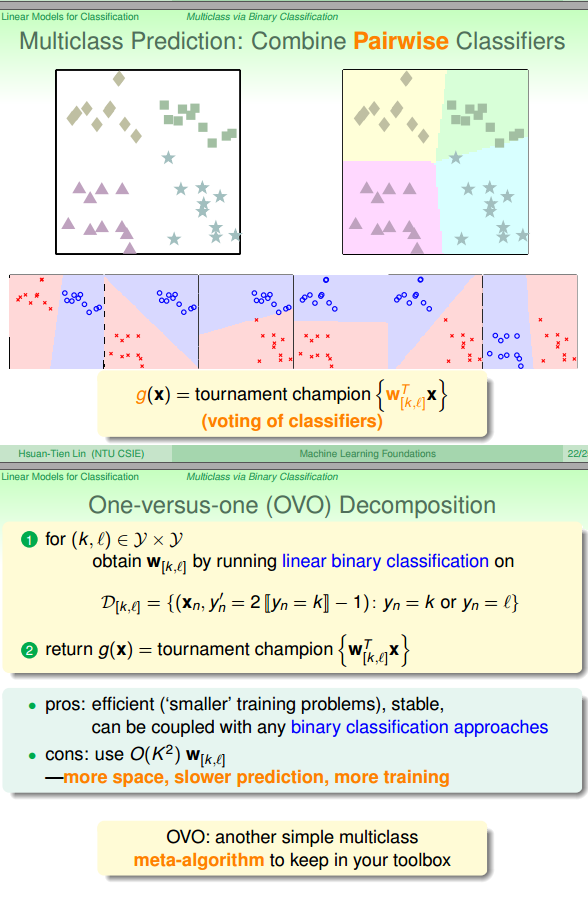

讨论了线性模型用于二分类问题后,讨论了其能否用于多分类问题。

多分类问题主要有两种担忧:

数据偏斜(OVA中表现明显,可以采用OVO)

数据重叠(单个数据被几个模型都标示或者都不标示,可以采取logistic等的概率模型)

方法主要有两种

OVO

OVA

linear models for 01 classification

回顾线性模型

误差函数分析

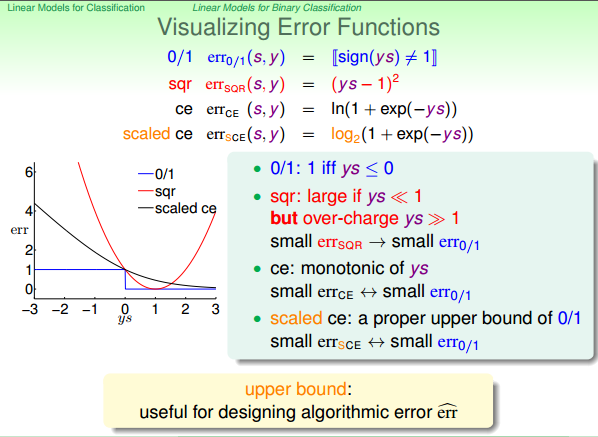

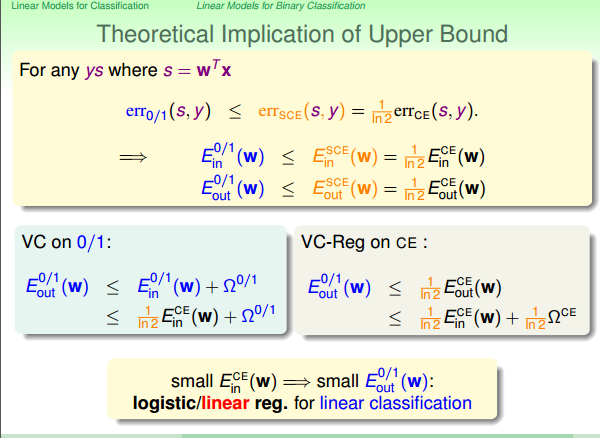

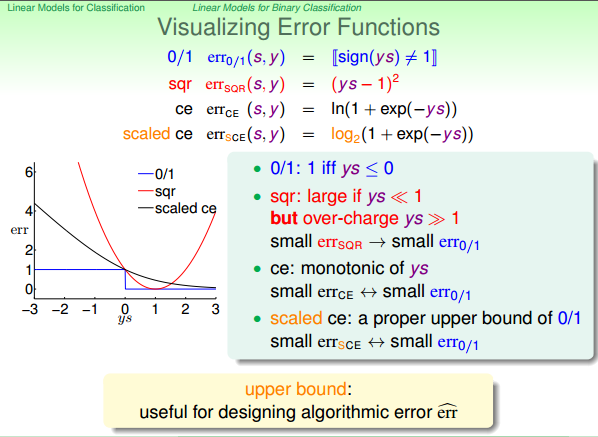

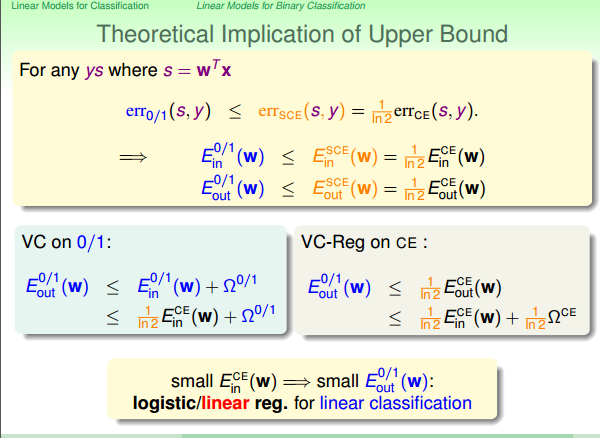

根据

linear classification的Eout上限被

linear regression和

logistic regression的上Ein所

bound住。所以可以利用两种

regression的误差函数来解决原问题。

解决步骤

实际工程中,对于二分类问题,一般采用:

用

linear regression找到初始的还不错的w0。

使用

logistic regression继续优化模型。

stochastic gradient descent

概述

这里就是简单的把连加去掉,但是理论上整体平均的方向仍然是梯度下降的方向。

PLA比较与建议

multiclass via Logistic Regression

图形

OVA

multiclass via Binary Classfication

总结

相关文章推荐

- ML基石_7_VC

- ML基石_8_NoiseAndError

- ML基石_9_LinearRegression

- ML基石_10_LogisticRegression

- ML基石_11_HazardOfOverfitting

- 《剑指Offer》面试题:寻找的连续序列的和等于某一定值

- 从机器学习谈起

- poj 1094

- 【IOS 开发学习总结-OC-46】★ios开发之UI控件——UIProgressView 与 UISlider(另:可拉伸图片)

- SpringMVC稳扎稳打(3)之拦截器

- js2次学习----常用知识点总结

- VS2008配置OpenGL

- Android中windowSoftInputMode属性详解

- Log4j使用方式详解

- 自学QT之获取目录下的全部文件并且添加到tablev中

- Hibernate反向工程使用心得

- swift知识点 [1]

- XMPP即时通讯

- Window窗口层次关系

- Android应用开发性能优化完全分析