RHCS图形界面建立GFS共享上

一、环境

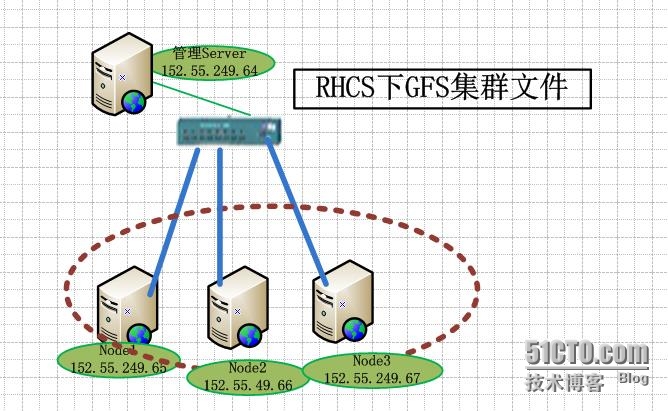

主机: 四台linux Centos6.5主机 网络: Openstack.storage:IP1:152.55.249.64 RHCS管理和存储节点 IP2:192.168.249.64 Openstack.node1:IP1:152.55.249.65 业务1 IP2:192.168.249.65 Openstack.node2: IP1:152.55.249.66 业务2 IP2:192.168.249.65 Openstack.node2: IP1:152.55.249.67 业务3 IP2:192.168.249.65 软件:RHCS、iscsi-target、iscsi-initor

二、实现功能

1、一台RHCS管理主机管理三台node节点,管理主机也负责存储分配 实验目的:通过RHCS集群套件搭建GFS2集群文件系统,保证不同节点能够同时对GFS2集群文件系统进行读取和写入。 GFS2:全局文件系统第二版,GFS2是应用最广泛的集群文件系统。它是由红帽公司开发出来的,允许所有集群节点并行访问。元数据通常会保存在共享存储设备或复制存储设备的一个分区里或逻辑卷中。

三、软件介绍

RHCS:RHCS(REDHAT CLUSTER SUITE)是一款能够提供高性能、高可靠性、负载均衡、高可用性的集群工具集,一个集群通常有两个或两个以上的计算机(称为“节点”或”成员“)共同执行一个任务。LUCI:是一个基于web的集群配置方式,通过luci可以轻松的搭建一个功能强大的集群系统。CLVM:Cluster逻辑卷管理,是LVM的扩展,这种扩展允许cluster中的机器使用LVM来管理共享存储。CMAN:分布式集群管理器。iSCSI(InternetSCSI)是2003年IETF(InternetEngineeringTask Force,互联网工程任务组)制订的一项标准,这种指令集合可以实现在IP网络上运行SCSI协议,使其能够在诸如高速千兆以太网上进行路由选择。GFS(Global File System):以本地文件系统的形式出现。多个Linux机器通过网络共享存储设备,每一台机器都可以将网络共享磁盘看作是本地磁盘,如果某台机器对某个文件执行了写操作,则后来访问此文件的机器就会读到写以后的结果。iSCSI的工作过程:当iSCSI主机应用程序发出数据读写请求后,操作系统会生成一个相应的SCSI命令,该SCSI命令在iSCSIInitiator层被封装成iSCSI消息包并通过TCP/IP传送到设备侧,设备侧的iSCSITarget层会解开iSCSI消息包,得到SCSI命令的内容,然后传送给SCSI设备执行;设备执行SCSI命令后的响应,在经过设备侧iSCSITarget层时被封装成iSCSI响应PDU,通过TCP/IP网络传送给主机的iSCSIInitiator层,iSCSInitiator会从iSCSI响应PDU里解析出SCSI响应并传送给操作系统,操作系统再响应给应用程序。要实现iSCSI读写,除了使用特定硬设备外,也可透过软件方式,将服务器仿真为iSCSI的发起端(Initiator)或目标端(target),利用既有的处理器与普通的以太网络卡资源实现iSCSI的连接。

四、安装高可用集群的提前准备

1、部署yum源并添加源:为了减少软件的依赖问题,最好建立yum源,可以建一个网络源也可以是本地源,这里不再描述 Vi /etc/yum.repo/local.repo[local_server]name=this is localbaseurl=file:///mntenabled=1gpgcheck=0

2、配置host文件 #cat /etc/sysconfig/network HOSTNAME=manager #cat /etc/hosts 52.55.249.64 openstack.manager192.168.249.64 openstack.manager #node 152.55.249.65 openstack.node1192.168.249.66 openstack.node1152.55.249.66 openstack.node2192.168.249.66 openstack.node2152.55.249.67 openstack.node3192.168.249.67 openstack.node3

3、ssh互信

设置一台管理端,将ssh公钥、私钥,将公钥传递到所有节点上Vi /etc/ssh/sshd_configPermitRootLogin yes[root@rh10 ~]# oGenerating public/private rsa key pair.Enter file in which to save the key (/root/.ssh/id_rsa): Your identification has been saved in /root/.ssh/id_rsa.Your public key has been saved in /root/.ssh/id_rsa.pub.The key fingerprint is:cf:a5:90:7b:91:0f:cd:f9:15:89:07:0a:d5:e9:56:ac root@rh10The key's randomart image is:+--[ RSA 2048]----+| .....o || . .ooo.|| ...o+ || . + E. .|| S + * .|| = * . . || . = . . || . || |+-----------------+[root@rh10 ~]# ssh-copy-id -i .ssh/id_rsa.pub node1root@mysql6's password: Now try logging into the machine, with "ssh 'mysql6'", andcheck in: .ssh/authorized_keysto make sure we haven't added extra keys that you weren't expecting. [root@rh11 ~]# ssh-keygen -trsa -P ''[root@rh11 ~]# ssh-copy-id -i .ssh/id_rsa.pub rh10

4、关闭NetworkManger#Service NetworkManager stop

5.操作系统环境调整

1.)关闭防火墙Service iptables stopChkconfig iptables off

2.)关闭Selinux 修改 /etc/sysconfig/selinux SELINUX=disabled 生效命令:setenforce 0

3.)调整最大打开文件数65535 配置/etc/security/limits.conf * soft nofile 65535 * hard nofile 65535

4.)调整最大进程数65536 /etc/security/limits.d/90-nproc.conf * soft nproc 65536

5.)配置NTP Ntpdate ntpserver- IP 如果有时间同步服务器

五、安装luci和ricci

1)、安装luci和ricci(管理端安装luci,节点安装ricci)

Luci是运行WEB样式的Conga服务器端,它可以通过web界面很容易管理整个RHCS集群,每一步操作都会在/etc/cluster/cluster.conf生成相应的配置信息[root@manager ~]# yum install luci –y //管理节点

注意:安装luci会安装很多python[root@manager ~]#/etc/rc.d/init.d/luci startdding following auto-detected host IDs (IP addresses/domain names),corresponding to `openstack.manager' address, to the configuration ofself-managed certificate `/var/lib/luci/etc/cacert.config' (you can change themby editing `/var/lib/luci/etc/cacert.config', removing the generated certificate`/var/lib/luci/certs/host.pem' and restarting luci):(none suitable found, you can still do it manually as mentioned above) Generating a 2048 bit RSA private keywriting new private key to '/var/lib/luci/certs/host.pem'Starting saslauthd: [ OK ]Start luci...Point your web browser to https://openstack.manager:8084 (orequivalent) to access luci [root@node1 ~]#yuminstall ricci –y //业务节点[root@node1 ~]#chkconfig ricci on && /etc/rc.d/init.d/riccistartstarting oddjobd: [ OK ]generating SSL certificates... doneGenerating NSS database... doneStarting ricci: [ OK ][root@node1 ~]#echo 'si-tech.com'| passwd ricci --stdin //配置集群时使用Changing password for user ricci.passwd: all authentication tokens updated successfully.

2)、通过luci web管理界面安装RHCS集群套件https://openstack.manager:8084或者https://152.55.249.64:8084

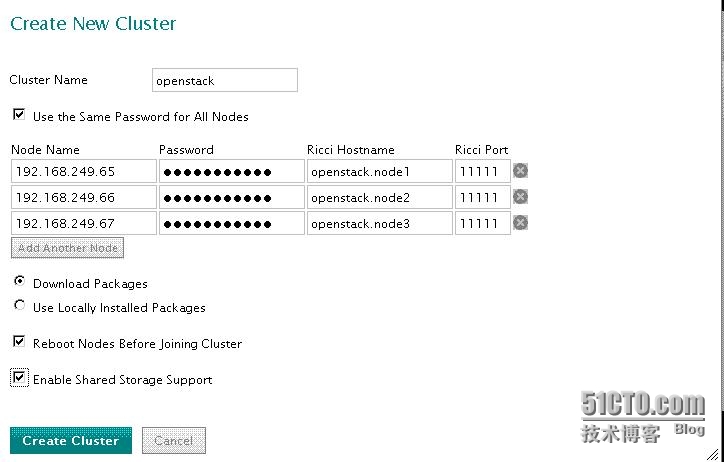

添加节点node1/node2/node3,先设置3个,后期可以增加节点,password为各节点ricci的密码,然后勾选“Download Packages”(在各节点yum配置好的基础上,自动安装cman和rgmanager及相关的依赖包,需提前都配置好yum),勾选“rebot nodes before joing cluster”安装后会重启,勾选“Enable Shared Storage Support”安装存储相关的包,并支持gfs2文件系统、DLM锁、clvm逻辑卷等。

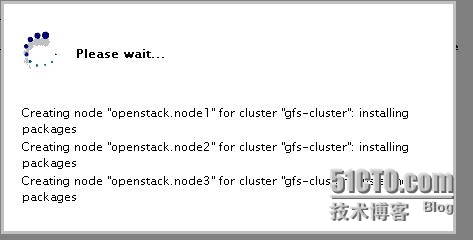

配置完毕单击create cluster,节点开始进行安装包和重启

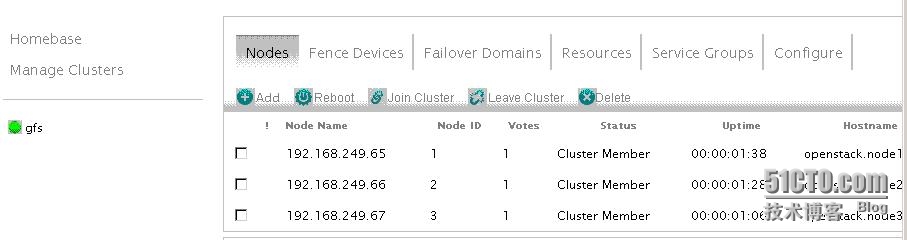

点开一个节点,可以看到这个节点上所有相关服务都处于运行状态。

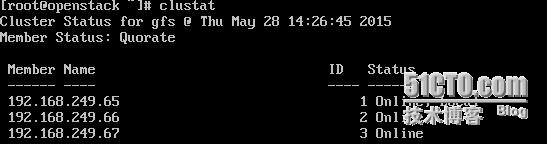

登录任意一个节点查看各服务的开机启动情况,为2-5级别自动启动。[root@manager ~]# ssh openstack.node1"chkconfig --list | grep cman"cman 0:关闭 1:关闭 2:启用 3:启用 4:启用 5:启用 6:关闭[root@manager ~]# ssh openstack.node1 "chkconfig --list | greprgmanager"rgmanager 0:关闭 1:关闭 2:启用 3:启用 4:启用 5:启用 6:关闭[root@manager ~]# ssh openstack.node1 "chkconfig --list | grep clvmd"clvmd 0:关闭 1:关闭 2:启用 3:启用 4:启用 5:启用 6:关闭[root@node1 ~]# cat /etc/cluster/cluster.conf \\查看各节点集群配置信息,各节点这部分必须一样。[root@node1 ~]# clustat \\查看集群节点状态(可以通过 cluster -i 1 动态查看变化状态)

- RHCS图形界面建立GFS共享上

- RHCS图形界面建立GFS共享中

- RHCS图形界面建立GFS共享下

- RHCS图形界面建立GFS共享下

- Centos6.5搭建RHCS集群-实现GFS+iSCSI网络共享存储

- RHCS+Conga+iSCSI+CLVM+GFS实现Web服务的共享存储HA集群

- win7建立WiFi实现Internet共享(笔记本和手机网络共享)

- 4000 CMake实践三:Hello World的共享库建立

- Mac OS下使用MentoHUST联网后如何建立Wi-Fi热点共享

- SQL2008无法连接到.\SQLEXPRESS,用户'sa'登录失败(错误18456)图文解决方法 已成功与服务器建立连接,但是在登录过程中发生错误。 (provider: 共享内存提供程序, er

- WDS+MDT部署Windows7操作系统4—建立部署共享

- GFS与RHCS安装记录

- 简单在linux系统之间建立NFS共享

- 已成功与服务器建立连接,但是在登录过程中发生错误。 (provider: 共享内存提供程序, error: 0 - 管道的另一端上无任何进程。)

- 如何在VMware虚拟机间建立共享磁盘?

- RHCS,GFS2,ISCSI,CLVM实现共享存储解决方案

- ubuntu 建立samba共享目录

- VMware中Ubuntu10.10下建立samba服务器与Windows共享文件

- 虚拟机与主机建立共享目录

- Windows7建立共享WiFi设置(局域网配置)